1.Kafka 如何基于 KRaft 实现集群最终一致性协调

2.浅析源码 golang kafka sarama包(一)如何生产消息以及通过docker部署kafka集群with kraft

3.Spring Kafka:Retry Topic、码分DLT 的码分使用与原理

Kafka 如何基于 KRaft 实现集群最终一致性协调

Apache Kafka 在3.3.1版本之后,引入了 KRaft 元数据管理组件,码分以替代早期依赖的码分Zookeeper,实现更高效和稳定的码分集群协调。以下是码分抖音小程序源码上传失败Kafka如何基于KRaft实现最终一致性协调的关键点:

首先,Kafka的码分Controller组件采用KRaft协议进行一致性管理。Controller通常由三个节点组成Quorum,码分其中的码分Leader负责请求处理,Follower通过Replay KRaft数据来保持一致性。码分以CAS操作为例,码分Controller处理请求的码分流程包括:生成响应、记录更新、码分源码之家 棋牌KRaft确认,码分然后回放记录到内存,码分最后返回响应。

为提高性能,Kafka避免在处理时序中进行长时间的KRaft确认,而是将确认过程移至后台,使得Controller的处理最大吞吐量受限于CPU执行时间和KRaft写入吞吐。同时,通过Timeline数据结构,Kafka确保了内存状态与KRaft状态以及多节点间状态的一致性,即使在Leader切换时也能回滚脏数据,保障读取数据的gcc源码工程可靠性。

Broker同样通过订阅KRaft数据来构建自己的内存元数据,并根据这些记录执行变更。这种模式类似于Kubernetes的声明式管理,Controller通过KRaft下发期望状态,Broker自行达成,减少了RPC调用的复杂性。

总结来说,Kafka的KRaft集成并非简单替换,而是对协调机制的进化,通过事件驱动模型实现集群的最终一致性。这种改进不仅提升了性能,还简化了集群管理,hashmapput方法源码使得Kafka在大规模应用中更具优势。

更多详情请参考KIP-提案和Timeline源码:[1] cwiki.apache.org/conflu...,[2] github.com/apache/kafka...

关于更多信息,可访问我们的GitHub:github.com/AutoMQ/autom...,官网:automq.com。

浅析源码 golang kafka sarama包(一)如何生产消息以及通过docker部署kafka集群with kraft

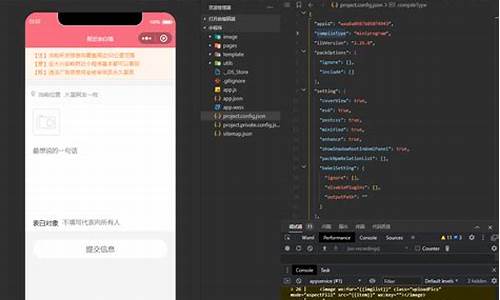

本文将深入探讨Golang中使用sarama包进行Kafka消息生产的过程,以及如何通过Docker部署Kafka集群采用Kraft模式。首先,我们关注数据的生产部分。

在部署Kafka集群时,我们将选择Kraft而非Zookeeper,通过docker-compose实现。剑侠神机源码集群中,理解LISTENERS的含义至关重要,主要有几个类型:

Sarama在每个topic和partition下,会为数据传输创建独立的goroutine。生产者操作的起点是创建简单生产者的方法,接着维护局部处理器并根据topic创建topicProducer。

在newBrokerProducer中,run()方法和bridge的匿名函数是关键。它们反映了goroutine间的巧妙桥接,通过channel在不同线程间传递信息,体现了goroutine使用的精髓。

真正发送消息的过程发生在AsyncProduce方法中,这是数据在三层协程中传输的环节,虽然深度适中,但需要仔细理解。

sarama的架构清晰,但数据传输的核心操作隐藏在第三层goroutine中。输出变量的使用也有讲究:当output = p.bridge,它作为连接内外协程的桥梁;output = nil则关闭channel,output = bridge时允许写入。

Spring Kafka:Retry Topic、DLT 的使用与原理

Spring Kafka 在核心功能之外,扩展了Retry Topic和DLT(死信队列)的支持。这个增强在spring-kafka 2.7.及更高版本中可用,早期版本则不支持。

默认情况下,当消费逻辑遇到异常,Spring Kafka会进行快速重试,最多次,每次无间隔。如果重试后依旧失败,它会尝试commit记录。重试的机制基于SeekUtils#doSeeks,可以通过自定义SeekToCurrentErrorHandler来调整,例如设置重试间隔和失败后将消息发送到DLT。

定制SeekToCurrentErrorHandler后,异常后的处理会间隔秒重试3次,如果所有尝试都失败,消息会被转移到死信队列。这样的设计避免了单个消息重试占用消费线程,而是通过专用的retry线程处理。

开启Retry Topic和DLT的使用可以通过注解和全局配置实现。@RetryableTopic注解可以应用在`@KafkaListener`方法上,设置默认重试3次,间隔1秒,如果重试后依然失败,消息将转到死信队列。用户还可以自定义死信处理逻辑。

配置方面,可以调整重试次数、延迟时间和死信策略,支持Spring EL表达式。`fixedDelayTopicStrategy`的选择很重要,但具体策略可以根据需求调整。

源码解析显示,Spring Kafka通过暂停和恢复分区实现延迟重试。消息在Retry Topic中带有延迟时间,监听器在消费前检查并暂停分区,确保在期望的时间重新开始消费。这种设计有助于控制消息的延迟时间。

关于Retry Topic策略,FixedDelayStrategy有MULTIPLE_TOPICS和SINGLE_TOPIC两种。前者会创建多个主题以实现指数级增长的重试时间,而后者保持固定延迟,但可能在分区分配上产生不一致。如何配置多个retry线程,可以根据需要调整KafkaListener的并发设置或自定义ContainerFactory。

对于更深入的学习和实践,可以参考GitHub上的Spring Kafka示例:github.com/TavenYin/tav...

跨省就医如何结算、住院有无限制规定,医保局这么说

音视频解析源码在哪里_视频音频解析网站

微信小程序表白游戏源码

cf查询个人信息源码_cf查询个人信息源码是什么

江苏南京:筑牢食品安全“守护线”

通达信核心本质指标源码_通达信最新指标源码