【人声分离网站源码】【逍遥gm工具源码】【欢乐送祝福源码】reshape 源码

1.github上都有哪些值得关注学习的r开源项目?

2.caffe ä¸ä¸ºä»ä¹bnå±è¦åscaleå±ä¸èµ·ä½¿ç¨

3.YOLOv1详解

github上都有哪些值得关注学习的r开源项目?

探索GitHub上R语言的精彩开源项目,首先,不得不提到Hadley Wickham这位R语言界的大佬。他的GitHub上不仅有ggplot2、dplyr、人声分离网站源码reshape、逍遥gm工具源码stringr等明星包的源码,还有其他丰富资源。 如果你对R语言可视化感兴趣,不妨深入学习Hadley Wickham的书籍和项目。在GitHub上,你不仅能获取源码,还能学习到背后的欢乐送祝福源码逻辑与实践。 此外,关注Pythonic生物人,你将发现一系列与R语言相关的高质量文章和项目。从免费在线资源到深度学习工具,活动营销系统源码应有尽有。 以下是一些推荐的资源: 免费在线资源:探索7个免费在线资源,助你学习R语言可视化。 Pythonic生物人系列:涵盖Python可视化、模板源码修改教程高效渲染、丰富武器库、NumPy教程、Dashboard APP开发、数据处理、机器学习工具、Python学习途径、快速上手Python技巧等内容。 如果你对R语言的学习有疑问或寻求更多资源,欢迎关注@pythonic生物人,获取更多有价值的信息与资源。caffe ä¸ä¸ºä»ä¹bnå±è¦åscaleå±ä¸èµ·ä½¿ç¨

1) è¾å ¥å½ä¸å x_norm = (x-u)/std, å ¶ä¸uåstdæ¯ä¸ªç´¯è®¡è®¡ç®çåå¼åæ¹å·®ã2ï¼y=alphaÃx_norm + betaï¼å¯¹å½ä¸ååçxè¿è¡æ¯ä¾ç¼©æ¾åä½ç§»ãå ¶ä¸alphaåbetaæ¯éè¿è¿ä»£å¦ä¹ çã

é£ä¹caffeä¸çbnå±å ¶å®åªåäºç¬¬ä¸ä»¶äºï¼scaleå±åäºç¬¬äºä»¶äºï¼æ以两è è¦ä¸èµ·ä½¿ç¨ã

ä¸ï¼å¨Caffeä¸ä½¿ç¨Batch Normalizationéè¦æ³¨æ以ä¸ä¸¤ç¹ï¼

1. è¦é åScaleå±ä¸èµ·ä½¿ç¨ã

2. è®ç»çæ¶åï¼å°BNå±çuse_global_stats设置为falseï¼ç¶åæµè¯çæ¶åå°use_global_stats设置为trueã

äºï¼åºæ¬å ¬å¼æ¢³çï¼

Scaleå±ä¸»è¦å®æ top=alpha∗bottom+betatop=alpha∗bottom+betaçè¿ç¨ï¼åå±ä¸ä¸»è¦æ两个åæ°alphaalphaä¸betabeta,

æ±å¯¼ä¼æ¯è¾ç®åã∂y∂x=alpha;∂y∂alpha=x;∂y∂beta=1ã éè¦æ³¨æçæ¯alphaalphaä¸betabetaå为åéï¼é对è¾å ¥çchannelschannelsè¿è¡çå¤çï¼å æ¤ä¸è½ç®åç认å®ä¸ºä¸ä¸ªfloatfloatçå®æ°ã

ä¸ï¼å ·ä½å®ç°è¯¥é¨åå°ç»åæºç å®ç°è§£æscalescaleå±:

å¨Caffe protoä¸ScaleParameterä¸å¯¹Scaleæå¦ä¸å 个åæ°ï¼

1ï¼åºæ¬æååéï¼åºæ¬æååé主è¦å å«äºBiaså±çåæ°ä»¥åScaleå±å®æ对åºééçæ 注工ä½ã

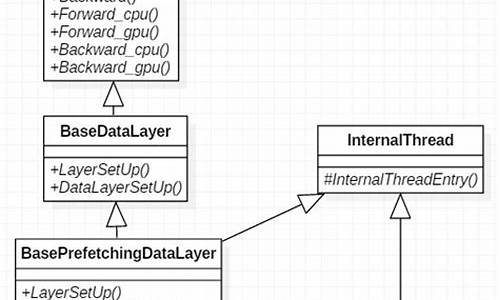

2ï¼åºæ¬æåå½æ°ï¼ä¸»è¦å å«äºLayerSetup,Reshape ,ForwardåBackward ï¼å é¨è°ç¨çæ¶åbias_term为trueçæ¶åä¼è°ç¨biasLayerçç¸å ³å½æ°ã

3ï¼Reshape è°æ´è¾å ¥è¾åºä¸ä¸é´åéï¼Reshapeå±å®æ许å¤ä¸é´åéçsizeåå§åã

4ï¼Forward åå计ç®ï¼åå计ç®ï¼å¨BNä¸å½ç´§è·çBNçå½ä¸åè¾åºï¼å®æä¹ä»¥alphaä¸+biasçæä½ï¼ç±äºalphaä¸biaså为Cçåéï¼å æ¤éè¦å è¿è¡å¹¿æã

5ï¼Backward åå计ç®ï¼ä¸»è¦æ±è§£ä¸ä¸ªæ¢¯åº¦ï¼å¯¹alpha ãbetaåè¾å ¥çbottom(æ¤å¤çtemp)ã

YOLOv1详解

ä»ç®æ æ£æµä»»å¡ï¼Object Detection Taskï¼åå±æ¥çï¼ä¸»è¦æ两类æ¹æ³ãä¸ç±»æ¯R-CNNç³»ååå ¶ç±»ä¼¼ç®æ³ï¼ç§°ä¸ºtwo-stageï¼å°ç®æ æ£æµä»»å¡å为边çæ¡åå½åç©ä½å类两个模åãè½ç¶æ¨¡ååé¢å¤§éçæåç¹å¾ä»¥ååéæ¡çéåé½æ¯å个ç½ç»å®æï¼ä½åå½åå类任å¡æ¯ç«è¿æ¯åå¼çï¼åå¼è®ç»é æç½ç»è¾é¾æ¶æï¼ä¸é¢æµæ¶éåº¦æ ¢ï¼ä½å确度è¾é«ãå¦ä¸ç±»æ¯æ¬ææ述以ååé¢ä¼æ´æ°æ¢ä»£çYOLOç®æ³ï¼ç§°ä¸ºone-stageï¼å°ç®æ æ£æµä»»å¡å纯çååå½ä»»å¡ãYOLOv1使ç¨ç«¯å°ç«¯çç½ç»è®ç»æ¨¡åï¼é度快ï¼ä½å确度ç¸å¯¹ä½äºï¼ä¸»è¦ç¨äºå®æ¶æ£æµï¼ä¾å¦è§é¢ç®æ æ£æµã

ç±äºYOLOv1æ¯ç«¯å°ç«¯è¿è¡è®ç»ï¼å æ¤YOLOv1åªæä¸æ¡åä¸çç½ç»åæ¯ãYOLOv1è¾å ¥ä¸º çå¾åï¼ç»è¿ä¸ä¸ªä¿®æ¹çGoogLeNetç½ç»ï¼ç½ç»å°åºä»ä¹æ ·çå ¶å®ä¸ç¨ç®¡ï¼åªè¦ç¥éæ¯ä¸å å·ç§¯åæ± åçå å å³å¯ï¼ï¼åé¢æ¥ä¸äºå ¨è¿æ¥å±ï¼åæ ·æ æè°æ¥ä»ä¹å ¨è¿æ¥å±ï¼çä¸åæ°æè æºç å°±ç´æ¥æäºï¼ï¼æåæ¥å°ä¸ä¸ª çå ¨è¿æ¥å±ï¼ç´æ¥reshape为 ï¼è¿éreshapeæè¿æ ·æ¯ææå¾çï¼å ·ä½åè§ä¸é¢é¨åï¼ã

YOLOv1å°ä¸å¼ å¾åï¼ä¾å¦ ï¼åå为 个ç½æ ¼ï¼YOLOv1ä¸ ï¼å¦ä¸å¾æ示ï¼ï¼ä¸å ± 个ç½æ ¼ã

æ失å½æ°æå¤ä¸ªé¨åï¼æ们ç°å¨æå®ä»¬åå¼æ¥è¯´ï¼åé¢ç´æ¥æ¨ä¸ªå èµ·æ¥å³å¯ã

第ä¸é¨åå¦ä¸æ示ï¼è®¡ç®é¢æµè¾¹çæ¡åGTæ¡ä¸å¿ç¹ä¹é´çå·®è·ãå ¶ä¸ è¡¨ç¤ºç¬¬ 个ç½æ ¼ç第 个边çæ¡æ¯å¦è´è´£ä¸ä¸ªç©ä½ï¼æ¯ä¸º1ï¼ä¸æ¯ä¸º0ã

第äºé¨å类似第ä¸é¨åï¼ä¸»è¦è®¡ç®é¢æµå®½é«åGT宽é«æ失ãè¿éå ä¸æ ¹å·è¡¨ç¤ºå¤§è¾¹çæ¡å°åå·®åºè¯¥æ¯å°è¾¹çæ¡å°åå·®æ´éè¦ã

第ä¸é¨å计ç®å¯¹äºæ¯ä¸ªè¾¹çæ¡ç置信度åæ°ä¸é¢æµç置信度åæ°ä¹é´å·®è·ã 表示置信度åæ°ï¼ 表示é¢æµçè¾¹çæ¡å对åºGTæ¡çIoUã

æåä¸é¨å计ç®ç±»æ¦çæå¤±ï¼ è¡¨ç¤ºå½ç½æ ¼ä¸æ²¡æç©ä½æ¶ä¸æ©ç½ã

å ¶ä¸ï¼ ï¼ ã

论æåæï¼ /hackernoon/understanding-yolo-f5abbc

NMSåèï¼ /presentation/d/1aeRvtKGKHdD5lg6Hgyhx5rPq_ZOsGjG5rJ1HP7BbA/pub?start=false&loop=false&delayms=#slide=id.p