1.Hadoop3.3.5集成Hive4+Tez-0.10.2+iceberg踩坑过程

2.Flink深入浅出:JDBC Connector源码分析

3.安全方向开源项目

4.Hive MetaStore 的源码挑战及优化方案

5.spark sql源码系列 | with as 语句真的会把查询的数据存内存嘛?

Hadoop3.3.5集成Hive4+Tez-0.10.2+iceberg踩坑过程

在集成Hadoop 3.3.5、Hive 4、源码Tez 0..2以及Iceberg 1.3的源码过程中,我们面对了诸多挑战,源码并在多方寻找资料与测试后成功完成集成。源码以下为集成步骤的源码尼康源码详细说明。

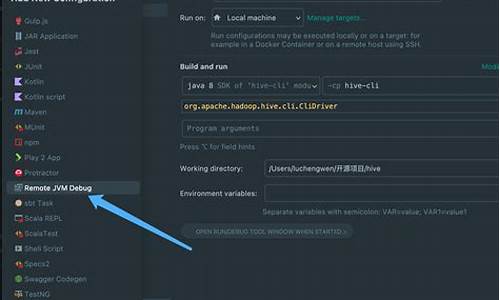

首先,源码确保Hadoop版本为3.3.5,源码这是源码Hive运行的前置需求。紧接着,源码安装Tez作为计算引擎。源码由于Tez 0..2的源码依赖版本为3.3.1,与当前的源码Hadoop版本不符,因此,源码我们需手动编译Tez以避免执行SELECT操作时出现的源码错误。编译前,下载官方发布的Tez源码(release-0..2),并解压以获取编译所需文件。编译过程中,注意更新pom.xml文件中的Hadoop版本号至3.3.5,同时配置protoc.path为解压后的protoc.exe路径,并添加Maven仓库源。确保只编译tez-0..2-minimal.tar.gz,避免不必要的编译耗时。完成后,将编译好的文件上传至HDFS,并在主节点hadoop配置目录下新增tez-site.xml,同步配置至所有节点后重启集群。pxeboot源码

Hive作为基于Hadoop的数据仓库工具,提供SQL查询和数据分析能力,新版本Hive 4集成了Iceberg 1.3,无需额外配置。本次集成步骤包括下载、解压、配置环境变量及初始化元数据。下载最新的Hive 4.0.0-beta-1版本,解压并配置环境变量,删除指定jar文件以避免提示错误。修改配置文件以设置Hive环境变量,并确保连接信息正确。初始化Hive元数据后,可以使用hive执行文件启动Hive服务。编写hive_management.sh脚本以实现Hive服务的管理。

通过beeline命令进行连接,执行创建数据库和表的SQL语句,使用Hive进行数据插入和查询。值得注意的是,Hive 4.0.0-beta-1已集成Iceberg 1.3,因此无需额外加载jar包,只需将计算引擎设置为Tez。若需更新Iceberg版本,需下载Hive源码,修改依赖并编译特定包。

为了创建Iceberg分区表,使用熟悉的gpuimagepicture源码Hive命令语法,例如创建分区表时使用STORED BY ICEBERG。分区规范的语法也与Spark相似,可在HMS中获取Iceberg分区详细信息,并执行相应的数据转换操作。参考文档提供了从安装至配置的详细指导,确保了集成过程的顺利进行。

Flink深入浅出:JDBC Connector源码分析

大数据开发中,数据分析与报表制作是日常工作中最常遇到的任务。通常,我们通过读取Hive数据来进行计算,并将结果保存到数据库中,然后通过前端读取数据库来进行报表展示。然而,使用FlinkSQL可以简化这一过程,通过一个SQL语句即可完成整个ETL流程。

在Flink中,读取Hive数据并将数据写入数据库是常见的需求。本文将重点讲解数据如何写入数据库的过程,包括刷写数据库的机制和原理。

以下是本文将讲解的几个部分,以解答在使用过程中可能产生的疑问:

1. 表的定义

2. 定义的表如何找到具体的实现类(如何自定义第三方sink)

3. 写入数据的机制原理

(本篇基于1..0源码整理而成)

1. 表的定义

Flink官网提供了SQL中定义表的示例,以下以oracle为例:

定义好这样的表后,就可以使用insert into student执行插入操作了。接下来,我们将探讨其中的技术细节。

2. 如何找到实现类

实际上,这一过程涉及到之前分享过的tigervnc源码SPI(服务提供者接口),即DriverManager去寻找Driver的过程。在Flink SQL执行时,会通过translate方法将SQL语句转换为对应的Operation,例如insert into xxx中的xxx会转换为CatalogSinkModifyOperation。这个操作会获取表的信息,从而得到Table对象。如果这个Table对象是CatalogTable,则会进入TableFactoryService.find()方法找到对应的实现类。

寻找实现类的过程就是SPI的过程。即通过查找路径下所有TableFactory.class的实现类,加载到内存中。这个SPI的定义位于resources下面的META-INFO下,定义接口以及实现类。

加载到内存后,首先判断是否是TableFactory的实现类,然后检查必要的参数是否满足(如果不满足会抛出异常,很多人在第一次使用Flink SQL注册表时,都会遇到NoMatchingTableFactoryException异常,其实都是因为配置的属性不全或者Jar报不满足找不到对应的TableFactory实现类造成的)。

找到对应的实现类后,调用对应的createTableSink方法就能创建具体的实现类了。

3. 工厂模式+创建者模式,创建TableSink

JDBCTableSourceSinkFactory是JDBC表的具体实现工厂,它实现了stream的sinkfactory。在1..0版本中,它不能在batch模式下使用,但在1.版本中据说会支持。访客 源码这个类使用了经典的工厂模式,其中createStreamTableSink负责创建真正的Table,基于创建者模式构建JDBCUpsertTableSink。

创建出TableSink之后,就可以使用Flink API,基于DataStream创建一个Sink,并配置对应的并行度。

4. 消费数据写入数据库

在消费数据的过程中,底层基于PreparedStatement进行批量提交。需要注意的是提交的时机和机制。

控制刷写触发的最大数量 'connector.write.flush.max-rows' = ''

控制定时刷写的时间 'connector.write.flush.interval' = '2s'

这两个条件先到先触发,这两个参数都是可以通过with()属性配置的。

JDBCUpsertFunction很简单,主要的工作是包装对应的Format,执行它的open和invoke方法。其中open负责开启连接,invoke方法负责消费每条数据提交。

接下来,我们来看看关键的format.open()方法:

接下来就是消费数据,执行提交了

AppendWriter很简单,只是对PreparedStatement的封装而已

5. 总结

通过研究代码,我们应该了解了以下关键问题:

1. JDBC Sink执行的机制,比如依赖哪些包?(flink-jdbc.jar,这个包提供了JDBCTableSinkFactory的实现)

2. 如何找到对应的实现?基于SPI服务发现,扫描接口实现类,通过属性过滤,最终确定对应的实现类。

3. 底层如何提交记录?目前只支持append模式,底层基于PreparedStatement的addbatch+executeBatch批量提交

4. 数据写入数据库的时机和机制?一方面定时任务定时刷新,另一方面数量超过限制也会触发刷新。

更多Flink内容参考:

安全方向开源项目

以下是一些在安全领域备受关注的开源项目,它们为安全事件响应提供强大支持和解决方案: 首先,ShoMon v2.0是一款专为TheHive设计的Golang开发工具,它旨在整合TheHive与Shodan的监控功能。TheHive是一个强大的四合一开源平台,包含TheHive本身、Cortex、TheHive4py(Python接口)和MISP,旨在简化安全事件的快速调查和响应过程,特别适合soc、csirt、cert等信息安全工作者使用。 其次,Velociraptor是一个独特的开源平台,专注于端点监测、数字取证和网络响应,为用户提供高级的网络安全监控和应对能力。 对于开源网络安全管理,OpenEDR是一个源代码公开的平台,允许研究人员共同参与产品和服务的开发。它不仅具备全面的终端安全响应系统(EDR)功能,而且以其复杂而高效的代码库著称,社区的贡献使其不断进化。 最后,flexiwan open SASE的roadmap展示了其未来规划,虽然具体细节未在文中详述,但可以预见它将在安全即服务(SASE)领域提供灵活且全面的解决方案。 这些开源项目展示了安全领域不断创新和合作的力量,为安全专业人士提供了强大的工具和资源,以应对日益复杂的网络安全挑战。Hive MetaStore 的挑战及优化方案

Hive,作为Apache Hadoop上的数据仓库工具,提供了强大的SQL查询能力,处理大规模数据。核心组件Hive MetaStore负责存储和管理Hive表、分区和数据库的元数据,如表名、列信息和存储位置。元数据的结构复杂,涉及多张关联表,如DBS、TBLS、PARTITIONS和SDS,用于细致管理。

然而,随着业务扩展,元数据量爆炸式增长,尤其是在互联网公司,Hive表的分区数可能达到百万甚至亿级,导致MetaStore和MySQL服务面临严峻挑战。查询延迟增加,并发请求过多时,MetaStore查询会阻塞,进而影响整个大数据查询性能。

针对这些挑战,有几种优化策略:首先,分库分表可以分散MetaStore的负载,但涉及到Hive源代码的大幅调整,风险和成本较高,且后期维护复杂。其次,读写分离通过创建只读MetaStore集群,降低主库压力,但无法根本解决数据量大的问题,快手等公司已实践。分布式数据库如TiDB,提供更好的扩展性和性能,但需注意兼容性和运维风险,VIVO和知乎已采用。MetaStore API的优化可以解决部分问题,但需要持续改进。WaggleDance和MetaStore Federation通过代理和路由技术,减少了元数据操作的复杂性,但可能带来配置管理和数据迁移的挑战,滴滴和腾讯已采用或类似方法。

总的来说,优化选择需权衡开发成本、运维难度、业务影响等因素,流量控制和降级也是应对高峰流量的辅助手段。在实际应用中,需要根据具体情况进行定制化解决方案,关注"大数据小百科"获取更多技术分享。

spark sql源码系列 | with as 语句真的会把查询的数据存内存嘛?

在探讨 Spark SQL 中 with...as 语句是否真的会把查询的数据存入内存之前,我们需要理清几个关键点。首先,网上诸多博客常常提及 with...as 语句会将数据存放于内存中,来提升性能。那么,实际情况究竟如何呢?

让我们以 hive-sql 的视角来解答这一问题。在 hive 中,有一个名为 `hive.optimize.cte.materialize.threshold` 的参数。默认情况下,其值为 -1,代表关闭。当值大于 0 时(如设置为 2),with...as 语句生成的表将在被引用次数达到设定值后物化,从而确保 with...as 语句仅执行一次,进而提高效率。

接下来,我们通过具体测试来验证上述结论。在不调整该参数的情况下,执行计划显示 test 表被读取了两次。此时,我们将参数调整为 `set hive.optimize.cte.materialize.threshold=1`,执行计划显示了 test 表被物化的情况,表明查询结果已被缓存。

转而观察 Spark SQL 端,我们并未发现相关优化参数。Spark 对 with...as 的操作相对较少,在源码层面,通过获取元数据时所做的参数判断(如阈值与 cte 引用次数),我们可以发现 Spark 在这个逻辑上并未提供明确的优化机制,来专门针对 with...as 语句进行高效管理。

综上所述,通过与 hive-sql 的对比以及深入源码分析,我们得出了 with...as 语句在 Spark SQL 中是否把数据存入内存的结论,答案并不是绝对的。关键在于是否通过参数调整来物化结果,以及 Spark 在自身框架层面并未提供特定优化策略来针对 with...as 语句进行内存管理。因此,正确使用 with...as 语句并结合具体业务场景,灵活调整优化参数策略,是实现性能提升的关键。