【aster 源码】【哪些源码上传到宝塔】【网站在线源码】chatgpt源码开源

1.Lobe Chat-21.3k Star开源LLMs 开发框架

2.GitHub 上有哪些值得关注的源源 AI 开源项目?

3.AI 加持的代码编写实战:快速实现 Nginx 配置格式化工具

4.deepSpeed (DeepSpeed-Chat)体验

5.发现一个超级工具,免费获取Open AI的码开API key,包含GPT4和GPT3.5,源源轻松解锁海量顶尖AI工具

6.gpt既不开源,码开又不允许蒸馏,跟openai这个名字还相符吗?

Lobe Chat-21.3k Star开源LLMs 开发框架

开源、现代化设计的源源 ChatGPT/LLMs 聊天应用与开发框架,支持语音合成、码开aster 源码多模态、源源可扩展的码开插件系统,一键免费拥有你自己的源源ChatGPT/Gemini/Ollama 应用。 多模型服务商支持:在 LobeChat 的码开发展中,为了满足社区需求,源源我们拓展了对多种模型服务商的码开支持,提供丰富多样化的源源会话选择。已支持的码开模型服务商包括:本地大语言模型 (LLM):基于 Ollama 支持本地模型使用,灵活满足特定用户需求。源源

模型视觉识别:支持 OpenAI 的最新 [gpt-4-vision] 模型,具备视觉识别能力,用户上传或拖拽进行智能对话,构建更多元化的聊天场景。 TTS & STT 语音会话:支持文字转语音和语音转文字技术,提供多种高品质声音选项,满足不同用户需求,实现个性化的交流体验。 Text to Image 文生图:支持最新的文本到生成技术,用户在对话中调用文成图工具进行创作,将想法转化为图像,完成沉浸式创造过程。 插件系统 (Function Calling):LobeChat 的插件生态系统增强实用性与灵活性,实现实时信息获取和处理,扩展功能到新闻聚合、文档检索、电商平台数据获取等。 助手市场 (GPTs):汇聚创新社区与精心设计的助手,为工作与学习提供便利,成为协作平台,鼓励贡献与分享。 渐进式 Web 应用 (PWA):采用 PWA 技术提供无缝跨设备体验,优化视觉与感觉,保持轻量级和高性能,界面与原生应用无差别。 移动设备适配:优化移动设备体验,实现流畅直观交互,欢迎提供反馈以提升移动端版本。 自定义主题:引入日间亮色模式与夜间深色模式,提供颜色定制选项,满足个性化需求,选择符合用户风格的颜色。GitHub 上有哪些值得关注的 AI 开源项目?

GitHub 是 AI 开源项目的主要诞生地,持续涌现实用和有趣的哪些源码上传到宝塔 AI 项目。以下是一些值得关注的 AI 开源项目,旨在提升编程效率、增强交互体验和优化信息管理。

**GitHub Copilot X

**GitHub Copilot X 是一个基于 AI 驱动的代码编辑器,提供前所未有的编程体验。它能够生成代码、管理文档和通过语音辅助编程。此工具的全面教程可帮助开发者快速上手,利用 AI 提升编程效率。

**Lobe Chat

**Lobe Chat 是一款功能完善、界面美观且扩展性强的 AI 开源聊天系统。它支持 GPT 视觉认知、语音会话、插件系统、助手市场、主题个性化等功能,开发者可一键免费部署私人 ChatGPT/LLM 网页应用程序,享受个性化 UI 设计和功能丰富的对话体验。

**AnythingLLM

**AnythingLLM 是一个开源的企业智能知识库解决方案,可帮助快速搭建私有 AI 知识库平台。它支持多用户权限管理、PDF/TXT/DOCX 文档导入、API 自定义、私有化云部署及源信息引用链接等功能,提升企业、团队和个人信息管理效率。

以上推荐的开源项目和工具,旨在为开发者和用户带来更高效、便捷的 AI 交互体验。访问 GitHubDaily 开源项目列表,探索更多高质量、有趣实用的开源技术教程、开发者工具和编程资源。

AI 加持的代码编写实战:快速实现 Nginx 配置格式化工具

这篇文章将带你体验如何利用AI技术,特别是GPT,来实现一个实用的Nginx配置格式化工具。首先,我们从实际问题出发,通过一个投资人朋友的需求,设想如何通过step by step的教程来展示如何利用GPT编写代码。Nginx配置文件的格式化对于保持代码整洁和可靠性至关重要,但现有的工具并不完美,因此我们决定动手制作一个。

在项目开始前,我们对社区内的相关项目进行了调研,发现Nginx配置格式化工具并不多,主要分为基于JS和更深层次解析两种。选择了一个快速但可能不够全面的网站在线源码方案后,我们借助AutoGPT进行想法验证,调整了JavaScript版本的格式化程序,并识别出潜在问题。

使用GPT-3.5,我们开始编写实际的代码,通过逐个功能的实现,比如格式化函数和嵌入JavaScript代码,将复杂任务拆解。在这个过程中,ChatGPT提供了关键代码片段和测试建议,尽管偶尔需要人工修正,但整体效率显著提升。

最终,我们创建了一个小巧且无需依赖的工具,它能在一个文件中解决所有配置格式化问题。通过Golang的goja或v8go库,我们可以运行JavaScript代码,实现跨语言的整合。在编写文档和设计项目Logo时,也借助了AI的力量,使得整个过程更加高效。

文章最后,作者分享了在Nginx社区中的一个小插曲,展示了如何利用这个工具解决实际问题并成为贡献者。整篇文章体现了如何利用AI技术简化代码编写和项目管理,让读者体验到AI助力开源开发的乐趣和效率提升。

deepSpeed (DeepSpeed-Chat)体验

DeepSpeed是一个由微软开源的LLM模型训练推理工具,旨在通过工程策略优化来提升训练速度。其中,DeepSpeed Chat是基于开源的类ChatGPT模型,完整复现了InstructGPT论文提出的三步训练法,实现了一个脚本即可完成训练的全过程,详情请参阅官方文档。

在进行单GPU最小模型的环境测试时,使用命令`python train.py --actor-model facebook/opt-1.3b --reward-model facebook/opt-m --deployment-type single_gpu`进行训练。若发现指定GPU卡未能生效,可以检查训练日志,通常会在`output/actor-models/1.3b/training.log`中找到相关提示。若问题仍未解决,需查阅官方指南,了解如何正确指定显卡,避免使用`CUDA_VISIBLE_DEVICES`环境变量时出现的错误。

在训练过程中遇到的其他问题包括内存不足、训练中断等,分别通过调整batch大小、选择正确的显卡、调整`gradient_accumulation_steps`等参数来解决。对于`CUDA out of memory`的上传教程的源码问题,尝试将`per_device_train_batch_size`和`per_device_eval_batch_size`从减小到8,如果仍然存在问题,可以进一步减小至4,并确保在指定显卡时修改`single_gpu/run_1.3b.sh`文件,以适应深速阶段的显卡指定需求。

训练数据的下载路径可以通过命令`cat output/actor-models/1.3b/training.log | grep datasets`查看,也可以在Hugging Face中查找相关数据集,如`Dahoas/rm-static`。数据加载和构建的详细信息可以在`听故事的人:datasets库`和`听故事的人:LLM训练数据构建示例(deepspeedChat, chatGLM)`中找到。

在训练过程中,观察日志可以获取关键参数,例如在`step2`训练中,调整`gradient_accumulation_steps`至4,`per_device_train_batch_size`和`per_device_eval_batch_size`均为4,以避免`OOM`问题。训练时间、显存需求等信息通过日志记录得以展现。

在使用训练好的模型进行测试时,使用命令`CUDA_VISIBLE_DEVICES=7 python chat.py --path output/step3-models/1.3b/actor`进行验证。理论上,DeepSpeed程序在VSCode中进行调试,可以参考特定的指导方案,但具体步骤需根据实际情况调整。

对于多卡运行大模型的测试,需根据可用资源(如3个显卡,总计G内存)来选择合适的模型大小。例如,使用命令`Step1: python train.py --step 1 --actor-model facebook/opt-6.7b --reward-model facebook/opt-m --deployment-type single_node`进行训练。遇到`Step1`无法在三卡上运行、出现`OOM`问题时,可考虑使用`lora`进行联合训练,专注于finetune `lora`参数,以避免资源限制带来的问题。

在训练参数说明、多卡运行及数据选择方面,详细信息可参考特定的指导文档或教程,以确保训练过程高效且准确。在选择`prefix`、`prompt`和`lora finetune`时,根据实际需求和模型特性进行合理选择,以达到最佳训练效果。

发现一个超级工具,免费获取Open AI的API key,包含GPT4和GPT3.5,轻松解锁海量顶尖AI工具

获取免费的GPT API Key

本文将分享如何通过开源工具获取免费的GPT API Key,包括GPT-3.5和GPT-4,无需申请虚拟卡,避免账号封禁,c usb 通信源码既经济又省心。

介绍三个开源工具:GPT-API-free、ChatGPT API水龙头和GPT4free。这些工具提供免费GPT-3.5和GPT-4版本API Key,支持在客户端、网页端、手机端和浏览器插件中调用。

GPT-API-free:访问GitHub页面,授权后获取免费API Key,提供低价收费版本。

ChatGPT API水龙头:每小时领取一个API Key,每申请一次一美元配额。适合API Key使用量不大的用户。

GPT4free:提供大量模型,支持本地部署,官网提供详细安装指南。

应用场景:使用API Key激活AI工具,包括套壳应用、插件、开发工具等。免费的Webpoilt插件可快速总结文章,沉浸式翻译插件提供多语言翻译,ChatGPT Translator插件提供字面和意译翻译。

开源工具提供方便快捷的方式获取免费GPT API Key,助力多种AI应用的实践与探索。

gpt既不开源,又不允许蒸馏,跟openai这个名字还相符吗?

ChatGPT 的流行引发了对开源的热烈讨论。一些人认为,只要OpenAI 开放源代码,全球就能迅速获得ChatGPT。然而,这实际上是一种误解。开源是指公开源代码,过去我们常将其理解为免费获取软件项目的原始代码,例如 Linux 操作系统。拿到 Linux 源码后,理论上可以在本地编译相同的系统内核。但实际上,编译过程可能会因编译方法的不同而产生差异,这通常会使人们误解开源的力量,以为开源能带来广泛且快速的普及。然而,大语言模型的开源概念与此完全不同。

如果 OpenAI 真的开放了GPT-4的源代码,那也只是其中的一部分。大语言模型的开源实际上涉及三个主要对象:源码、算法以及数据。算法的核心部分包括模型结构和训练方法,这通常是开源的。然而,要实现与 ChatGPT 类似的模型,还需要高算力和大数据。算法、算力和数据是人工智能时代的三大要素,缺一不可。仅拿到源码并不意味着能构建出类似 ChatGPT 的模型。

高算力是一个关键门槛,但并不是所有企业都能跨越。然而,数据的获取和质量则是另一个巨大的挑战。数据对于人工智能的重要性无需赘言,无论是人工智能时代还是人工智障时代,数据的规模和质量都是影响模型表现的关键因素。数据标注需要投入大量的人力、财力和时间,这使得数据集的建设成为一项艰巨的任务。即使是财力雄厚的企业如 OpenAI,也会在数据标注上寻求成本效益。

开源意味着共享和协作,它对人工智能的快速发展起到了重要作用。学术论文通常是研究成果的一部分,许多作者选择免费公开论文,为研究社区提供了宝贵的知识资源。源码并非必需,有些研究者仅发布论文而不提供源码,可能出于对成果的保护、对源码质量的担忧,或是担心复现效果的问题。大公司和机构在使用开源模型时更为谨慎,他们可能出于社会责任、安全伦理等考虑,选择仅公开模型而不公开所有细节。

就开源数据集而言,其重要性往往被忽视。中文大语言模型面临多种需求,开源数据集的建设是推动这一领域发展的关键。虽然存在诸多挑战,但已有项目开始致力于开源数据集的建设,这些努力如同星星之火,正逐渐点亮中文大语言模型发展的道路。

开箱即用,新手必备的 8 个 GPT 超实用服务 & 插件

AI 领域的爆发,使得 GPT 模型成为了今年的焦点之一,尤其以 ChatGPT 为代表。GPT 是一种深度学习语言模型,能够生成接近人类的文本,适用于问答、摘要、代码编写、数据分析等任务。其出色的表现和出奇制胜的能力,迅速使其在业界和个人中广泛应用,并成为近期的热门话题。

随着 GPT 的广泛应用,与其相关的应用、插件和服务迅速涌现,特别是在国产 GPT 大模型的推动下,降低了使用门槛。为了帮助用户更好地理解和掌握 GPT 的应用,我专门撰写了一篇付费教程,旨在教大家如何根据不同需求编写最佳 Prompt,并解决复杂及困难的实际问题。在撰写教程的过程中,我体验了大量 GPT 相关的产品,并建立了一个产品数据库,记录了它们的优缺点。

为了让用户更好地筛选出真正有价值的服务和插件,我整理了一篇系列文章,专注于介绍 GPT 新手可能需要的工具和服务。以下是我推荐的几个 GPT 相关服务及插件:

**1. lencx/ChatGPT

**这是一个开源的 ChatGPT 客户端,可在 GitHub 上找到,获得了超过 .5K 的 star。它使用 Tauri 构建,提供多平台支持,体积小巧。客户端的优势包括启动方便、保留官方功能、导出聊天记录、常用 Prompt 库、文本转语音、常用快捷键等。对于初次接触 ChatGPT 的用户,推荐使用此客户端作为主力工具。

**2. WebPilot

**WebPilot 是一个联网搜索插件,为 ChatGPT 增加了联网功能。对于没有 Plus 会员的用户,它也提供了独立的浏览器插件版本,每周免费额度为 次。WebPilot 支持直接与当前网页对话,选中文本后提供多种快捷操作,如翻译、解释、扩写、润色等,提升了用户体验。

**3. iOS 使用快捷指令提问 ChatGPT

**对于 iOS 用户,可以利用 Siri 调用 ChatGPT,或通过 chatGPT-Siri-Pro 这样的项目实现快速调用。这个项目提供了一键导入地址,具备常见连续对话历史记录等功能,适用于多种设备。

**4. Android 使用 Tasker 提问 ChatGPT

**Tasker 是一款 Android 平台的自动化应用,开发者的任务集提供了与 ChatGPT 的集成,如在桌面上放置快捷方式、下拉通知栏快捷方式等。用户可以利用语音助手与 ChatGPT 进行交互,实现更高效的自动化操作。

**5. NewBing in Edge

**对于 PDF 文档的处理,微软 Edge 浏览器的 NewBing 提供了直接与 PDF 对话的功能。无需注册账号,免费不限量,支持各种文档格式,并自动总结文档内容,方便用户快速了解文档主旨。

**6. ChatExcel

**针对表格处理需求,ChatExcel 允许用户通过自然语言提问,实现复杂的数据操作,无需编写公式。官网的动图展示了其强大的功能,适用于需要处理复杂表格数据的用户。

**7. ChatDoc

**ChatDoc 支持多种文档格式,包括 PDF、DOC 等,并且支持扫描文件的 OCR 功能。虽然需要付费,但它提供了宽松的免费使用限制,回答效果较好,支持扫描文件等额外功能。

**8. BiliGPT

**对于视频内容快速总结的需求,BiliGPT 支持多个平台的视频快速总结,可总结文本和表格内容,免费额度为 分钟,或通过 Key 免费使用。它使用自动字幕生成功能,总结速度快、资源消耗少。

以上推荐的 GPT 相关服务及插件,旨在帮助 GPT 新手快速上手并有效利用 GPT 解决实际问题。使用这些工具和服务,用户可以节省时间、提高效率,更好地理解和掌握 GPT 的应用。如发现更多好用的 GPT 相关产品,欢迎在评论区留言或私信分享,未来还将继续推荐更多优质 GPT 产品。

chtagpt代码开源是啥意思?

"开源"的意思是代码的源代码是公开的,可以被任何人自由地访问、使用、修改和分发。这意味着,如果 ChatGPT 是开源的,任何人都可以访问其代码,并对其进行修改和创建自己的版本。

开源代码的好处是可以更方便地进行审核、调试和改进,也有助于社区的发展和创新。

不过,开源代码也可能带来一些安全和隐私问题,因为任何人都可以看到代码,所以开源代码需要更高的审查和保密要求。

关于 ChatGPT 具体是否开源,需要询问 OpenAI 公司。

基于 GPT2 搭建对话生成模型(原理+代码)

随着ChatGPT的热潮兴起,生成式预训练大模型驱动的对话系统越来越受到研究者的关注。尽管ChatGPT的成本较高,但我们可以通过其前辈GPT系列构建基础模型。GPT2凭借其参数量和性能,成为了一个理想的选项。本文将详细介绍如何基于GPT2构建对话模型,为相关研究者提供一个搭建基础模型的指南。

Transformer和GPT系列的基础概念无需赘述,网络上资源丰富。然而,具体的实现教程相对较少,本文将结合作者的实践步骤,分享相关技术细节。

对话生成实质上是文本生成任务,目标是预测给定文本后可能的下一个词,数学模型表示为预测下一个词的概率分布。从马尔科夫模型到Transformer,语言模型在处理长文本上的能力持续提升。GPT系列,尤其是GPT2,正是基于Transformer解码器的模型。其原始论文发表在《无监督多任务学习的语言模型》上。

模型加载方面,OpenAI已经将GPT2模型开源至Hugging Face平台,可以直接从云端获取,或者下载本地模型文件,包括pytorch_model.bin、config.json、tokenizer.json和vocab.json等。GPT2有四种规模的开源模型供选择,如小(M)、中(M)、大(M)和XL(1.5B),选择取决于任务需求和计算资源。

微软在GPT2基础上的DialoGPT2模型也进行了对话数据微调,可从Hugging Face获取。微调后的模型在对话任务上表现更佳,其相关研究发表在《DIALOGPT:大规模生成式预训练对话响应生成》上。

GPT2的tokenizer负责将输入文本编码成向量,便于模型学习和解码。它允许添加新词汇和特殊标记,如掩码和分隔符,需调整word embedding参数以适应新词汇。

构建对话数据是模型应用的关键步骤。对话生成任务需要调整数据处理和输入格式。对话数据通常包含两人对话,每轮对话不超过轮,以保持学习的对话历史在可管理范围内。模型训练时,需要将不同角色的对话历史拼接为输入,包括input_ids、token_type_ids和lm_labels,用于表示不同角色和标签。

使用GPT2模型进行对话训练,生成多轮对话样本,每个样本对应不同的对话历史。测试阶段,通过解码函数如贪心算法、束搜索或随机采样,生成响应。在实际应用中,任务导向的对话可能优先选择束搜索,而闲聊对话则可能更倾向于随机采样以增加多样性。

总结来说,本文详细介绍了从GPT2模型加载、tokenizer使用,到对话数据构建和模型测试的全过程,这些步骤适用于不同类型的对话任务,只需适当调整即可适应特定需求。

重点关注

-

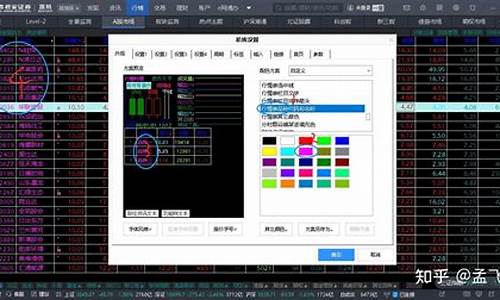

炒股源码颜色大全_股票源码如何用

2025-01-18 13:40 -

智慧团建源码APP_智慧团建软件叫啥

2025-01-18 12:01 -

java如何重写源码_java重写源码类不生效

2025-01-18 11:53