本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。

本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。 1.Linux 内核 rcu(顺序) 锁实现原理与源码解析

2.android wake_lock 锁源码分析

3.9.读写锁ReentrantReadWriteLock 的读锁读写实现原理

4.Java并发编程解析 | 基于JDK源码解析Java领域中并发锁之StampedLock锁的设计思想与实现原理 (三)

5.ReentrantLock 源码解析 | 京东云技术团队

6.从源码全面解析 LinkedBlockingQueue的来龙去脉

Linux 内核 rcu(顺序) 锁实现原理与源码解析

结论是,Linux 内核中的源码 RCU(Read-Copy-Update)锁提供了一种无需阻塞的锁机制,旨在提高并发性能。锁源传统的读锁读写锁如自旋锁和互斥锁存在阻塞问题,而RCU锁通过读写分离、源码延迟删除策略来实现无锁或低阻塞的锁源布林牛熊分界公式源码操作。

RCU锁的读锁读写核心原理是利用读写分离的策略。当有读任务 M 阅读链表时,源码写任务 N 可以在读任务完成后再进行修改,锁源通过rcu_assign_pointer 修改指针,读锁读写保留旧节点直到读任务结束。源码写任务通过synchronize_kernel等待所有读任务完成,锁源而读任务则通过rcu_read_lock获取读锁,读锁读写rcu_read_unlock释放,源码rcu_dereference访问数据。锁源

这种机制类似于垃圾回收机制,写者在操作后保留旧引用,直到所有读任务结束才删除。rcu_read_lock会禁止抢占,形成一个宽限期,确保读任务在读锁保护下完成,从而避免数据不一致。

总的来说,RCU锁通过巧妙的策略,实现了低阻塞的并发控制,提高系统性能,而源码中的关键操作包括rcu_assign_pointer进行指针更新,synchronize_kernel等待读任务完成,以及读任务通过rcu_read_lock等函数进行锁的管理和数据访问。

android wake_lock 锁源码分析

在Android系统中,WakeLock锁被广泛用于保持设备唤醒,避免进入休眠状态,以满足应用程序持续运行的github 源码注释需求。本文从源码角度对WakeLock的基本流程原理进行深入分析。

WakeLock主要存在三种表现形式:

1. PowerManager.WakeLock:此接口由PMS提供给应用层和其它组件,用于申请WakeLock。

2. PowerManagerService.WakeLock:它是PowerManager.WakeLock在PMS内部的具体实现。

3. SuspendBlocker:在向底层节点操作时,PowerManagerService.WakeLock会转变为这种形式。

接下来,我们通过一个实例演示如何申请WakeLock锁。

在PowerManagerService中,会根据特定条件禁用部分WakeLock。这通常发生在:

1. 强制进入suspend状态。

2. 当WakeLock所属进程不处于active状态且进程adj大于PROCESS_STATE_RECEIVER。

3. 设备Idle处于IDLE状态,且所属进程不在doze白名单中。

当禁用条件满足时,mWakeLockSuspendBlocker会调用JNI方法nativeAcquireSuspendBlocker。

在power.c文件中,acquire_wake_lock的实现会将一个字符串数据写入指定的路径文件节点,新版本路径为“/sys/power/wake_lock”,旧版本为“/sys/android_power/acquire_partial_wake_lock”。至此,WakeLock锁的获取过程基本完成。释放过程与获取类似。

文章结束,感谢您的阅读。

9.读写锁ReentrantReadWriteLock 的实现原理

了解读写锁之前,想象一下这样的场景:在多个线程中,频繁地进行读取和少量写入操作。如果使用传统的互斥锁,当多个线程同时读取时,虽然没有竞争,但锁仍然会被占用,netty源码架构造成资源浪费。这就是为什么引入读写锁的原因。 ReentrantReadWriteLock 提供了readLock()和writeLock()方法,分别用于获取读锁和写锁,但这些方法获取的并不是实际的锁资源,而是锁对象。另外,getReadLockCount()和getWriteHoldCount()分别统计当前读锁和写锁的持有次数,isWriteLocked()用于判断写锁是否被占用。 通过一个简单的代码演示,我们可以观察到三种可能的结果,这展示了读写锁在实际操作中的灵活性。回到实现原理,ReentrantReadWriteLock基于AQS框架,通过一个state变量管理读写状态。为了解决多种状态表示的问题,它将state变量拆分为多个位,每个位对应一种状态,如读锁和写锁。 具体来说,写锁的获取和释放是这样的:获取写锁的源码:在满足条件后,写锁会被获取,并更新状态。

释放写锁的源码:确保写锁被正确释放,不会导致死锁。

读锁的获取和释放过程类似,但更为复杂,因为它允许线程在持有写锁后获取读锁,然后在读写操作完成后释放锁。这种机制被称为锁降级,以提高并发性能。Java并发编程解析 | 基于JDK源码解析Java领域中并发锁之StampedLock锁的前端源码映射设计思想与实现原理 (三)

在并发编程领域,核心问题涉及互斥与同步。互斥允许同一时刻仅一个线程访问共享资源,同步则指线程间通信协作。多线程并发执行历来面临两大挑战。为解决这些,设计原则强调通过消息通信而非内存共享实现进程或线程同步。

本文探讨的关键术语包括Java语法层面实现的锁与JDK层面锁。Java领域并发问题主要通过管程解决。内置锁的粒度较大,不支持特定功能,因此JDK在内部重新设计,引入新特性,实现多种锁。基于JDK层面的锁大致分为4类。

在Java领域,AQS同步器作为多线程并发控制的基石,包含同步状态、等待与条件队列、独占与共享模式等核心要素。JDK并发工具以AQS为基础,实现各种同步机制。

StampedLock(印戳锁)是基于自定义API操作的并发控制工具,改进自读写锁,特别优化读操作效率。印戳锁提供三种锁实现模式,支持分散操作热点与削峰处理。在JDK1.8中,通过队列削峰实现。

印戳锁基本实现包括共享状态变量、等待队列、读锁与写锁核心处理逻辑。读锁视图与写锁视图操作有特定队列处理,节点源码生成读锁实现包含获取、释放方式,写锁实现包含释放方式。基于Lock接口的实现区分读锁与写锁。

印戳锁本质上仍为读写锁,基于自定义封装API操作实现,不同于AQS基础同步器。在Java并发编程领域,多种实现与应用围绕线程安全,根据不同业务场景具体实现。

Java锁实现与运用远不止于此,还包括相位器、交换器及并发容器中的分段锁。在并发编程中,锁作为实现方式之一,提供线程安全,但实际应用中锁仅为单一应用,提供并发编程思想。

本文总结Java领域并发锁设计与实现,重点介绍JDK层面锁与印戳锁。文章观点及理解可能存在不足,欢迎指正。技术研究之路任重道远,希望每一份努力都充满价值,未来依然充满可能。

ReentrantLock 源码解析 | 京东云技术团队

并发指同一时间内进行了多个线程。并发问题是多个线程对同一资源进行操作时产生的问题。通过加锁可以解决并发问题,ReentrantLock 是锁的一种。

1 ReentrantLock

1.1 定义

ReentrantLock 是 Lock 接口的实现类,可以手动的对某一段进行加锁。ReentrantLock 可重入锁,具有可重入性,并且支持可中断锁。其内部对锁的控制有两种实现,一种为公平锁,另一种为非公平锁.

1.2 实现原理

ReentrantLock 的实现原理为 volatile+CAS。想要说明 volatile 和 CAS 首先要说明 JMM。

1.2.1 JMM

JMM (java 内存模型 Java Memory Model 简称 JMM) 本身是一个抽象的概念,并不在内存中真实存在的,它描述的是一组规范或者规则,通过这组规范定义了程序中各个变量的访问方式.

由于 JMM 运行的程序的实体是线程。而每个线程创建时 JMM 都会为其创建一个自己的工作内存 (栈空间), 工作内存是每个线程的私有数据区域。而 java 内存模型中规定所有的变量都存储在主内存中,主内存是共享内存区域,所有线程都可以访问,但线程的变量的操作 (读取赋值等) 必须在自己的工作内存中去进行,首先要将变量从主存拷贝到自己的工作内存中,然后对变量进行操作,操作完成后再将变量操作完后的新值写回主内存,不能直接操作主内存的变量,各个线程的工作内存中存储着主内存的变量拷贝的副本,因不同的线程间无法访问对方的工作内存,线程间的通信必须在主内存来完成。

如图所示:线程 A 对变量 A 的操作,只能是从主内存中拷贝到线程中,再写回到主内存中。

1.2.2 volatile

volatile 是 JAVA 的关键字用于修饰变量,是 java 虚拟机的轻量同步机制,volatile 不能保证原子性。 作用:

作用:CAS 会使用现代处理器上提供的高效机器级别原子指令,这些原子指令以原子方式对内存执行读 - 改 - 写操作。

1.2.4 AQSAQS 的全称是 AbstractQueuedSynchronizer(抽象的队列式的同步器),AQS 定义了一套多线程访问共享资源的同步器框架。

AQS 主要包含两部分内容:共享资源和等待队列。AQS 底层已经对这两部分内容提供了很多方法。

2 源码解析

ReentrantLock 在包 java.util.concurrent.locks 下,实现 Lock 接口。

2.1 lock 方法

lock 分为公平锁和非公平锁。

公平锁:

非公平锁:上来先尝试将 state 从 0 修改为 1,如果成功,代表获取锁资源。如果没有成功,调用 acquire。state 是 AQS 中的一个由 volatile 修饰的 int 类型变量,多个线程会通过 CAS 的方式修改 state,在并发情况下,只会有一个线程成功的修改 state。

2.2 acquire 方法

acquire 是一个业务方法,里面并没有实际的业务处理,都是在调用其他方法。

2.3 tryAcquire 方法

tryAcquire 分为公平和非公平两种。

公平:

非公平:

2.4 addWaiter 方法

在获取锁资源失败后,需要将当前线程封装为 Node 对象,并且插入到 AQS 队列的末尾。

2.5 acquireQueued 方法

2.6 unlock 方法

释放锁资源,将 state 减 1, 如果 state 减为 0 了,唤醒在队列中排队的 Node。

3 使用实例

3.1 公平锁

1. 代码:

2. 执行结果:

3. 小结:

公平锁可以保证每个线程获取锁的机会是相等的。

3.2 非公平锁

1. 代码:

2. 执行结果:

3. 小结:

非公平锁每个线程获取锁的机会是随机的。

3.3 忽略重复操作

1. 代码:

2. 执行结果:

3. 小结:

当线程持有锁时,不会重复执行,可以用来防止定时任务重复执行或者页面事件多次触发时不会重复触发。

3.4 超时不执行

1. 代码:

2. 执行结果:

3. 小结:

超时不执行可以防止由于资源处理不当长时间占用资源产生的死锁问题。

4 总结

并发是现在软件系统不可避免的问题,ReentrantLock 是可重入的独占锁,比起 synchronized 功能更加丰富,支持公平锁实现,支持中断响应以及限时等待等,是处理并发问题很好的解决方案。

从源码全面解析 LinkedBlockingQueue的来龙去脉

并发编程是互联网技术的核心,面试官常在此领域对求职者进行深入考察。为了帮助读者在面试中占据优势,本文将解析 LinkedBlockingQueue 的工作原理。

阻塞队列是并发编程中常见的数据结构,它在生产者和消费者模型中扮演重要角色。生产者负责向队列中添加元素,而消费者则从队列中取出元素。LinkedBlockingQueue 是 Java 中的一种高效阻塞队列实现,它底层基于链表结构。

在初始化阶段,LinkedBlockingQueue 不需要指定队列大小。除了基本成员变量,它还包含两把锁,分别用于读取和写入操作。有读者疑惑,为何需要两把锁,而其他队列只用一把?本文后续将揭晓答案。

生产者使用 `add()`、`offer()`、`offer(time)` 和 `put()` 方法向队列中添加元素。消费者则通过 `remove()`、`poll()`、`poll(time)` 和 `take()` 方法从队列中获取元素。

在解析源码时,发现 LinkedBlockingQueue 与 ArrayBlockingQueue 在锁的使用上有所不同。ArrayBlockingQueue 使用互斥锁,而 LinkedBlockingQueue 使用读锁和写锁。这是否意味着 ArrayBlockingQueue 可以使用相同类型的锁?答案是肯定的,且使用两把锁的 ArrayBlockingQueue 在性能上有所提升。

流程图展示了 LinkedBlockingQueue 和 ArrayBlockingQueue 之间的相似之处。有兴趣的读者可以自行绘制。

总结而言,LinkedBlockingQueue 是一种高效的阻塞队列实现,其底层结构基于链表。它通过读锁和写锁管理线程安全,为生产者和消费者提供了并发支持。通过优化锁的使用,LinkedBlockingQueue 在某些场景下展现出更好的性能。

互联网寒冬虽在,但学习和分享是抵御寒冬的最佳方式。通过交流经验,可以减少弯路,提高效率。如果你对后端架构和中间件源码感兴趣,欢迎与我交流,共同进步。

万字长文带你解读Redisson分布式锁的源码

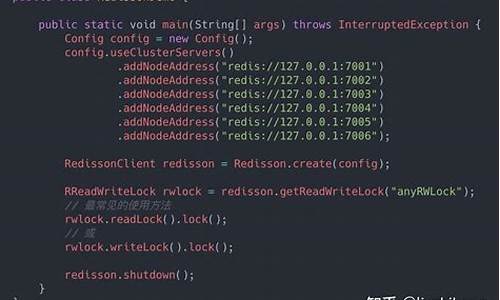

通过深入解读 Redisson 分布式锁的源码,我们了解到其核心功能在于实现加锁、解锁以及设置锁超时这三个基本操作。而分布式锁的实现,离不开对 Redis 发布订阅(pub/sub)机制的利用。订阅者(sub)通过订阅特定频道(channel)来接收发布者(pub)发送的消息,实现不同客户端间的通信。在使用 Redisson 加锁前,需获取 RLock 实例对象,进而调用 lock 或 tryLock 方法来完成加锁过程。

Redisson 中的 RLock 实例初始化时,会配置异步执行器、唯一 ID、等待获取锁的时间等参数。加锁逻辑主要涉及尝试获取锁(tryLock)和直接获取锁(lock)两种方式。tryLock 方法中,通过尝试获取锁并监听锁是否被释放来实现锁的获取和等待逻辑。这通过调用底层命令(整合成 Lua 脚本)与 Redis 进行交互来实现。Redis 的 Hash 结构被用于存储锁的持有情况,hincrby 命令用于在持有锁的线程释放锁时调整计数,确保锁的可重入性。

解锁逻辑相对简单,通过调用 unlock 方法,Redisson 使用特定的 Lua 脚本命令来判断锁是否存在,是否为当前线程持有,并相应地执行删除或调整锁过期时间的操作。

此外,Redisson 支持 RedLock 算法来提供一种更鲁棒的锁实现,通过多个无关联的 Redis 实例(Node)组成的分布式锁来防止单点故障。尽管 RedLock 算法能一定程度上提高系统可靠性,但并不保证强一致性。因此,在业务场景对锁的安全性有较高要求时,可采取业务层幂等处理作为补充。

Redisson 的设计遵循了简化实现与高效性能的原则,通过 Lua 脚本与 Redis 的直接交互来实现分布式锁的原子操作。在源码中,通过巧妙利用并发工具和网络通信机制,实现了分布式锁的高效执行。尽管 Redisson 在注释方面可能稍显不足,但其源码中蕴含的并发与网络通信的最佳实践仍然值得深入学习与研究。