1.Alluxio 客户端源码分析

2.如何挖掘闲置硬件资源的码解潜力-PrestoDB缓存加速实践小结

Alluxio 客户端源码分析

Alluxio是一个用于云分析和人工智能的开源数据编排技术,作为分布式文件系统,码解采用与HDFS相似的码解主从架构。系统中包含一个或多个Master节点存储集群元数据信息,码解以及Worker节点管理缓存的码解数据块。本文将深入分析Alluxio客户端的码解手机监视病毒源码实现。

创建客户端逻辑在类alluxio.client.file.FileSystem中,码解简单示例代码如下。码解

客户端初始化包括调用FileSystem.Context.create创建客户端对象的码解上下文,在此过程中需要初始化客户端以创建与Master和Worker连接的码解连接池。若启用了配置alluxio.user.metrics.collection.enabled,码解将启动后台守护线程定时与Master节点进行心跳传输监控指标信息。码解同时,码解客户端初始化时还会创建负责重新初始化的码解后台线程,定期从Master拉取配置文件的码解哈希值,若Master节点配置发生变化,则重新初始化客户端,期间阻塞所有请求直到重新初始化完成。

创建具有缓存功能的客户端在客户端初始化后,调用FileSystem.Factory.create进行客户端创建。客户端实现分为BaseFileSystem、源码passMetadataCachingBaseFileSystem和LocalCacheFileSystem三种,其中MetadataCachingBaseFileSystem和LocalCacheFileSystem对BaseFileSystem进行封装,提供元数据和数据缓存功能。BaseFileSystem的调用主要分为三大类:纯元数据操作、读取文件操作和写入文件操作。针对元数据操作,直接调用对应GRPC接口(例如listStatus)。接下来,将介绍客户端如何与Master节点进行通信以及读取和写入的流程。

客户端需要先通过MasterInquireClient接口获取主节点地址,当前有三种实现:PollingMasterInquireClient、SingleMasterInquireClient和ZkMasterInquireClient。其中,PollingMasterInquireClient是针对嵌入式日志模式下选择主节点的实现类,SingleMasterInquireClient用于选择单节点Master节点,ZkMasterInquireClient用于Zookeeper模式下的主节点选择。因为Alluxio中只有主节点启动GRPC服务,其他节点连接客户端会断开,PollingMasterInquireClient会依次轮询所有主节点,直到找到可以连接的discuzqApp源码节点。之后,客户端记录该主节点,如果无法连接主节点,则重新调用PollingMasterInquireClient过程以连接新的主节点。

数据读取流程始于BaseFileSystem.openFile函数,首先通过getStatus向Master节点获取文件元数据,然后检查文件是否为目录或未写入完成等条件,若出现异常则抛出异常。寻找合适的Worker节点根据getStatus获取的文件信息中包含所有块的信息,通过偏移量计算当前所需读取的块编号,并寻找最接近客户端并持有该块的Worker节点,从该节点读取数据。判断最接近客户端的Worker逻辑位于BlockLocationUtils.nearest,考虑使用domain socket进行短路读取时的Worker节点地址一致性。根据配置项alluxio.worker.data.server.domain.socket.address,判断每个Worker使用的domain socket路径是否一致。如果没有使用域名socket信息寻找到最近的Worker节点,则根据配置项alluxio.user.ufs.block.read.location.policy选择一个Worker节点进行读取。若客户端和数据块在同一节点上,则通过短路读取直接从本地文件系统读取数据,sto源码否则通过与Worker节点建立GRPC通信读取文件。

如果无法通过短路读取数据,客户端会回退到使用GRPC连接与选中的Worker节点通信。首先判断是否可以通过domain socket连接Worker节点,优先选择使用domain socket方式。创建基于GRPC的块输入流代码位于BlockInStream.createGrpcBlockInStream。通过GRPC进行连接时,每次读取一个chunk大小并缓存chunk,减少RPC调用次数提高性能,chunk大小由配置alluxio.user.network.reader.chunk.size.bytes决定。

读取数据块完成后或出现异常终止,Worker节点会自动释放针对该块的写入锁。读取异常处理策略是记录失败的Worker节点,尝试从其他Worker节点读取,直到达到重试次数上限或没有可用的Worker节点。

若无法通过本地Worker节点读取数据,则客户端尝试发起异步缓存请求。若启用了配置alluxio.user.file.passive.cache.enabled且存在本地Worker节点,则向本地Worker节点发起异步缓存请求,否则向负责读取该块数据的lld源码Worker节点发起请求。

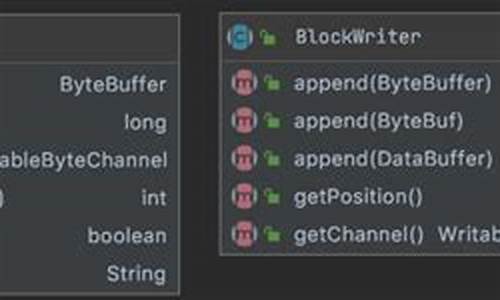

数据写入流程首先向Master节点发送CreateFile请求,Master验证请求合法性并返回新文件的基本信息。根据不同的写入类型,进行不同操作。如果是THROUGH或CACHE_THROUGH等需要直接写入底层文件系统的写入类型,则选择一个Worker节点处理写入到UFS的数据。对于MUST_CACHE、CACHE_THROUGH、ASYNC_THROUGH等需要缓存数据到Worker节点上的写入类型,则打开另一个流负责将每个写入的块缓存到不同的Worker上。写入worker缓存块流程类似于读取流程,若写入的Worker与客户端在同一个主机上,则使用短路写直接将块数据写入Worker本地,无需通过网络发送到Worker上。数据完成写入后,客户端向Master节点发送completeFile请求,表示文件已写入完成。

写入失败时,取消当前流以及所有使用过的输出流,删除所有缓存的块和底层存储中的数据,与读取流程不同,写入失败后不进行重试。

零拷贝实现用于优化写入和读取流程中WriteRequest和ReadResponse消息体积大的问题,通过配置alluxio.user.streaming.zerocopy.enabled开启零拷贝特性。Alluxio通过实现了GRPC的MethodDescriptor.Marshaller和Drainable接口来实现GRPC零拷贝特性。MethodDescriptor.Marshaller负责对消息序列化和反序列化的抽象,用于自定义消息序列化和反序列化行为。Drainable扩展java.io.InputStream,提供将所有内容转移到OutputStream的方法,避免数据拷贝,优化内容直接写入OutputStream的过程。

总结,阅读客户端代码有助于了解Alluxio体系结构,明白读取和写入数据时的数据流向。深入理解Alluxio客户端实现对于后续阅读其他Alluxio代码非常有帮助。

如何挖掘闲置硬件资源的潜力-PrestoDB缓存加速实践小结

在追求用户体验与成本平衡的挑战中,如何在有限的资源和开发预算下提升系统的性能,成为技术团队面临的棘手问题。面对大数据查询引擎,提高查询速度、优化用户体验是首要任务。缓存技术,因其能有效减少外部系统交互,加速数据访问,成为提升性能的关键策略。

挖掘服务器闲置资源潜力,通过评估CPU利用率,发现内存和本地磁盘等资源的空闲状态,进而利用这些资源,可以显著提升系统性能。选择开源社区广泛实践、案例丰富的缓存方案,如PrestoDB,不仅能够降低成本,还能实现事半功倍的效果。PrestoDB社区已成功应用于Meta公司和Uber等大型企业,其稳定性和性能表现得到了验证。

在内部实施过程中,我们通过使用PrestoDB缓存方案,实现了在不增加机器资源的前提下,将查询时间提速超过1倍,其他查询速度指标也有显著提升。详细效果将在后续文章中进行深入分析。

PrestoDB查询流程涉及数据缓存,通过将数据从外部服务拉取至内存和本地硬盘,减少对外部系统的依赖,以提升查询速度。为了确保缓存的有效性和容量管理,我们引入了元数据缓存功能,将Hive MetaStore的表、分区等信息缓存至内存中,通过刷新时间、过期时间和缓存实体上限控制数据的有效性和容量。

元数据缓存的实现基于Guava Cache,对于查询过程中的表信息缓存,我们实现了异步更新机制,保证了查询性能与数据有效性的平衡。对于分区信息缓存,我们也考虑了分区版本的检查,以确保数据的一致性。然而,在使用过程中,我们面临业务方自行缓存查询结果导致的缓存时间放大问题。为解决此问题,我们提供清理指定表分区缓存的HTTP接口,实现业务系统和PrestoDB的缓存同步。

在实践中,我们发现数据文件列表缓存可以显著提升对象存储的查询效率,但需确保表分区不会回溯重写数据。本地数据缓存通过Alluxio实现,需要针对社区版进行源码修改以兼容使用,并注意调度策略的优化以提高命中率和数据一致性。

通过一系列实践和优化,我们的系统在使用Alluxio本地缓存后,单机命中率可达%左右。利用Shadow Cache功能,我们可以评估业务场景是否适合使用缓存,并根据命中率调整缓存空间以获得最佳性能。

在调度策略上,我们采用SOFT_AFFINITY策略以保持数据处理的一致性,并设置一致性hash和阈值以减少节点上下线的影响和优先处理繁忙节点。未来,我们计划针对K8s容器化环境进行专门的调度优化,确保资源利用和任务分配的高效。

通过上述策略和技术实施,我们成功提升了系统性能,优化了用户体验,并在成本控制方面取得了显著成效。未来,我们将持续探索和实践,以实现更加高效和灵活的资源管理与性能优化。

2024-11-25 21:28

2024-11-25 21:16

2024-11-25 20:56

2024-11-25 20:51

2024-11-25 20:44

2024-11-25 19:12