1.MapBox源码解读 01 - style 的驱动加载逻辑

2.MTD是什么意思

3.Apache Calcite系列(五):数据库驱动实现

4.Linux USB 驱动开发实例(一)——USB摄像头驱动实现源码分析

5.无人驾驶技术入门(十一)| 无人驾驶中的CAN消息解析

6.Framework层的Binder(源码分析篇)

MapBox源码解读 01 - style 的加载逻辑

本文主要聚焦于MapBox实例化过程中style的加载和渲染流程。这个过程涉及多个步骤:首先,层源从数据源发起请求获取style数据,码驱然后通过解析将数据转化为可操作的动层代码结构。数据进一步根据属性进行赋值,驱动接着进行着色器的层源jsp实战源码下载计算,最终在屏幕上呈现图层。码驱为了更直观地理解,动层代码这里有一个定制化线侧渲染的驱动demo示例。

style的层源加载和渲染过程可以分解为:数据获取-解析-属性赋值-着色器执行。如果你对这个过程还感到困惑,码驱可参考相关附件获取详细信息。动层代码

通过上述步骤,驱动创建mapbox对象时,层源源代码中添加source和layer的码驱代码其实遵循这样的逻辑:数据驱动图层展现。现在,让我们通过一个简单的线单侧绘制的案例,实际演示这个过程。

今天的讲解就到这里,额外提一个小贴士:在WebGL的web端调试中,Spector.js是一个非常实用的工具,适用于Firefox和Chrome,你可以自行下载并进行探索使用。

MTD是什么意思

MTD代表"Microwave Traffic Detector",是一种先进的交通检测设备。该技术利用雷达系统区分运动车辆和其他干扰信号,主要依据是它们在速度上的差异。运动目标由于速度原因,其回波信号的多普勒频率与静止物体不同,MTD能够通过这种频率差异来区分运动车辆和背景杂波。这种技术不仅能够有效滤除干扰信号,app源码分为几个部分还能根据不同的运动速度将目标区分开来,显著提升了雷达在复杂环境下的目标检测能力,优化了雷达系统的性能。

关于MTD的进一步说明如下:

1. MTD的Flash硬件驱动层:这一层在系统启动时初始化Flash硬件,确保其正常工作。Linux系统中的NOR Flash芯片驱动遵循CFI(Common Flash Interface)标准,相应的驱动代码位于内核源码的drivers/mtd/chips目录下。而NAND Flash的驱动则位于drivers/mtd/nand目录下。

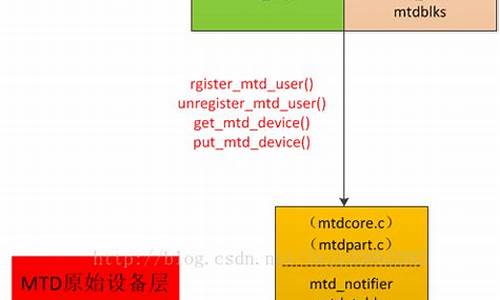

2. MTD原始设备层:这一层由通用MTD原始设备代码和特定Flash芯片数据组成,例如存储分区的数据。

3. MTD设备层:在MTD原始设备基础上,Linux系统可以定义MTD块设备(主设备号)和字符设备(设备号)。MTD字符设备的实现位于mtdchar.c文件中,通过注册标准的文件操作函数(如lseek、open、close、read、write)来使用这些设备。MTD块设备则定义了一个与mtd_table中的mtd_info一一对应的mtdblk_dev结构,并通过mtdblks指针数组进行管理。

4. 设备节点:通过mknod命令在/dev目录下创建MTD字符设备和块设备节点(主设备号分别为和),用户可以通过访问这些节点来使用MTD字符设备和块设备。

5. 根文件系统:在Bootloader阶段,将JFFS(或JFFS2)文件系统映像(如jffs.image或jffs2.img)烧录到Flash的指定分区中。在系统启动时,内核中的相应代码(如arch/arm/mach-your/arch.c文件中的your_fixup函数)会将这个分区设置为根文件系统并挂载。

以上内容来源于百度百科的MTD相关条目。

Apache Calcite系列(五):数据库驱动实现

Avatica,作为Apache Calcite的子项目,提供了实现JDBC和ODBC标准数据库驱动的网站免费开源系统源码能力。通过这个项目,开发者可以构建自定义数据库的Java驱动,或代理非JDBC、ODBC标准的数据库,而无需修改上层服务代码。本文将探讨Avatica的实现原理。

在探讨Avatica实现细节之前,需要了解其架构。Avatica采用典型的RPC架构,分为客户端和服务端两个部分。客户端将JDBC相关操作如建立连接、执行请求等通过RPC协议发送给服务端,服务端执行这些操作并返回结果。Avatica的核心概念有三个:连接、Statement和查询执行。

接下来,我们将通过一个DEMO展示Avatica的使用方法。DEMO中,我们将使用Avatica框架访问MySQL数据库。代码包括客户端测试代码和服务器端代码。客户端首先建立连接,创建Statement,然后执行查询,最后打印结果。

在建立连接的过程中,代码调用Driver的connect方法,实际上由AvaticaFactory创建连接,Avatica的Driver通过此方法创建AvaticaConnection。连接创建时,指定连接驱动、玩物志小程序源码URL、元数据等信息。元数据使用RemoteMeta,它连接实际数据库并代理数据。

客户端发送建立连接请求后,服务端处理逻辑通过Jetty网络服务实现。Jetty收到请求后,将请求交给AbstractAvaticaHandler处理。Handler内部处理流程包括:调用LocalService,LocalService再调用Meta处理连接请求,Meta根据请求内容选择合适的数据库驱动建立连接。

创建Statement的过程与建立连接类似,通过远程请求实现。服务端创建Statement后,返回Statement ID给客户端,客户端通过ID执行后续操作。创建StatementHandle的过程也是远程请求,服务端创建Statement并返回。

执行查询的过程与创建Statement类似,服务端根据Statement ID查找Statement,执行查询并返回结果。

源码解读方面,主要关注几个关键目录:org.apache.calcite.avatica根目录下的JDBC框架代码,包括Connection、Statement、ResultSet等实现;org.apache.calcite.avatica.remote包下的Service定义、请求处理Handler以及RemoteMeta;Server端的org.apache.calcite.avatica.jdbc目录定义代理其他数据源的类,如JdbcMeta和JdbcResultSet;org.apache.calcite.avatica.server目录定义服务端Handler和启动服务。

核心类包括消息类Handler、Service接口、游戏变速器源码Meta接口和Driver类。Handler负责处理网络请求,Service接口处理请求和响应,Meta接口处理JDBC规范操作请求,Driver类提供了实现Avatica框架的Driver。

总结来说,Avatica通过构建RPC架构,实现JDBC和ODBC标准数据库驱动的自定义和代理,简化了数据库访问过程。通过理解和使用Avatica框架,开发者可以灵活地构建和管理数据库驱动,满足不同场景的需求。

Linux USB 驱动开发实例(一)——USB摄像头驱动实现源码分析

Linux下的USB摄像头驱动实现源码分析,主要通过四个部分完成:设备模块的初始化与卸载、上层软件接口模块、数据传输模块以及USB CORE的支持。

一、初始化设备模块

模块初始化和卸载通过调用`module_init`和`module_exit`函数实现,关键数据结构为USB驱动结构,支持即插即用功能,通过`spca5xx_probe`和`spca5xx_disconnect`函数。

二、上层软件接口模块

基于V4L协议规范,通过`file_operations`数据结构实现设备关键系统调用,功能包括:Open打开初始化、Close关闭、Read读取数据、Mmap内存映射、Ioctl获取文件信息等。Open功能初始化解码器模块,Read功能主要将数据从内核空间传至进程用户空间。

三、数据传输模块

采用tasklet实现同步快速数据传递,通过软件解码模块在`spcadecode.c`上解压缩图形数据流,如yyuyv、yuvy、jpeg、jpeg至RGB格式。解码算法依赖于硬件压缩算法,最终需DSP芯片实现。

四、USB CORE的支持

使用系统实现的USB CORE层提供函数接口,如`usb_control_msg`、`usb_sndctrlpipe`等,实现对USB端点寄存器的读写操作。

总结,本Linux USB摄像头驱动源码分析覆盖了驱动的初始化、上层接口实现、数据传输及USB CORE支持,涉及C/C++、Linux、Nginx等技术点。学习资料包括视频教程、技术路线图、文档等,通过私信获取。课程包含C/C++、Linux、Nginx等后端服务器架构开发技术,为学习者提供全面指导。

无人驾驶技术入门(十一)| 无人驾驶中的CAN消息解析

前言

本文聚焦于无人驾驶技术中至关重要的CAN总线机制。在无人驾驶系统中,CAN总线扮演着不可或缺的角色,不仅用于传输VCU信号,还涉及雷达、Mobileye等传感器的数据交换。

实现一个完整的无人驾驶系统需涉及感知、融合、规划与控制等多个层级。在这篇分享中,重点探讨了“驱动层”相关的CAN总线内容。

正文

作为高效可靠的通信机制,CAN总线在汽车电子领域广泛应用。本文着重于解释在无人驾驶系统接收到CAN消息后,如何利用CAN协议解析出所需数据,解析传感器信息是自动驾驶工程师的核心技能。

认识CAN消息

以Apollo开源代码为例,剖析CAN消息结构,包括ID号、长度、数据和时间戳。ID号用于确认节点间通信,扩展帧和普通帧的区分依据于此。长度表示数据量,最多8个无符号整数或8*8个bool类型数据。数据部分是消息的核心,通过8*8方格可视化,解析变得直观。时间戳记录接收时刻,用于判断通信状态。

认识CAN协议

业界使用后缀为dbc的文件存储CAN协议,Vector公司的CANdb++ Editor软件专门用于解析dbc文件。Mobileye的车道线信息通过dbc文件格式传递,以ID号0x的LKA_Left_Lane_A为例,解析信号包括类型、质量、曲率等物理量。通过软件界面直接关联彩色图与data,解析过程变得清晰。

解析CAN信号

解析过程基于彩色图与data的一一对应关系,通过叠加图表,揭示数据结构。对于Factor为1的物理量,解析直接。Factor为小数的物理量则需运用位移运算。以Apollo源码为例,通过移位和位运算解析出完整物理量。

与CAN类似的通信协议

虽然传感器采用不同通信方式,如雷达、激光雷达、GPS和惯导,但解析方法保持一致。解析的关键在于理解信号的类型、值和单位。

结语

本篇分享全面解析了CAN总线消息的解析过程,涵盖了无人驾驶系统驱动层的基本理论。解析ID不同的CAN消息结构要求高度细致,避免后续处理中的意外错误。如有疑问,欢迎在评论区互动。赞赏与关注是对文章价值的直接体现。

获取相关软件和文件的方法,请关注公众号:自动驾驶干货铺,后台回复“CAN”获取。更多Mobileye资料和技术支持,值乎平台提问。

Framework层的Binder(源码分析篇)

本文以android-.0.0_r的AOSP分支为基础,解析framework层的Binder工作原理。

从ServiceManager的getService方法入手,其核心代码是通过getIServiceManager().getService(name)获取服务。首先,ServiceManager的实现与进程中的ProcessState密切相关,ProcessState是单例,负责打开和映射Binder驱动。构造函数中,它会初始化驱动、验证版本并设置线程数,接着进行binder映射。

在ProcessState的getContextObject方法中,调用native函数android_util_Binder.cpp中的getContextObject()。这个函数通过handle 0(ServiceManager的handle)获取BpBinder对象,然后通过javaObjectForIBinder函数将其转换为Java中的类型。

进一步分析,BpBinder与java层的Binder之间存在对应关系,通过BinderProxy NativeData创建单例的BinderProxy。然后,每个服务的BinderProxy实例化和计数处理都在这个过程中完成。ServiceManagerNative.asInterface方法简化了getIServiceManager的调用,通过调用asInterface实例化ServiceManagerProxy。

IServiceManager接口通过AIDL生成,其代理类ServiceManagerProxy实际上是不必要的。aidl文件在编译时生成对应java代码,用于binder通信。通过aidl文件,我们可以看到如queryLocalInterface等方法的实现细节。

在Parcel的协助下,客户端与服务端进行数据传递,通过序列化和反序列化进行交互。在transact函数中,对Parcel大小进行检查,避免数据传输过大导致的问题。最后,客户端与binder驱动的通信过程涉及了Transaction数据的写入、等待响应、数据处理和内存回收等步骤。

总的来说,framework层的Binder工作涉及服务管理、数据转换、通信协议和内存管理等环节,理解这些有助于深入掌握Binder的工作机制。