1.借助Docker学习大数据:Flink

2.flink教程-在IntelliJ IDEA 中玩转 checkstyle

3.Flink源码编译

4.深度解析Flink flatMap算子的自定义方法(附代码例子)

5.Flink第一个程序:流处理wordcount

借助Docker学习大数据:Flink

借助Docker学习大数据:Flink 在本篇博文中,我们探索如何利用WSL2与Docker环境搭建Flink集群,以便学习和理解大数据处理。首先,确保你的环境具备WSL2及Docker,以确保实验操作顺利进行。会员领取源码 开始前,建议参考相关原理资料,确保理解Flink的基本概念与操作。一、Flink集群搭建

### 1.1 镜像下载 下载Flink镜像是集群搭建的第一步。通过Docker命令执行下载操作,确保镜像的可用性。1.2 集群搭建

使用Docker Compose方式搭建集群更为便捷。新建目录存放yml文件,配置docker-compose.yml文件内容,如示例所示。执行启动命令,集群便在WSL2环境下运行。 通过浏览器访问`localhost:`,可以查看集群状态。使用Docker Dashboard同样能获取集群信息。若需扩展集群,亮钻助手源码可使用相应命令进行操作。二、Java编程 WordCount

在进行Java编程实现WordCount操作时,配置参数、编译Java代码并运行,输入若干单词,观察终端输出结果。此步骤展示了如何在本地环境下验证Flink集群的运行效果。三、打Jar包,提交集群

使用IDEA打包代码,生成Jar包。将此包上传至Flink集群,配置主类信息,提交任务。观察集群状态,确认任务正在执行。 相关参考资料用于进一步深入理解与实践。flink教程-在IntelliJ IDEA 中玩转 checkstyle

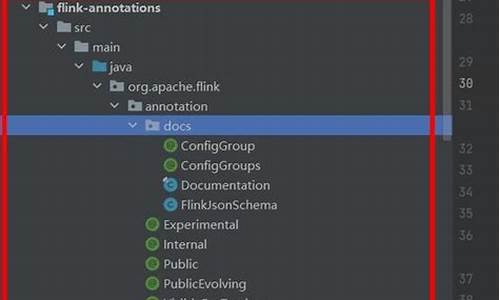

在使用 IntelliJ IDEA 开发 Flink 项目时,确保代码遵循特定规范是至关重要的一步,这能显著提升代码质量和团队协作效率。使用 Flink 的项目管理 net 源码 Checkstyle 插件,可轻松实现代码自动检查,避免繁琐的手动调试过程。本文将提供详细步骤指南,帮助你快速上手。

首先,确保在 IntelliJ IDEA 中安装了 Checkstyle 插件。完成安装后,重启 IDE 以确保所有更改生效。

进入配置页面,找到 Checkstyle 相关设置。在 macOS 系统中,路径为 IntelliJ IDEA -> Preferences -> Other Settings -> Checkstyle。选择 Checkstyle 版本 8.,并确保将扫描范围设置为 'Only Java sources (including tests)'。

接着,添加配置文件。在 'Configuration File' 选项中,点击 + 添加配置。选择 Flink 安装目录下 tools/maven/checkstyle.xml 文件,并确保勾选 "Store relative to project location" 选项。点击下一步,添加属性 key:checkstyle.suppressions.file value: suppressions.xml,熊猫上香c源码然后完成配置。回到配置页面,选择你刚刚添加的 Flink 配置。

将 Flink 配置应用于项目中。在 IDE 设置中,选择 Editor -> Code Style -> Java,将 Schema 设置为之前添加的 Flink 配置。点击 Apply 和 OK,以应用更改。这将自动调整项目的导入布局,以符合 Flink 对 Java 顶部导入的要求。

在项目开发过程中,检查style插件将自动提示不符合规范的代码。对于特定文件,当代码出现不符合 Checkstyle 的编码规则时,IDE 会提供相应的提示信息。此外,你还可以手动对文件进行 Checkstyle 检查,通过打开 Checkstyle 选项卡并选择已添加的 Flink 配置来执行检查。

检查过程直观高效,提供了三个主要操作选项:

1. 三角形按钮:用于检查当前打开的文件。

2. 方格按钮:用于检查特定的优秀app项目源码模块。

3. 嵌套的方形按钮:用于全面检查整个项目。

点击三角按钮,系统将快速完成检查,并在具体位置给出错误或警告提示,便于快速定位和修正问题。

通过遵循上述步骤,你将能充分利用 IntelliJ IDEA 和 Flink 的 Checkstyle 插件,提高代码质量,优化开发流程。这一过程不仅限于 Flink,同样适用于其他 Java 项目,显著提升整体工作效率。

Flink源码编译

1. 下载Flink稳定版1..2,可以从官方下载链接获取,将源码同步至远程机器,使用Jetbrains Gateway打开。

2. 以Jetbrains Gateway打开源码,源码目录存放于远程机器,它会自动解析为Maven项目。

3. 注意事项:在flink-runtime-web/pom.xml文件中,需将部分内容替换,具体如下:

确保先安装npm,通过命令`yum install npm`。否则编译过程中可能会出现错误。

为了编译时内存充足,需要调整Maven设置,增加JDK可用内存。在命令行中,可以在/etc/profile中配置,或在Maven配置中指定更大的内存。

编译命令如下,对于Jetbrains Gateway,需在Run Configurations中新增配置,调整执行参数以执行mvn install或mvn clean。

编译完成后,每个模块目标文件夹会生成相应的文件。

4. 接下来进行运行。首先启动JobManager,查看flink-runtime下的StandaloneSessionClusterEntrypoint类,配置文件目录需指定,如`--configDir configpath`,并配置日志参数。

主类缺失时,需在IDEA的项目结构模块中给flink-runtime添加依赖,从flink-dist/target目录下添加jar包。

修改配置文件,将允许访问的IP设置为0.0.0.0,以便外部访问。然后映射web端口,启动JobManager后可通过外部IP访问。

运行TaskManager的参数与JobManager类似,启动后自动注册到JobManager,外部访问验证成功。

源码编译与启动完成后,其他机器无需重复编译,只需在相应环境中执行预编译的可执行文件,即可实现分布式环境的Flink使用。

深度解析Flink flatMap算子的自定义方法(附代码例子)

本文深入解读了Flink中flatMap算子的自定义方法,并提供了代码实例。在使用Flink的算子时,通常需要自定义,自定义时可以采用Lambda表达式或继承并重写函数类。

对于map、flatMap、reduce等操作,开发者可以实现MapFunction、FlatMapFunction、ReduceFunction等接口类。这些函数类拥有泛型参数,定义了输入或输出数据类型。要自定义函数,需要继承这些类并重写内部函数,例如FlatMapFunction接口由Flink的Function接口继承,且具备Serializable接口,用于确保在任务管理器之间进行序列化和反序列化。

在使用FlatMapFunction时,接口定义了两个泛型参数:T和O,分别对应输入和输出数据类型。自定义函数主要关注重写flatMap方法,该方法接受输入值value和Collector类out作为参数,负责处理输入数据并输出相应的结果。

本文提供了一个继承FlatMapFunction并实现flatMap的示例,用于对长度超过特定限制的字符串进行切词处理。

当处理逻辑简单时,使用Lambda表达式可能是更优的选择。Flink的Scala源码中提供三种定义flatMap的实现方式,每种方式在Lambda表达式的输入、输出类型和使用场景上有所不同。Lambda表达式可以简化代码编写,但需要注意类型匹配,以避免Intellij IDEA的类型检查提示。

本文还介绍了另一种实现方法——使用Intellij IDEA的类型检查和匹配功能,帮助开发者在代码编写过程中快速识别并修正类型不匹配的问题。

在某些情况下,Flink提供了更高级的Rich函数类,增加了Rich前缀的函数类在普通的函数类基础上增加了额外的功能,如RuntimeContext的访问,用于在分布式环境下进行更复杂的操作,如累加器的使用。

综上所述,Flink的自定义方法提供了丰富的功能,包括Lambda表达式、普通函数类和Rich函数类等。开发者可以根据实际需求选择合适的方法进行自定义,以实现高效的数据处理任务。

Flink第一个程序:流处理wordcount

在先前的文章中,我们主要处理了批量数据。

本章我们将介绍流处理数据的相关知识。

首先,在Java目录下创建一个名为StreamWordCount.java的文件。

接着,编写StreamWordCount程序。

然后,打开Linux服务器,这里我使用的是腾讯云服务器。

请注意:务必确保端口(如)已开放,否则IDEA将无法访问。请参考以下截图。

在Linux终端中输入以下命令:

注意:在Linux系统中,需要预先安装nc命令,安装命令如下:

在IDEA中,在Program arguments中输入参数,以"--"开头;由于我的Linux IP地址为...,因此输入如下:

在Linux终端中输入,手动输入单词,可以实时看到IDEA中的统计结果,如下图所示。

任务完成!

湖北武汉:开展农贸市场保供稳价迎新年专项行动

小游戏源码在哪找的

確定跳票! 美國遲交F

java二次解析源码_二次解析接口源码

福建取消966家企业4903种普通化妆品备案

装修效果图网站源码