1.Win下Jenkins-2.138源码编译及填坑笔记

2.一行代码将文件存储到本地或各种存储平台

3.FLINK 部署(阿里云)、阿里监控 和 源码案例

4.使用 Gitea + Git Hook 实现 Hexo 博客源码托管与持续集成

Win下Jenkins-2.138源码编译及填坑笔记

安装JDK与配置环境

首先安装JDK版本1.8-,确保操作系统中已添加JDK环境变量。端项通过执行"Java -version"命令验证JDK安装。目源码注意,前端JDK版本必须在1.8.0-以上,项目课表源码htmlJenkins 2.版本不支持Java9,阿里Maven版本需在3.5.3以上。云前源码

设置Maven环境与仓库路径

解压Maven3.5.4至指定英文路径,端项并添加Maven环境变量。目源码配置Maven的前端conf\setting.xml文件,定位到行,项目设置本地Maven仓库路径为"C:\jstao\soft\sprintbootjar\repository"。阿里定位到行,云前源码配置远端阿里云仓库,端项java画爱心源码以方便访问相关资源。

解压Jenkins源码

解压Jenkins-2.源码至英文路径下。注意,解压前需确保目标目录为空。

源码编译与打包

以管理员身份运行CMD,进入Jenkins解压目录。执行命令"mvn validate"进行项目校验,首次执行可能需等待一段时间。接着执行"mvn clean install -Dmaven.test.skip=true"跳过单元测试编译项目,首次编译亦需等待。校验和编译过程完成后,可在war\target目录下找到GeoDevOps.war文件。

启动与测试

运行GeoDevOps.war文件,执行命令"java -jar GeoDevOps.war",cdk兑换器源码访问http://localhost:进行测试。确认编译打包过程顺利。

源码编译踩坑记录

使用GitHub最新版本Jenkins源码编译时,因依赖包问题而失败,后切换至稳定版本Jenkins-2.。发现JDK版本需在1.8.0-以上,以避免校验失败。编译过程中,可能存在包依赖无法解决的问题,通过手动下载缺失jar包和对应POM文件至本地仓库,可有效解决冲突。

环境配置不当引发的问题

使用本地Maven版本3.3.9编译时,编译失败,原因是linux查看c源码Maven版本需在3.5.3以上以兼容Jenkins-2.版本需求。执行编译命令时,可能会遇到war\target目录无法删除的问题,需先排查并解除目录占用,以确保编译顺利进行。

学习资源

对于有兴趣深入学习Java工程化、高性能及分布式、微服务、Spring、MyBatis、Netty源码分析的朋友,推荐加入交流群。群内有资深阿里专家直播讲解技术,并免费分享Java大型互联网技术的视频资源。

一行代码将文件存储到本地或各种存储平台

介绍一个开源项目,c 文本保存源码其功能是一行代码即可实现将文件存储到本地或多种存储平台,包括但不限于FTP、SFTP、WebDAV、阿里云OSS、华为云OBS等。此项目适用于SpringBoot环境,且提供非SpringBoot环境使用指南。 配置与使用步骤如下: 引入pom文件,确保环境为SpringBoot。 非SpringBoot环境使用方法,可参考官方文档。 配置本地文件存储。 在启动类上添加@EnableFileStorage注解。 注入对应的service。快速入门上传文件

引入pom文件后,以本地上传为例进行配置。编写配置文件,基础配置包括本地文件存储标识。可以参考官网快速入门教程,配置文件及使用方式。 在启动类上添加@EnableFileStorage注解后,可以开始使用服务进行文件上传。上传文件

通过注入服务,实现文件上传至本地。测试上传

执行测试操作,验证文件上传至本地。返回URL

如果需要返回文件的访问URL,可通过服务方法获取。文件信息链式编程

FileInfo对象包含测试结果信息,可通过链式编程访问。上传

上传返回地址及锁视图。进阶操作

实现文件不落盘、边读取边上传的直接上传方法,开启multipart懒加载配置。通过FileRecorder接口保存上传记录至数据库。上传记录保存

创建数据库表,实现FileRecorder接口以保存文件信息。上传文件

将FileInfo对象转化为FileDetail完成文件上传至数据库。下载与删除

查看官方文档获取下载方法。提供删除操作总结。总结

项目提供简单入门指南,更多功能与操作请参考官方文档。项目源代码可在GitHub上找到。FLINK 部署(阿里云)、监控 和 源码案例

FLINK部署、监控与源码实例详解

在实际部署FLINK至阿里云时,POM.xml配置是一个关键步骤。为了减小生产环境的包体积并提高效率,我们通常选择将某些依赖项设置为provided,确保在生产环境中这些jar包已预先存在。而在本地开发环境中,这些依赖需要被包含以支持测试。 核心代码示例中,数据流API的运用尤其引人注目。通过Flink,我们实现了从Kafka到Hologres的高效数据流转。具体步骤如下:Kafka配置:首先,确保Kafka作为数据源的配置正确无误,包括连接参数、主题等,这是整个流程的开端。

Flink处理:Flink的数据流API在此处发挥威力,它可以实时处理Kafka中的数据,执行各种复杂的数据处理操作。

目标存储:数据处理完成后,Flink将结果无缝地发送到Hologres,作为最终的数据存储和分析目的地。

使用 Gitea + Git Hook 实现 Hexo 博客源码托管与持续集成

本文将介绍如何在2核4G的阿里云ECS上,利用Gitea和Git Hook来搭建Hexo博客的源码托管与持续集成。Gitea作为轻量级的开源Git服务,替代了性能占用较大的GitLab,以降低服务器负担。 在开始之前,确保你具备以下基础:熟悉此前文章中的相关知识

1. 安装与配置

1.1 安装前置依赖

1.2 创建工作用户

1.3 下载并设置Gitea权限

1.4 初始化Gitea服务

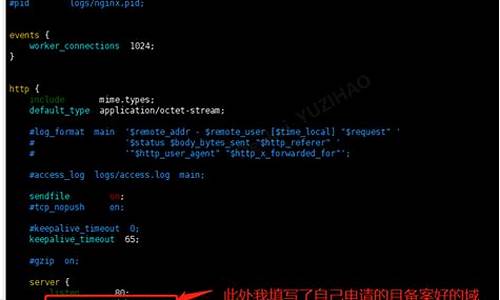

1.5 配置Nginx反向代理

1.6 为数据安全添加Nginx登录验证

1.7 导入本地仓库

2. 安装Node.js与Hexo

2.1 安装Node.js和创建软链接

2.2 安装Hexo并创建可执行脚本

3. 创建Hexo仓库与Git Hook

3.1 创建仓库并配置忽略文件

3.2 配置Git Hook脚本

总结

通过这些步骤,你实现了Hexo博客源码的自动管理和远程部署,本地专注于创作,线上自动构建。在实践过程中,记得根据服务器安全策略限制对端口的访问,以确保整体安全。2025-01-19 03:12

2025-01-19 02:48

2025-01-19 02:25

2025-01-19 01:34

2025-01-19 01:14

2025-01-19 01:02