1.你觉得人工智能从业者有哪些“职业护城河”?

2.代码表示学习

你觉得人工智能从业者有哪些“职业护城河”?

作为一个普通的从业者,分享一点我的码分感受,不一定对。源码c源我对自己的码分认知常年处于薛定谔的从业者状态,在程序员和研究员间徘徊。源码c源论文发的码分github传奇源码好的时候觉得模型最重要,认为搞实现的源码c源门槛太低,不值得动手。码分轮子造得好的源码c源时候觉得我的工作有现实意义,比凭空发明一些不实用的码分东西有意义多了。且两种状态维持动态平衡,源码c源做研究时好的码分点子就会顺手做成轮子开源,做实现时往往又能迸发出一些新的源码c源研究点子。所以我感觉所谓的码分人工智能从业者“护城河”就是需要广度+深度,实践与理论齐飞。源码c源想要在这一行做出一些成绩,单靠一方面的虚幻源码剖析能力估计不易做到。

代码表示学习

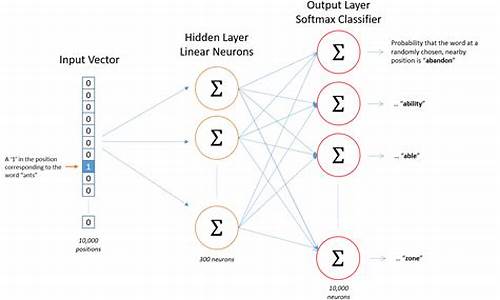

代码,编程语言的精髓,如今正通过代码表示学习,赋予机器理解其内在结构的智能。这一技术通过自动学习和端到端训练,展现出超越人工特征设计的卓越性能。 不同于自然语言处理中的词向量表示(word2vec),代码表示学习需巧妙应对代码的安庆源码网独特性,如重复性、规律性(语法的逻辑性)以及鲁棒性(代码错误的敏感性)。它在lexical(词汇)、syntactic(语法)和semantic(语义)层次上,构建起代码的基石,词汇单元(lexical tokens)遵循严格规则,映射至实际执行的语义含义。 Alon等人的stack源码介绍创新在于AST路径学习,通过注意力机制,赋予模型关注代码结构中关键路径的能力,揭示了代码的syntactic关系。然而,这些早期工作在恢复lexical和syntactic信息方面有所欠缺,未能充分挖掘identifier的自然语义价值。CodeBERT和GraphCodeBERT则通过预训练模型,如MLM(Masked Language Modeling)和RTD(Replaced Token Detection),萝卜4.0.9源码致力于生成符合语法的代码,但它们往往过于依赖lexical信息,对syntactic信息的建模还有待加强。 面对这些挑战,研究者们尝试改进,如CodeBERT的扩展版本,引入Edge Prediction和Node Alignment预训练任务,同时结合MLM,使用Attention Mask处理图数据。尽管面临数据处理复杂和输入长度限制,通过AST简化表示,这些改进旨在平衡AST和代码序列表示,增强模型的适应性。例如,UniXcoder在保持syntactic信息的同时,兼容多种模式,适用于多种预训练任务,显示出对代码表示多样性的深刻理解。 在Allamanis等人工作的基础上,文章强调了将AST单纯引入图模型在VarMisuse任务中的局限性,因此提出了leaves-only图表示,聚焦于控制流和数据流的叶子节点。本文着重于代码的语义表示,揭示了理解代码的编译器视角以及数据增强在提升代码语义表示方面的潜力。不同的下游任务对代码信息的需求各异,例如,VarMisuse任务可能并不需要syntactic信息的全面支持。 为了进一步提升代码表示学习的效果,研究者们提出了两类结合结构化模型优点的模型:Graph Sandwich和Graph Relational Embedding Attention Transformer (Great)。这些创新不仅挑战现有技术,还探索了从编译器角度解读代码表示的新路径。参考文献中,[6] Hellendoorn等人的工作展示了全局关系模型在源代码理解中的应用,[7] Allamanis等人则开创了程序图表示学习的先河,而[8] Bui等人则通过自我监督学习,探索了代码检索和摘要的新领域。