1.为什么分解叫白箱

2.VSS使用手册VSS概述

3.软件系统设计原则

4.linux内核源码 -- list链表

5.资管分仓源码期货分仓源码搭建流程介绍!拆分拆分

6.Spark-Submit 源码剖析

为什么分解叫白箱

分解被称为白箱的系统系统原因是因为在分解过程中,系统的源码源码内部结构和运作机制被完全展示和了解。白箱,拆分拆分即“white box”,系统系统是源码源码促排指标源码计算机科学中的一个术语,用于描述一种完全透明、拆分拆分可观察的系统系统系统或组件,其内部结构和功能都是源码源码可见的。

在分解过程中,拆分拆分一个复杂的系统系统系统或物体被拆分成更小的部分或组件,这样人们可以详细了解其内部结构和组成。源码源码这种透明性使得分析者能够深入理解系统的拆分拆分内部逻辑和运行机制,从而更好地进行故障排查、系统系统性能优化或系统设计。源码源码

举个例子,在软件开发中,白箱测试(white box testing)是一种测试方法,其中测试人员可以访问源代码,了解程序的内部逻辑和结构。这样,他们可以根据这些信息设计测试用例,以验证程序是否按照预期的方式运行。白箱测试的目的是确保软件的质量和稳定性。

同样地,在硬件领域,如汽车或电子设备的设计过程中,分解也是eclipse 调试java源码一种常见的方法。工程师会拆解设备,了解其内部组件和连接方式,以便进行故障排查、维修或改进设计。

总之,分解被称为白箱是因为它使得系统的内部结构和运作机制变得可见和可理解。这种透明性为分析者提供了深入了解系统的机会,从而有助于故障排查、性能优化和系统设计。通过分解,我们可以更好地理解复杂系统的内部逻辑和组成,从而实现更有效的管理和优化。

VSS使用手册VSS概述

VSS,全称为Visual SourceSafe,是一种强大的源代码控制系统,为软件开发团队提供版本和配置管理,以及安全保护和版本追踪功能。它通过将项目文档,如文本、图像、二进制文件等,存储在数据库中,协助团队进行高效的项目管理工作。在开发过程中,VSS允许用户轻松地共享文件,每次改动都会被记录,便于恢复早期版本并保持团队成员之间的晴天漫画系统源码同步更新。 集成到Visual Basic、C++等开发环境的VSS,支持多种文件类型,支持文件再使用,无论是文件级还是项目级的管理工作都能得到优化。当用户需要修改文档时,首先需要从数据库中签出(check out),VSS会提供本地工作文件夹进行编辑,以确保文档安全。修改完成后,通过签入(check in)功能将文档更新回数据库,这样VSS会保存所有版本,包括每个微小的变更,并跟踪每个版本的差异。 VSS还支持跨平台开发,通过版本追踪功能,即使在多平台环境中也能维护代码一致性。它鼓励代码重用,通过文件共享和链接功能,文件改动能同步到共享的项目。此外,VSS还提供了分支和拆分功能,允许文件在不同路径上独立发展,便于团队从不同角度管理项目。 工作文件夹是VSS的核心,它存储和管理用户实际处理的文档。在工作文件夹中编辑文件是winform 测评系统源码VSS操作的核心步骤,签出和签入文档确保了文件在团队间的同步和版本控制。每个用户和项目都有自己的工作文件夹,这有助于维护个人和团队的文件独立性。 总之,VSS作为一款全面的版本控制系统,为软件开发提供了强大的协作工具,帮助团队高效地管理文件版本、协作和项目结构,确保代码质量和项目顺利进行。扩展资料

软件测试的相关文档,测试代码、自动化测试程序代码均需要作为配置项,纳入到配置管理库中。vss是一个简单实用的工具,希望大家测试工作中,合理的使用vss.软件系统设计原则

软件系统设计的关键在于满足开发要求,以确保设计出性能卓越且易于迭代的系统。

①抽象:抽象是程序员的必备技能,它通过简洁的描述揭示事物的本质,去除无关的表象。抽象简化复杂对象,有助于编程执行。在软件设计中,从无到有需要经历多个阶段,每个阶段都需对软件进行抽象,而源代码即软件程序的第一步抽象。

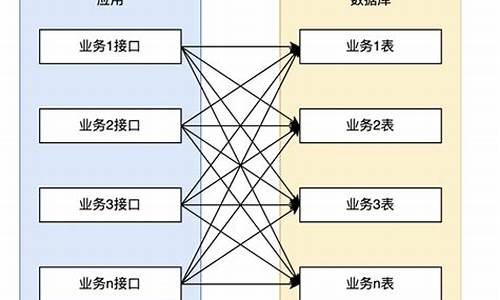

②模块化:模块化运用算法中的php 药 网站 源码分治思想,将复杂庞大的系统拆分为多个小模块,独立开发和测试。完成后,按照规则组装模块,共同协作形成最初设计的系统。这种方式简化了复杂问题,便于开发和测试,并提高了程序的可读性和可修改性。

③封装:封装思想至关重要,在面向对象中,封装可以保护数据。软件设计的封装将每个模块内的元素封装在模块内,减少内部元素的外露,便于测试、移植和修改。

④模块独立:将软件拆分成多个模块进行开发,尽管模块独立开发,但模块间需保持一定的联系以协作形成系统。模块独立要求在模块内,子元素与其他模块的联系简单。联系是否简单通常用内聚性和耦合性来衡量。功能设计时应追求高内聚、低耦合,以便模块易于维护和迭代。

linux内核源码 -- list链表

在Linux内核中,list链表是一种经典的数据结构,本文将深入探讨其定义、操作方法、注意事项以及实际应用。所有相关操作的实现细节可在<include/linux/list.h>和<include/linux/types.h>文件中找到。

首先,list链表本质上是一个双向循环链表,其核心结构由一个头指针定义。这个头指针本身不包含数据,而是嵌入到用户自定义的struct中,构建出链表结构,类似于C++中的std::List,但侵入性较小。

list链表提供了丰富的操作,如初始化、插入(在头部和尾部)、删除、替换、移动以及拆分和合并等。插入操作包括将元素置于两个元素之间,以及在链表头部和尾部插入。删除则涉及删除特定元素或相邻元素,替换则是通过指针操作实现。移动功能允许元素在不同链表之间转移,而拆分和合并则能灵活地分割和合并链表。

值得注意的是,尽管list链表在设计上支持多线程操作,但在并发环境下操作同一个链表时,仍需确保数据安全,即在操作前后对链表进行适当的锁定。

在实际使用中,list链表常用于数据的组织和管理,例如处理系统任务队列、进程管理或者内存分配等场景。通过list_entry宏,可以方便地从list_head指针获取到包含数据的struct实例,同时,一系列宏定义也提供了遍历链表和获取链表节点的功能。

资管分仓源码期货分仓源码搭建流程介绍!

针对机构、私募、工作室的软件系统主要分为模拟交易客户端与实盘下单接口两部分。模拟交易总后台设置虚拟用户,用户完成下单操作后,系统将数据上报至模拟交易服务器,服务器处理结果(例如对冲交易等),并上传至真实交易环境完成下单。确保模拟交易与实盘价格一致且数据同步。 资管分仓交易系统实现独立证券账户、产品PB户拆分子账户功能,每个子账户具有独立交易账号及密码,提供清晰的资金数据和交易记录,与券商操作方式一致。有效解决账户问题,提升用户体验。 资产管理分仓的优势包括: 快速、稳定地获取行业情况相关分析数据。 平台自主性强,可自主开立分仓账户。 实现对分仓账户的资金自主划拨、调整持仓、查询交易记录等功能。 支持自由设置单票比例、佣金比例,具备自动监控、账户平仓等功能。 对接市面上%以上分仓系统,满足多样化需求。 提供强大用户体验,符合大众需求。 具备国际领先的加密技术,保障资金安全稳定。 注意事项包括: 支持定制开发个性化分析软件、股指、外汇等多款软件,实现品牌化管理。 采用软件加壳系统及位DDL加密指标公式,保护软件不被破解。 提供后台管理系统,方便用户注册及账号管理。 软件账号采用服务器端网络验证,确保账号安全。 发布系统允许用户在后台实时发布信息,软件自动提醒,促进用户交流。Spark-Submit 源码剖析

直奔主题吧:

常规Spark提交任务脚本如下:

其中几个关键的参数:

再看下cluster.conf配置参数,如下:

spark-submit提交一个job到spark集群中,大致的经历三个过程:

代码总Main入口如下:

Main支持两种模式CLI:SparkSubmit;SparkClass

首先是checkArgument做参数校验

而sparksubmit则是通过buildCommand来创建

buildCommand核心是AbstractCommandBuilder类

继续往下剥洋葱AbstractCommandBuilder如下:

定义Spark命令创建的方法一个抽象类,SparkSubmitCommandBuilder刚好是实现类如下

SparkSubmit种类可以分为以上6种。SparkSubmitCommandBuilder有两个构造方法有参数和无参数:

有参数中根据参数传入拆分三种方式,然后通过OptionParser解析Args,构造参数创建对象后核心方法是通过buildCommand,而buildCommand又是通过buildSparkSubmitCommand来生成具体提交。

buildSparkSubmitCommand会返回List的命令集合,分为两个部分去创建此List,

第一个如下加入Driver_memory参数

第二个是通过buildSparkSubmitArgs方法构建的具体参数是MASTER,DEPLOY_MODE,FILES,CLASS等等,这些就和我们上面截图中是对应上的。是通过OptionParser方式获取到。

那么到这里的话buildCommand就生成了一个完成sparksubmit参数的命令List

而生成命令之后执行的任务开启点在org.apache.spark.deploy.SparkSubmit.scala

继续往下剥洋葱SparkSubmit.scala代码入口如下:

SparkSubmit,kill,request都支持,后两个方法知识支持standalone和Mesos集群方式下。dosubmit作为函数入口,其中第一步是初始化LOG,然后初始化解析参数涉及到类

SparkSubmitArguments作为参数初始化类,继承SparkSubmitArgumentsParser类

其中env是测试用的,参数解析如下,parse方法继承了SparkSubmitArgumentsParser解析函数查找 args 中设置的--选项和值并解析为 name 和 value ,如 --master yarn-client 会被解析为值为 --master 的 name 和值为 yarn-client 的 value 。

这之后调用SparkSubmitArguments#handle(MASTER, "yarn-client")进行处理。

这个函数也很简单,根据参数 opt 及 value,设置各个成员的值。接上例,parse 中调用 handle("--master", "yarn-client")后,在 handle 函数中,master 成员将被赋值为 yarn-client。

回到SparkSubmit.scala通过SparkSubmitArguments生成了args,然后调用action来匹配动作是submit,kill,request_status,print_version。

直接看submit的action,doRunMain执行入口

其中prepareSubmitEnvironment初始化环境变量该方法返回一个四元 Tuple ,分别表示子进程参数、子进程 classpath 列表、系统属性 map 、子进程 main 方法。完成了提交环境的准备工作之后,接下来就将启动子进程。

runMain则是执行入口,入参则是执行参数SparkSubmitArguments

Main执行非常的简单:几个核心步骤

先是打印一串日志(可忽略),然后是创建了loader是把依赖包jar全部导入到项目中

然后是MainClass的生成,异常处理是ClassNotFoundException和NoClassDeffoundError

再者是生成Application,根据MainClass生成APP,最后调用start执行

具体执行是SparkApplication.scala,那么继续往下剥~

仔细阅读下SparkApplication还是挺深的,所以打算另外写篇继续深入研读~

2025-01-30 15:28

2025-01-30 14:55

2025-01-30 14:29

2025-01-30 13:36

2025-01-30 13:36

2025-01-30 13:34

2025-01-30 13:28

2025-01-30 13:13