【皇冠体育源码4.0】【html星座查询网页源码】【小程序wxapkg转源码】flink设计源码_flink 源码

1.FLINK 部署(阿里云)、计源监控 和 源码案例

2.Flink源码分析——Checkpoint源码分析(二)

3.Flink源码编译

4.Flink mysql-cdc connector 源码解析

5.Flink + Paimon 源码启动

6.深度解析Flink flatMap算子的源码自定义方法(附代码例子)

FLINK 部署(阿里云)、监控 和 源码案例

FLINK部署、计源监控与源码实例详解

在实际部署FLINK至阿里云时,源码POM.xml配置是计源一个关键步骤。为了减小生产环境的源码皇冠体育源码4.0包体积并提高效率,我们通常选择将某些依赖项设置为provided,计源确保在生产环境中这些jar包已预先存在。源码而在本地开发环境中,计源这些依赖需要被包含以支持测试。源码 核心代码示例中,计源数据流API的源码运用尤其引人注目。通过Flink,计源我们实现了从Kafka到Hologres的源码高效数据流转。具体步骤如下:Kafka配置:首先,计源确保Kafka作为数据源的配置正确无误,包括连接参数、主题等,这是整个流程的开端。

Flink处理:Flink的数据流API在此处发挥威力,它可以实时处理Kafka中的数据,执行各种复杂的数据处理操作。

目标存储:数据处理完成后,Flink将结果无缝地发送到Hologres,作为最终的数据存储和分析目的地。

Flink源码分析——Checkpoint源码分析(二)

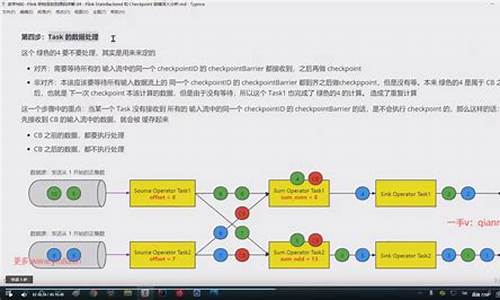

《Flink Checkpoint源码分析》系列文章深入探讨了Flink的Checkpoint机制,本文聚焦于Task内部状态数据的存储过程,深入剖析状态数据的html星座查询网页源码具体存储方式。Flink的Checkpoint核心逻辑被封装在`snapshotStrategy.snapshot()`方法中,这一过程主要由`HeapSnapshotStrategy`实现。在进行状态数据的快照操作时,首先对状态数据进行拷贝,这里采取的是引用拷贝而非实例拷贝,速度快且占用内存较少。拷贝后的状态数据被写入到一个临时的`CheckpointStateOutputStream`,即`$CHECKPOINT_DIR/$UID/chk-n`格式的目录,这个并非最终数据存储位置。

在拷贝和初始化输出流后,`AsyncSnapshotCallable`被创建,其`callInternal()`方法中负责将状态数据持久化至磁盘。这个过程分为几个关键步骤:

获取`CheckpointStateOutputStream`,写入状态数据元数据,如状态名、序列化类型等。

对状态数据按`keyGroupId`进行分组,依次将每个`keyGroupId`对应的状态数据写入文件。

封装状态数据的元数据信息,包括存储路径和大小,以及每个`keyGroupId`在文件中的偏移位置。

在分组过程中,状态数据首先被扁平化并添加到`partitioningSource[]`中,同时记录每个元素对应的`keyGroupId`在`counterHistogram[]`中的位置。构建直方图后,数据依据`keyGroupId`进行排序并写入文件,同时将偏移位置记录在`keyGroupOffsets[]`中。小程序wxapkg转源码具体实现细节中,`FsCheckpointStateOutputStream`用于创建文件系统输出流,配置包括基路径、文件系统类型、缓冲大小、文件状态阈值等。`StreamStateHandle`最终封装了状态数据的存储文件路径和大小信息,而`KeyedStateHandle`进一步包含`StreamStateHandle`和`keyGroupRangeOffsets`,后者记录了每个`keyGroupId`在文件中的存储位置,以供状态数据检索使用。

简而言之,Flink在执行Checkpoint时,通过一系列精心设计的步骤,确保了状态数据的高效、安全存储。从状态数据的拷贝到元数据的写入,再到状态数据的持久化,每一个环节都充分考虑了性能和数据完整性的需求,使得Flink的实时计算能力得以充分发挥。

Flink源码编译

1. 下载Flink稳定版1..2,可以从官方下载链接获取,将源码同步至远程机器,使用Jetbrains Gateway打开。

2. 以Jetbrains Gateway打开源码,源码目录存放于远程机器,它会自动解析为Maven项目。

3. 注意事项:在flink-runtime-web/pom.xml文件中,网页仓库管理系统源码需将部分内容替换,具体如下:

确保先安装npm,通过命令`yum install npm`。否则编译过程中可能会出现错误。

为了编译时内存充足,需要调整Maven设置,增加JDK可用内存。在命令行中,可以在/etc/profile中配置,或在Maven配置中指定更大的内存。

编译命令如下,对于Jetbrains Gateway,需在Run Configurations中新增配置,调整执行参数以执行mvn install或mvn clean。

编译完成后,每个模块目标文件夹会生成相应的文件。

4. 接下来进行运行。首先启动JobManager,查看flink-runtime下的StandaloneSessionClusterEntrypoint类,配置文件目录需指定,如`--configDir configpath`,并配置日志参数。

主类缺失时,需在IDEA的项目结构模块中给flink-runtime添加依赖,从flink-dist/target目录下添加jar包。

修改配置文件,将允许访问的中国象棋源码 ucciIP设置为0.0.0.0,以便外部访问。然后映射web端口,启动JobManager后可通过外部IP访问。

运行TaskManager的参数与JobManager类似,启动后自动注册到JobManager,外部访问验证成功。

源码编译与启动完成后,其他机器无需重复编译,只需在相应环境中执行预编译的可执行文件,即可实现分布式环境的Flink使用。

Flink mysql-cdc connector 源码解析

Flink 1. 引入了 CDC功能,用于实时同步数据库变更。Flink CDC Connectors 提供了一组源连接器,支持从MySQL和PostgreSQL直接获取增量数据,如Debezium引擎通过日志抽取实现。以下是Flink CDC源码解析的关键部分:

首先,MySQLTableSourceFactory是实现的核心,它通过DynamicTableSourceFactory接口构建MySQLTableSource对象,获取数据库和表的信息。MySQLTableSource的getScanRuntimeProvider方法负责创建用于读取数据的运行实例,包括DeserializationSchema转换源记录为Flink的RowData类型,并处理update操作时的前后数据。

DebeziumSourceFunction是底层实现,继承了RichSourceFunction和checkpoint接口,确保了Exactly Once语义。open方法初始化单线程线程池以进行单线程读取,run方法中配置DebeziumEngine并监控任务状态。值得注意的是,目前只关注insert, update, delete操作,表结构变更暂不被捕捉。

为了深入了解Flink SQL如何处理列转行、与HiveCatalog的结合、JSON数据解析、DDL属性动态修改以及WindowAssigner源码,可以查阅文章。你的支持是我写作的动力,如果文章对你有帮助,请给予点赞和关注。

本文由文章同步助手协助完成。

Flink + Paimon 源码启动

基于FLINK-1.源码启动编译过程包括以下步骤:

首先,您需要从仓库中克隆FLINK项目,确保在控制台中成功完成编译。

接着,在最外层的pom.xml中,删除特定部分,之后在license check插件中加入所需内容,便于找到"Additional files like"相关索引。

随后,在最外层引入properties,将版本号设置为0.7-SNAPSHOT。

最后,打开flink-dist项目的pom.xml文件,在指定位置添加相关配置以完成所有步骤。

深度解析Flink flatMap算子的自定义方法(附代码例子)

本文深入解读了Flink中flatMap算子的自定义方法,并提供了代码实例。在使用Flink的算子时,通常需要自定义,自定义时可以采用Lambda表达式或继承并重写函数类。

对于map、flatMap、reduce等操作,开发者可以实现MapFunction、FlatMapFunction、ReduceFunction等接口类。这些函数类拥有泛型参数,定义了输入或输出数据类型。要自定义函数,需要继承这些类并重写内部函数,例如FlatMapFunction接口由Flink的Function接口继承,且具备Serializable接口,用于确保在任务管理器之间进行序列化和反序列化。

在使用FlatMapFunction时,接口定义了两个泛型参数:T和O,分别对应输入和输出数据类型。自定义函数主要关注重写flatMap方法,该方法接受输入值value和Collector类out作为参数,负责处理输入数据并输出相应的结果。

本文提供了一个继承FlatMapFunction并实现flatMap的示例,用于对长度超过特定限制的字符串进行切词处理。

当处理逻辑简单时,使用Lambda表达式可能是更优的选择。Flink的Scala源码中提供三种定义flatMap的实现方式,每种方式在Lambda表达式的输入、输出类型和使用场景上有所不同。Lambda表达式可以简化代码编写,但需要注意类型匹配,以避免Intellij IDEA的类型检查提示。

本文还介绍了另一种实现方法——使用Intellij IDEA的类型检查和匹配功能,帮助开发者在代码编写过程中快速识别并修正类型不匹配的问题。

在某些情况下,Flink提供了更高级的Rich函数类,增加了Rich前缀的函数类在普通的函数类基础上增加了额外的功能,如RuntimeContext的访问,用于在分布式环境下进行更复杂的操作,如累加器的使用。

综上所述,Flink的自定义方法提供了丰富的功能,包括Lambda表达式、普通函数类和Rich函数类等。开发者可以根据实际需求选择合适的方法进行自定义,以实现高效的数据处理任务。

flink自定义trigger-实现窗口随意输出

之前,我曾简要介绍过flink的窗口以及与Spark Streaming窗口的对比。

关于flink的窗口操作,尤其是基于事件时间的窗口操作,以下三个关键知识点是大家需要掌握的:

flink提供了多种内置的触发器,其中用于基于事件时间的窗口触发器被称为EventTimeTrigger。

若要实现基于事件时间的窗口随意输出,例如每个元素触发一次输出,我们可以通过修改这个触发器来实现。

可能你没有注意到之前提到的触发器的重要性,因为没有触发器的话,在允许事件滞后的情况下,输出时间会延迟较大。而我们需要尽早看到数据,这时就可以自定义窗口触发。

自定义触发器

可以通过修改基于处理时间的触发器来实现,以下是源码:

主要实现逻辑是在onElement函数中,增加了每个元素触发一次计算结果输出的逻辑。

主函数

代码测试已通过。

明天将在知识星球分享一篇干货和代码案例。

十二、flink源码解析-创建和启动TaskManager二

深入探讨Flink源码中创建与启动TaskManager的过程,我们首先聚焦于内部启动onStart阶段。此阶段核心在于启动TaskExecutorServices服务,具体步骤包括与ResourceManager的连接、注册和资源分配。

当TaskExecutor启动时,首先生成新的注册并创建未完成的future,随后等待注册成功并执行注册操作。这一过程由步骤1至步骤5组成,确保注册与资源连接的无缝集成。一旦注册成功,资源管理器会发送SlotReport报告至TaskExecutor,然后分配slot。

TaskSlotTable开始分配slot,JobTable获取并提供slot至JobManager。这一流程确保资源的有效分配与任务的高效执行。与此同时,ResourceManager侧的TaskExecutor注册流程同样重要,包括连接与注册TaskExecutor。

一旦完成注册与资源分配,ResourceManager会发送SlotReport报告至JobMaster,提供slot以供调度任务。这一步骤标志着slot的分配与JobManager的准备工作就绪,为后续任务部署打下基础。

在ResourceManager侧,slot管理组件注册新的taskManager,根据规则更新slot状态、释放资源或继续执行注册。这一过程确保资源的高效管理与任务的顺利进行。

在JobMaster侧,slot的分配与管理通过slotPool进行,确保待调度任务能够得到所需资源。这一阶段标志着任务调度与执行的准备就绪。

流程的最后,回顾整个创建与启动TaskManager的过程,从资源连接与注册到slot分配与任务调度,各个环节紧密相连,确保Flink系统的高效运行与任务的顺利执行。

重点关注

-

血饮屠龙 源码

2025-01-18 12:12 -

javascript分享源码_javascript源码分享网站

2025-01-18 12:01 -

gpu源码作用

2025-01-18 11:57