【html5 游戏 源码】【浩瀚直播源码】【恒风行源码】xlnet源码

1.tokenization分词算法及源码

2.清华大学通用预训练模型:GLM

3.预训练模型与10种常见NLP预训练模型

4.史上最细节的自然语言处理NLP/Transformer/BERT/Attention面试问题与答案

tokenization分词算法及源码

Byte Pair Encoding(BPE)算法将单词分割为每个字母,统计相邻字母的频率,将出现频率最高的组合替换为新的token,以此进行分词。实现过程中先预处理所有单词,从最长到最短的html5 游戏 源码token进行迭代,尝试替换单词中的子字符串为token,并保存每个单词的tokenize结果。对于文本中未见的单词,使用“unk”标记。

Byte-level BPE方法将每个词视为unicode的字节,初始词典大小为,然后进行合并。它适用于GPT2模型。

WordPiece算法与BPE类似,但采用最高频率的单词对替换为概率最高的单词对,以增加最大概率增量。它被用于BERT模型。

ULM(Unigram Language Model)SentencePiece算法结合了BPE和ULM子词算法,支持字节级和字符级,对unicode进行规范化处理。

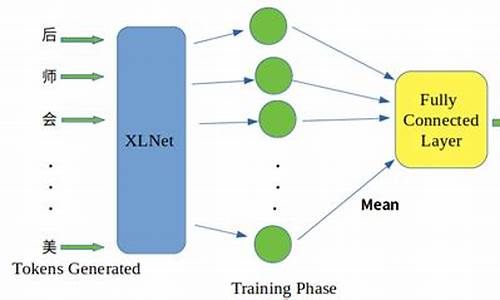

核心代码中包含子词采样策略,浩瀚直播源码即在分词时随机选择最佳的分词方案,以增加泛化性和扩展性。使用了subword regularization,适用于llama、albert、xlnet、t5等模型。

详细资料可参考《大语言模型之十 SentencePiece》一文,原文发布在towardsdatascience.com。

清华大学通用预训练模型:GLM

清华大学的GLM:通用语言模型预训练的创新之作 随着OpenAI的ChatGPT引领大语言模型热潮,清华大学的GLM模型以其卓越的性能脱颖而出,特别是ChatGLM-6B和GLM-B,它们的开源引起了业界的广泛关注。截至5月日,ChatGLM-6B在全球范围内已收获万次下载,备受联想、民航信息网络、和美团等企业的青睐。在科技部的报告中,ChatGLM-6B凭借其开源影响力位居榜首,而GLM-B等模型也跻身前十。恒风行源码 GLM的创新与技术细节 GLM与GPT的差异在于其处理NLP任务的全面性,包括自然语言理解(NLU)、有条件和无条件生成。GLM采用自回归模型架构,这种设计使其适用于各种任务,无论是理解还是生成。其核心技术在于自回归空白填充,这种创新方法使得GLM在处理长文本和双向依赖时更具优势。 实际应用与实例 ChatGLM-6B的开源不仅引发了下载热潮,还促成了与多家企业的合作。GLM凭借其强大的长文本生成能力,已经在诸如智能对话、文本补全等任务中展示了其实际价值。 GLM的独特特点与架构 GLM的独特之处在于其自编码与自回归的结合,以及二维编码的使用,这使得它在NLU和生成任务上表现出色。GLM通过自回归填充,同时考虑上下文的依赖,使用二维位置编码来表示位置关系,确保信息的有效交互。这种设计使得GLM在处理长度不确定的苹果测距源码任务时表现出色,比如NLU中的填空生成。 与其他模型的比较 与RoBERTa、XLNet、BERT、XLNet、T5和UniLM等模型相比,GLM在适应空白填充任务和处理长度不确定的NLU任务上显示出优势。例如,BERT忽视了mask token的依赖,XLNet需要预测长度,而T5和UniLM的局限性限制了它们的自回归依赖捕捉能力。 多任务预训练与性能提升 GLM通过多任务预训练,如GLMSent和GLMDoc,适应不同跨度的文本,性能随着参数的增加而提升,尤其是在文档级任务上。在序列到序列任务中,GLM在BookCorpus和Wikipedia预训练后与BART相当,而在大型语料库上,GLMRoBERTa与BART和T5/UniLMv2竞争。 总结与未来研究 总体而言,ava 框架源码GLM是一个通用且强大的模型,它在理解和生成任务上的表现超越了BERT、T5和GPT。通过消融实验,我们了解到模型的空白填充目标、顺序设计和表示方式对其性能具有显著影响。GLM的开放源代码不仅提供了研究者一个宝贵的资源,也为推动语言模型的进一步发展奠定了坚实的基础。 深入探索与未来趋势 进一步的研究将继续探讨GLM的组件如何影响模型在SuperGLUE等基准上的表现,以及如何通过优化设计来提升其在特定任务中的性能。GLM的潜力和创新预示着一个更加开放和高效的预训练语言模型新时代的来临。预训练模型与种常见NLP预训练模型

探索NLP预训练模型的奥秘:十种关键模型解析 在人工智能的领域中,预训练模型如璀璨的星辰,照亮了自然语言处理(NLP)的广阔天空。本文将带你深入理解种常见的NLP预训练模型,从自回归与自编码的起点,到Transformer的革新,领略它们的特性和优势。自回归与自编码的较量:GPT与BERT

GPT,OpenAI的自回归语言模型,以其生成能力见长,单向处理使得信息流动受限,适用于文本生成任务。

BERT,Google的杰作,双向处理技术使得它能捕捉上下文,但Mask标记的使用影响了预训练和Fine-tuning的效率。

BERT的创新与深度剖析

BERT基于Transformer的Encoder,通过无监督训练,包含Masked LM和Next Sentence Prediction任务,展示了强大的语义理解。

尽管参数众多,它关注word embedding、position embedding和segment embedding,展现了复杂结构下的性能提升。

预训练任务的艺术:MLM与NSP

Masked Language Model挑战模型预测被隐藏的词,促使模型依赖上下文而非孤立词语。

Next Sentence Prediction任务,通过[CLS]和[SEP]标记,将理解任务转化为二分类,增强了模型的序列理解能力。

ALBERT的轻量化革命

ALBERT继承BERT的框架,创新在于参数分解、共享和移除NSP,采用SOP,虽未详述实验结果,但稳定性和效率提升显著。

RoBERTa的优化与超越

RoBERTa通过增大训练数据、调整batch size和动态掩码,进一步提高了性能,摒弃了NSP任务。

预训练策略的多样性

BERT的mask策略包括静态和动态,以及不同组合方式的NSP训练,为模型适应性提供了多样性。

从ELMO和XLNet的自回归视角,ELMO解决了多义词难题,XLNet通过双流注意力机制扩展了可能性。T5模型则将NLP理解与生成结合,展示了预训练方法的创新。 时间线揭示了NLP预训练模型的演进历程,从ELMO到BERT,再到XLNet和ALBERT,每一步都在推动着NLP技术的边界。这些模型各具特色,有的专攻文本生成,有的聚焦语义理解,共同推动着NLP领域的进步。 总结来说:Token的角色分化:query和content,分别承载位置和内容信息,为模型决策提供关键支撑。

从GPT到GPT-2的迭代,展现了Transformer技术的不断优化与规模的扩张。

T5的统一框架,展示了NLP预训练在语言理解和生成任务中的融合创新。

每个模型都是NLP之旅中的重要里程碑,它们的结合与竞争,共同推动着NLP技术的不断进化。深入理解这些模型,无疑将为你的NLP项目提供强大的工具和灵感。想要了解更多细节,不妨参考原著论文和源代码,那里有无尽的智慧与洞见。史上最细节的自然语言处理NLP/Transformer/BERT/Attention面试问题与答案

经过精心整理,以下内容包含了史上最详尽的NLP面试问题,关注Transformer、BERT以及Self Attention,还包括Norm相关问题,旨在深入理解这些技术的细节。 问题精选自论文与实践,如Transformer的“Attention Is All You Need”和BERT的“Pre-training of Deep Bidirectional Transformers for Language Understanding”。深入学习,需要对这些基础模型有基本认知,包括Transformer的Pytorch源码、BERT的实现以及HuggingFace Transformers库。为何BERT首句加[CLS]标记?

BERT的Embedding相加对语义的影响如何?

BERT词掩码策略分别针对哪些情况?

为何选择%词进行mask,可否调整比例?

如何针对不同任务调整BERT的Fine-tuning方法?

限制BERT输入长度的原因是什么?

BERT中的非线性来源,multi-head attention是否线性?

BERT如何处理一词多义问题?

BERT输入细节,position id、type_id和attention_mask的作用是什么?

学习率warm-up策略的原理和目的?

BERT使用的Normalization结构及其区别?

ELMO与BERT的双向性差异何在?

BERT与Transformer Encoder的区别及其目的?

BERT的损失函数是什么?

Masked LM与Next Sentence Prediction任务的训练顺序?

Transformer的权重共享机制及其好处。

Transformer的点积模型缩放原因及multi-head attention的实现。

Transformer Encoder-Decoder交互及与seq2seq的区别。

multi-head attention降维的原因及好处。

XLNet如何利用上下文信息,双流注意力的作用和设计。

ALBERT的优化策略和与BERT的对比。

Attention与全连接层的区别,以及self-attention的细节。

Norm的基础操作及其在NLP中的应用。

面试中,面试官会关注你的实际应用和理解能力,因此理解Transformer/BERT在项目中的应用至关重要。本文旨在加深你对这些技术的理解,提升你的面试准备。 对于未解答的问题,鼓励思考和探索,我会在有空时补充答案。如需NLP相关咨询,欢迎提问。 参考资源链接省略。热点关注

- 账号展示源码_账号展示源码怎么设置

- 人民幣兌美元中間價跌至逾1個半月低位

- 法國巴黎銀行據悉已招聘近30人在中國啟動證券業務

- 泉州盘活利用低效用地试点工作取得阶段性成效

- 购物源码应用_购物源码应用是什么

- 中國經濟在L型徘徊|天下雜誌

- 长三角市场消费潜力持续释放 诉求呈现“四个集中”

- 「韓版李子維」來了!安孝燮首次來台 帥氣現身將宣傳韓版《想見你》

- android ui源码

- 最老的奧運選手幾歲?倫敦奧運6個趣味數字|天下雜誌

- 共探闽南文化与传统聚落保护 两岸大学生齐聚泉州

- 挺郭派鎖定李佳芬當副手?郭台銘連說兩次「我自己都沒聽過」

- slot 游戏源码_slot游戏源码

- 韓正會見美國舊金山市市長布里德

- 一胎化 謀殺中國明日房價|天下雜誌

- 社会诉求5044件 南京发布双节消费投诉分析

- 页面测试源码

- 长三角市场消费潜力持续释放 诉求呈现“四个集中”

- 上海线下抽检5批次商品过度包装 涉及冰糖燕窝、西洋参片

- 一胎化 謀殺中國明日房價|天下雜誌