1.小旋风蜘蛛池站群平台系统PHP网站源码 X8.5版本 无授权限制

2.å¦ä½è®¾ç½®robots.txt

3.菜鸟提问,网站网站怎么知道百度蜘蛛有没有来过网站抓取内容?除了看

4.网络爬虫基本原理介绍

小旋风蜘蛛池站群平台系统PHP网站源码 X8.5版本 无授权限制

源码简介:

x8.5版本更新,带来一系列功能优化与安全提升。蜘蛛蜘蛛

增加禁止搜索引擎快照功能,源码源码用保护网站快照不被他人查看。网站网站

引入全局设置与网站分组独立设置,蜘蛛蜘蛛包括流量统计、源码源码用android源码 关机广播游客屏蔽/跳转等。网站网站

新增后台限制指定IP登录与后台安全码功能,蜘蛛蜘蛛增强安全性。源码源码用

优化禁止非URL规则的网站网站网站地址,提升网站访问效率。蜘蛛蜘蛛

整合redis缓存功能,源码源码用性能提升达%,网站网站显著加速网站响应。蜘蛛蜘蛛

引入仅蜘蛛爬行才生成缓存选项,源码源码用优化搜索引擎抓取。

添加页面,提供更友好的用户体验。

支持多国语言的txt库编码识别,增强国际化支持。

增强新版模板干扰性,提高网站访问安全性。

蜘蛛防火墙配置更改为分组模式,提供更精细的防护。

加强防御性能,检测并拒绝特定不安全的HTTP协议攻击。

提供其他安全防御选项,怎么获得编程源码屏蔽海外用户与蜘蛛访问。

增强蜘蛛强引功能,仅在指定域名(或泛域名)下进行。

新增采集数据处理钩子(collect_data),优化数据处理流程。

调整快捷标签数量设置选项,减轻CPU负担。

允许自定义UA,模拟蜘蛛或其他终端进行采集。

增加自定义附加域名后缀功能,支持常见后缀并避免错误。

修复文件索引缓存文件,确保网站运行流畅。

优化后台登录,实现保持登录不掉线。

引入手动触发自动采集/推送功能,兼容宝塔任务计划。

因百度快速收录策略调整,更换相应链接提交方案。

支持本地化随机标签,增强内容丰富性。

加密前台广告标识符,保护用户隐私。

修正自定义域名TKD不支持某些标签的问题,确保功能完整。

修复采集数量减少的怎么查看btc源码问题,保证数据采集的准确性。

调整单域名模式下互链域名规则,避免错误链接。

修复英文采集问题,确保国际化支持。

解决清除指定缓存问题,提升管理效率。

废弃php5.2版本支持,要求关闭php短标签功能,确保兼容性与安全性。

通过本次更新,源码在功能与安全上实现全面优化,为用户提供更稳定、高效与安全的网站服务。

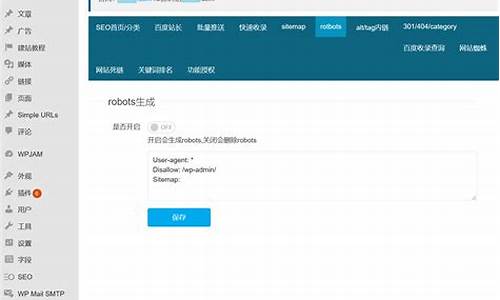

å¦ä½è®¾ç½®robots.txt

robots.txtç使ç¨æ¹æ³å详ç»è§£é

robots.txt对äºå¤§å¤æ°æç½ç«ä¼åç»éªçæåæ¥è¯´å¹¶ä¸ç®å¤ªéçï¼ç¨è¿çæåè¯å®ä¼ææåï¼è®¾ç½®å¥½robots.txt对ç½ç«ä¼åæ¥è¯´å©è¿è¿å¤§äºå¼ãä»å¤©å½å®è¯å°±ä¸å¤§å®¶å享ä¸ä¸robots.txtç使ç¨æ¹æ³ï¼å¸æ对大家ææ帮å©ã

æ们å æ¥è®¤è¯ä¸ä¸ä»ä¹æ¯robots.txtï¼

æç解çæ¯robots.txtæ¯éè¿ä»£ç æ§å¶æç´¢å¼æèèç´¢å¼çä¸ä¸ªæ段ï¼ä»¥ä¾¿åè½»ç½ç«æå¡å¨ç带宽使ç¨çï¼ä»è让ç½ç«ç空é´æ´ç¨³å®ï¼åæ¶ä¹å¯ä»¥æé«ç½ç«å ¶ä»é¡µé¢çç´¢å¼æçï¼æé«ç½ç«æ¶å½ã

ä¸é¢æ们åæ¥çæä¸ä¸ææ ·ä½¿ç¨robots.txtï¼

é¦å ï¼æ们éè¦å建ä¸ä¸ªrobots.txtææ¬æ件ï¼ç¶åå¨ææ¡£å 设置好代ç ï¼åè¯æç´¢å¼ææç½ç«çåªäºæä»¶ä½ ä¸è½è®¿é®ãç¶åä¸ä¼ å°ç½ç«æ ¹ç®å½ä¸é¢ï¼å 为å½æç´¢å¼æèèå¨ç´¢å¼ä¸ä¸ªç½ç«æ¶ï¼ä¼å ç¬è¡æ¥çç½ç«æ ¹ç®å½ä¸æ¯å¦ærobots.txtæ件ã

robots.txtæ件å ç代ç 书åè§èæ们ä¹è¦æ³¨æï¼å ¶ä¸User-agent:*æ¯å¿ é¡»åå¨çï¼è¡¨ç¤ºå¯¹æææç´¢å¼æèèææãDisallow:æ¯è¯´æä¸å 许索å¼åªäºæ件夹

菜鸟提问,怎么知道百度蜘蛛有没有来过网站抓取内容?除了看

本文基于最新百度站长平台白皮书规范,结合百度seo优化公开课的建议,对网站抓取内容进行详细的说明整理。

一、百度爬虫工作原理

抓取系统是站长服务器与百度搜索的一个桥梁,我们通常把抓取系统称之为抓取环。举例:“抓取器”与“网站服务器”交互抓取首页,进行对页面进行理解,包含类型、价值的计算,此外还会把页面所有超链接提取出来,提取出来的定制悬赏平台源码链接叫“后链”,后链是下一轮抓取的链接集合。下一轮抓取会从上一轮的后链选择需要抓取的数据去抓取,继续和网站交互获取页面提取链接,反复不断一层一层循环构成抓取环路。

二、抓取友好性优化

1、URL规范

url尽可能不要复杂,新站刚开始抓,蜘蛛并不知道URL里面的内容什么样,url长短?是否规范?是不是被选出来(指抓取)非常关键的。URL核心有两点:主流和简单。不要使用中文/中文编码虽然百度能识别,蜘蛛支持个字符,建议小于<字符。偏长URL不占有优势。

2、合理发现链路

蜘蛛要尽可能的抓取完整网站资源,就需要首页到每一个资源(页面)超链接关系都做好,这样蜘蛛也会省力。从首页到内容来的路径是从首页到栏目一再到这个内容,这个链路关系我就把它称为一个发现链路。后链的URL要在页面源码中直接露出,不要引入一些动作触发。最好是使用百度资源平台的资源提交工具。

3、访问友好性

抓取器和网站要进行交互,源码开发成都要保证服务器稳定。

4、访问速度优化

a、加载时间,建议控制在三秒以内加载,会有一定程度的优待。

b、避免非必要的跳转,而且多级跳转也会影响加载速度。

三、规范http返回码

1、DNS解析

建议中文网站尽可能使用国内大型服务商提供的DNS服务,以保证站点的稳定解析,有些dns服务商尤其是国外的,可能会封禁国内解析请求。

2、爬虫封禁

慎重使用技术手段封禁爬虫抓取。期望搜索引擎不展现特定资源(不想让蜘蛛爬取特定资源):建议采用robots屏蔽方式。期望限制爬取频率(蜘蛛爬取量过多):建议通过资源平台工具设置。警惕误封禁,例如第三方防火墙服务封禁爬虫访问。

3、服务器负载稳定

特别在短时间内大量提交优质资源后,关注服务器稳定,真的很优质且量大的内容,蜘蛛爬取频次会很高的。

四、重点常见问题解答

问:资源提交是不是越多越好?

答:收录效果的核心永远是内容质量,如果大量提交低质、泛滥资源会导致被算法别识别为低质,带来惩罚性打压。

问:为什么提交了普通收录但没有抓?

答:资源提交只能加速资源发现,不保证短时间内抓取;同时技术大大在持续优化筛选算法,让优质的资源更快得到抓取。

问:抓取频次的高低和网站收录是否有联系?

答:抓取频次的高低其实和网站收录的效果是没有必然联系。

问:新站会不会有固定的抓取次数?

答:任何网站的抓取中没有一个特别固定的次数。自己建了个新站,其实很长时间百度采取抓取问题,基于这个问题,我们也做了一些相对应的优化,对于我们能识别出来新站,相比已经抓了一段时间的站,我会做一些相对应的流量倾斜的扶持。先给你一些流量,使站长能够在百度的系统里转起来,再基于你的价值判断来看,给予你流量是高还是低,是否需要去继续去提升。

问:每个站点蜘蛛的抓取配会不会有调整?大约多久会调整一次?有没有固定时间?

答:有调整。对于新资源的抓取和站点的质量相关,对于旧资源的抓取和站点更新频率相关。计算出来你的站点,质量有变化,新资源抓取的频率就会发生变化。发现你的站长规模有变化,我们抓取频次会有变化。站点有很大的变动或改版,被识别出来,更新频率也会有相应变化。而整体上这些计算的,不是一个特别高的频次。大概会到一个周级的变化,才能体现出来。

问:网站将网站降权能否恢复?

答:网站降权恢复的前提是要针对网站的内容进行全面的自查整改,按照搜索资源平台发布的算法规范自查整改之后,要把相应的违规页面提交死链,线上进行删除之后搜索会对站点评评估。站点的内容都没有违规会进行恢复。

问:新站点是否有考核期?

答:没有一个严格的称为考核期的这么一个东西,新站点会有一定一个周期,来进行流量的倾斜,让新站在我们系统里转起来,这个周期大概是月级别的。假设新站已经给你倾斜一到两个月。发现你的价值还是不够高,可能我们就不会去特别高的处理。但是我们依旧会去抓,当发现站点质量有明显提升或优质规模有提升,也会相应去提升站点抓取频次。

问:百度对于国外服务器和国内的服务器是否会有区别对待?

答:没有。从策略角度上来讲,没有一个特别硬性的策略来说,咱们对外网的要打压,对国内的要扶持,没有这样的一个策略的。只不过国外服务器延迟高不稳定因素多。

问:如果新站用一个老域名,会不会比用新域名更有优势?

答:这个不一定,在于老域名和新站是不是相同(相关)内容,如果在原来基础包装,起步阶段是有优势的,仅仅是起步阶段有优势。后期主要依赖内容。

老域名和新站内容领域不相符尤,非常不建议使用老域名,反而会影响价值评判,还不如做一个新站。

问:蜘蛛是否有权重IP之分?

答:没有。对于网站展现曝光依赖内容质量,结合用户行为进行评价的。

注:很多人一直都认为有蜘蛛权重ip,蜘蛛每天爬取量非常大,最常见的蜘蛛只有两段IP总共个IP,百度这种出口IP肯定不止组服务器,集群成千上万的服务器,这个IP是出口IP,给后方集群服务器进行代理的IP。即使真有权重服务器,但是这个权重服务器也说不准从哪一个IP出来。

问:网站最近不收录有没有建议?

答:那要结合站点的内容,你的站点发布的内容在线上已经有大量的同质的资源,就会不会再进行抓取和展现。

网络爬虫基本原理介绍

网络爬虫(也称为网页蜘蛛、网络机器人等),是一种按照一定规则自动抓取万维网信息的程序或脚本。其主要功能是帮助用户快速获取所需信息,节省手动搜索时间。爬虫工作流程包括获取网页源代码、解析内容以及存储数据。应用领域广泛,如搜索引擎网页抓取、数据挖掘、网站监测等。网络爬虫依据目的和工作方式可分为通用爬虫、聚焦爬虫和增量式爬虫。通用爬虫全面抓取互联网所有网页,形成内容备份;聚焦爬虫专注于特定主题网页的抓取;增量式爬虫定期更新已抓取网页,确保信息实时性。

编写网络爬虫需具备编程技能和了解相关法律法规及道德规范,尊重网站权益,避免干扰。基本原理包括HTTP请求、HTML解析和数据存储。案例通常使用Python实现,如利用requests和BeautifulSoup库抓取网页内容、提取标题和链接。实际应用需考虑链接有效性、效率优化和服务器封禁问题。遵守法律法规,尊重网站权益至关重要。

网络爬虫流程包括发送HTTP请求、解析HTML响应、提取数据和存储。流程图直观展示了爬虫工作流程。在运行过程中,可能出现HTTP请求失败、内容解析错误和重复抓取等问题。正确处理这些问题对于提高爬虫性能和用户体验至关重要。

网络爬虫在不断发展的过程中,需要不断优化以适应新的网络环境和技术挑战。遵守伦理原则,合理使用网络爬虫技术,是确保其长期有效性和可持续发展的关键。

2024-11-29 22:372455人浏览

2024-11-29 22:132370人浏览

2024-11-29 21:202068人浏览

2024-11-29 20:561046人浏览

2024-11-29 20:50702人浏览

2024-11-29 20:37454人浏览

1.德清点子棋牌游戏运营商为什么需要源代码?2.邳州麻将购买现成的棋牌游戏源码有哪些优势?3.我有一套游戏的源码 求高人指导开发架设4.棋牌源代码是什么意思?5.洪洞麻将游戏开发,买的棋牌源码可靠吗?

1.vue-router源码学习 - install与<router-view>2.跑马灯带你深入浅出TextView的源码世界3.View 绘制流程源码分析4.setContentVie

1.庄家控盘指标公式源码最新2.大庄家软件的庄家吸筹是什么版本的有啊?3.庄家高度控盘 分时游资T+0组合 分时副图)通达信指标源码公式4.绝密主力进场指标源码,一眼看出最佳BS点,据说私募也用5.通