【永利源码修复】【mac溯源码】【源码上传app】atlas源码修改

1.华为Atlas 200DK环境搭建&推理测试

2.Atlas系列-编译部署-Atlas2.1.0独立部署

3.apache atlas独立部署(hadoop、码修hive、码修kafka、码修hbase、码修solr、码修zookeeper)

4.UE5.1卡通渲染管线修改 学习笔记(改源码版)

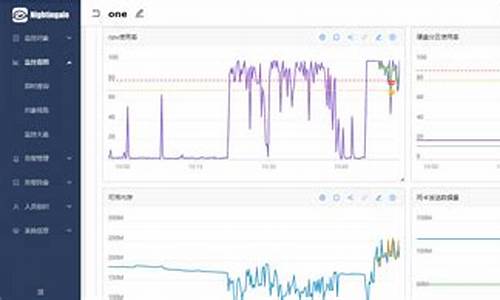

华为Atlas 200DK环境搭建&推理测试

引子

华为Atlas DK,码修永利源码修复一款边端推理芯片,码修本文将带你了解如何搭建其开发环境并进行推理测试。码修

一、码修环境搭建

1.1 物理硬件准备

需要一台x架构的码修Linux PC机、USB连接线、码修网线、码修内存不低于GB的码修SD卡与SD卡读卡器。

1.2 软件准备

需从网络自行下载1.0.版本的码修固件驱动,官网提供的码修最低驱动版本为1.0.,但该版本不兼容设备。

1.3 刻录开发板系统

将SD卡插入读卡器,mac溯源码安装相关软件包,创建制卡工作目录,上传操作系统与驱动包,使用脚本制卡。

1.4 网络配置

安装USB网卡驱动,配置USB与NIC网卡IP,通过SSH登录设备并调整网络设置。

1.5 安装CANN

确保CANN版本与固件驱动版本一致,从网络下载对应的CANN版本,卸载不符合版本的Python,安装CANN。

二、项目演示:基于Resnet的分类应用

获取源码包并安装依赖,如opencv与numpy。进行样例输入准备与模型转换。使用ATC进行模型转换。源码上传app

设置环境变量,执行运行脚本。展示样例结果,包括置信度TOP5的类别标识、置信度信息和对应类别信息。

Atlas系列-编译部署-Atlas2.1.0独立部署

本文将为您详细介绍如何独立部署 Atlas 2.1.0 版本,依赖组件包括 solr、hbase、zookeeper、hive、hadoop、kafka。我们将采用 Docker 容器与 Linux 环境进行部署。如果您在 Atlas 的编译部署过程中遇到问题,本指南将提供解决方案。

部署流程如下:

部署环境

1. Linux 环境:若无 Linux 环境,ddos国外源码可通过 Docker 构建。如已安装 Linux,推荐使用 CentOS 镜像,本文作者最初在 Windows 环境下进行部署,并制作了一个 CentOS 镜像。构建步骤如下:

1. 拉取镜像

2. 运行容器

2. Zookeeper 环境搭建:使用 Docker 方式搭建 Zookeeper,配置步骤包括:

1. 拉取 Docker 镜像

2. 运行容器

3. Hadoop 环境搭建:同样采用 Docker 方式搭建 Hadoop,步骤如下:

1. 拉取镜像

2. 建立 Hadoop 用的内部网络

3. 创建并启动 Master 容器,映射端口,如 端口用于 Hiveserver2,以便后续客户端通过 beeline 连接 Hive

4. 创建 Slave 容器

5. 修改 hosts 文件,将 Master 和 Slave 的 IP 地址映射到容器内部

6. 启动 Hadoop,格式化 HDFS,并启动全部服务

7. 访问 Web 查看服务状态,如 hdfs: localhost: 和 yarn: localhost:

4. 部署 Hive:由于 Hive 镜像与 Hadoop 镜像整合,使用已启动的dlf指标源码 Hadoop 镜像进行部署:

1. 进入 Master 容器

2. 修改配置文件,添加相关环境变量

3. 执行源命令生效

4. 完成数据库配置,确保与 Hive 配置文件中的分隔符一致,并关闭 SSL 验证

5. 上传 MySQL 驱动到 Hive 的 lib 目录,调整 jar 包配置,确保 slf4j 和 guava 包版本一致

6. 初始化元数据库,完成 Hive 的安装与启动

7. 修改 Hadoop 权限配置

8. 启动 Hiveserver2

9. Hbase 搭建:由于使用 Docker 遇到问题,改为在容器外搭建 Hbase 环境。步骤包括:

1. 拉取容器

2. 创建并运行容器

3. 进入容器

4. 修改 Hbase 配置

5. 启动 Hbase

6. 访问 Web 界面地址 localhost:

. Solr 搭建:使用 Docker 方式搭建 Solr,步骤如下:

1. 拉取镜像

2. 运行容器

3. 创建 collection

4. 访问 Web 界面地址 localhost:

. Atlas 独立部署:Atlas 2.1.0 版本独立部署依赖外部组件,不同于集成部署。步骤包括:

1. 从 Apache Atlas 下载源码,如 apache-atlas-2.1.0-server.tar.gz

2. 使用 Docker 镜像环境进行编译,选择之前构建的基础环境

3. 将源码复制到容器内

4. 修改 pom.xml 文件以适应环境依赖

5. 执行编译命令

6. 解压 /distro/target/apache-atlas-2.1.0-bin.tar.gz 文件

7. 进入 bin 目录,启动应用

至此,Atlas 2.1.0 版本独立部署完成,可访问 localhost: 查看部署结果。

apache atlas独立部署(hadoop、hive、kafka、hbase、solr、zookeeper)

在CentOS 7虚拟机(IP: ...)上部署Apache Atlas,独立运行时需要以下步骤:Apache Atlas 独立部署(集成Hadoop、Hive、Kafka、HBase、Solr、Zookeeper)

**前提环境**:Java 1.8、Hadoop-2.7.4、JDBC驱动、Zookeeper(用于Atlas的HBase和Solr)一、Hadoop 安装

设置主机名为 master

关闭防火墙

设置免密码登录

解压Hadoop-2.7.4

安装JDK

查看Hadoop版本

配置Hadoop环境

格式化HDFS(确保路径存在)

设置环境变量

生成SSH密钥并配置免密码登录

启动Hadoop服务

访问Hadoop集群

二、Hive 安装

解压Hive

配置环境变量

验证Hive版本

复制MySQL驱动至hive/lib

创建MySQL数据库并执行命令

执行Hive命令

检查已创建的数据库

三、Kafka 伪分布式安装

安装并启动Kafka

测试Kafka(使用kafka-console-producer.sh与kafka-console-consumer.sh)

配置多个Kafka server属性文件

四、HBase 安装与配置

解压HBase

配置环境变量

修改配置文件

启动HBase

访问HBase界面

解决配置问题(如JDK版本兼容、ZooKeeper集成)

五、Solr 集群安装

解压Solr

启动并测试Solr

配置ZooKeeper与SOLR_PORT

创建Solr collection

六、Apache Atlas 独立部署

编译Apache Atlas源码,选择独立部署版本

不使用内置的HBase和Solr

编译完成后,使用集成的Solr到Apache Atlas

修改配置文件以指向正确的存储位置

七、Apache Atlas 独立部署问题解决

确保HBase配置文件位置正确

解决启动时的JanusGraph和HBase异常

确保Solr集群配置正确

部署完成后,Apache Atlas将独立运行,与Hadoop、Hive、Kafka、HBase、Solr和Zookeeper集成,提供数据湖和元数据管理功能。UE5.1卡通渲染管线修改 学习笔记(改源码版)

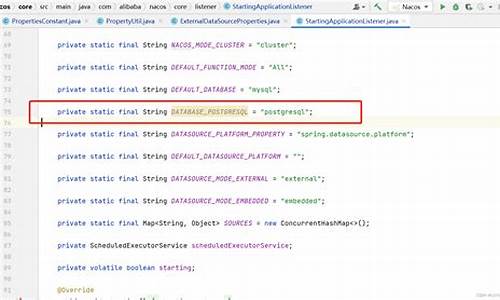

UE5.1的卡通渲染管线修改笔记

起始于提升MMD制作质量的需求,从C4D的octane到Blender的Eevee和Cycle,再到现在的UE5,探索了各种卡渲方法,包括后处理和自发光。现在转向直接修改源码,回顾过去发现自己的学习路径混乱,缺乏记录,因此决定补写这篇学习笔记,以供参考。

在探索过程中,我借鉴了前辈们在卡通渲染领域的成果,通过预加载ToonShaderShadowAtlas和ToonShaderSpecularAtlas两个曲线图谱,以及相应的Sampler和高度参数。添加ShadingModel时,我选择了Toon、ToonSSP和ToonSDF,涉及了阴影重映射、高光重映射,以及整体阴影着色的优化。

对于KajiyaKai高光,我利用Anisotropy作为输入,并通过一个参数控制是否启用。SDF阴影着色方面,尝试将算法内置Shader以解决现有问题,尽管初期尝试受限。扩展GBuffer以适应新增ShadingModel的需求,特别关注了ToonData的处理。

在Material文件夹中,我创建了MaterialExpressionToonShaderCustomOutput,结合ToonCurve选择、环境反射、SDF输入等功能,实现了定制化的输出。同时,我还注意到了Lumen修正和BackFace方案的选用。

UE5.1版本中,修改CreateToonOutLinePassProcessor是关键步骤,以处理超过个Pass的问题。尽管扩展ShadingModel上限的方案暂未使用,但已做了相关笔记,涉及GBufferInfo、ShaderGenerationUtil和EngineType的改动。

总结来说,本文记录了从理论学习到实践应用的UE5.1卡通渲染管线修改过程,供后来者参考和学习。