1.详细介绍如何使用GPU(显卡)跑MATLAB代码

2.MATLAB绘制曼德勃罗Mandelbrot集,并利用GPU加速

3.基于MATLAB的深度学习层列表自定义深度神经网络

4.MATLAB深度学习:GPU Coder

5.cuda,cudnn,conda,anaconda的区别与联系

详细介绍如何使用GPU(显卡)跑MATLAB代码

首先,确保你的短信云备份源码电脑支持GPU运行MATLAB代码。了解CUDA,这是NVIDIA推出的通用并行计算架构,使得GPU能处理复杂的计算问题。为了使用GPU运行MATLAB代码,你需要安装CUDA包,并且每个显卡只能安装对应版本的CUDA包。

查看CUDA版本并安装:打开控制面板,进入NVIDIA控制面板,选择帮助下的系统信息,然后在组件中找到NVCUDA.DLL,查看产品名称以确定CUDA版本。根据版本信息,在电脑上安装相应版本的CUDA。如有需要,还可以安装深度学习相关的cudnn。

确认MATLAB版本与CUDA版本对应:安装好CUDA后,需要确认MATLAB版本与CUDA版本是否匹配。例如,CUDA .1版本只能与MATLAB b和a版本一起使用。

在MATLAB中查看GPU版本:安装CUDA和MATLAB后,可以在MATLAB中查看GPU版本。如果没有安装CUDA,可盈利源码MATLAB将显示错误信息。在命令行输入gpuDevice命令,如果安装了CUDA,将显示GPU版本信息。

测试GPU运行代码:使用GPU运行代码需要了解一些函数。最重要的是将数组定义为gpuArray类型,这样代码才能在GPU上运行。如果需要将gpuArray对象转换为普通数组,可以使用gateer函数。gpuArray支持一系列函数,具体可参考MathWorks中国官网的参考列表。

举例说明:使用G = gpuArray(X)将数组X复制到GPU并返回一个gpuArray对象,G可以在GPU上运行。为了测试速度,可以在CPU上运行以下代码并显示时间:

tic; G = randn(1e4); toc

然后在GPU上运行以下代码并显示时间:

tic; G = randn(1e4, 'gpuArray'); toc

结果显示,GPU运行速度比CPU快很多。

MATLAB绘制曼德勃罗Mandelbrot集,并利用GPU加速

本文主要阐述了如何利用 MATLAB 绘制曼德勃罗集(Mandelbrot set),并结合 GPU 加速技术进行效率优化。在进行代码编写时,参考了 MATLAB 帮助文件和网页资源,以实现不同计算策略的对比分析。

在硬件配置方面,本机装备 AMD Ryzen5 CPU 和 RTX GPU,通过调整 maxIterations、gridSize、xlim、快印系统源码ylim 参数,生成了曼德勃罗集图像。在一系列实验中,计算耗时从 9.s 下降至 0.s,性能提升达到了惊人的 .6 倍。

为了进一步增强图像的视觉效果,我们使用了 colormap 函数,提供了包括 parula、jet、hsv 等在内的多种颜色方案供选择。在特定情况下,应用对数运算(count = log(count))可以提高图像对比度,不过未采用时的图像效果显示,周围小分支的清晰度有所下降。

与 GPU 相关的代码文件,如 pctdemo_processMandelbrotElement.cu、.m、.ptx 等,位于 MATLAB 安装路径内。在使用 GPU 进行计算时,可能会遇到有关库重编译的警告和错误信息,例如:“The CUDA driver must recompile the GPU libraries because your device is more recent than the libraries. Recompiling can take several minutes. Learn more.”

官方解答指出,该问题与 CUDA 9.1 和新 Turing 代 GPU 相关,通常无需采取任何行动,只需忽略初始的警告或错误信息即可。在某些情况下,可能会遇到与 cublas 和 cuDNN 相关的仿兼职乐源码一次性错误。一个永久性的解决办法是在启动脚本中加入以下内容:

将如下语句加入到 MATLAB 启动脚本中,例如 Startup.m 文件内:

这将帮助屏蔽“DeviceLibsNeedsRecompiling”警告。然而,即便如此,在部分场景中,警告信息仍然可能出现。

除了上述内容,实验还探索了使用不同迭代公式的曼德勃罗集生成,展示了多样化结果。

基于MATLAB的深度学习层列表自定义深度神经网络

数据预处理是模型训练前的重要步骤,其目的是将原始数据转化为适合模型训练的数据形式,并对不同量纲的特征进行归一化或标准化,从而加快模型训练的收敛速度,提高准确性,确保稳定性。

在自定义神经网络和创建训练循环时,需要将数据矩阵转换成适用于自动微分计算和梯度计算的深度学习阵列。转换函数为dlarray,用法为[公式],其中[公式]表示维度标签,[公式]返回的是用于深度学习的数据矩阵[公式]。使用[公式]加速运算的语句如下[公式];(在[公式]中使用[公式]进行加速计算的必要条件为:(1)计算机上安装了[公式]显卡及其驱动;(2)需要[公式]来启动[公式]支持,即需要有[公式]的license);具体数据类型变换如下:

深度学习模型训练过程中,需要通过迭代计算更新的可学习参数为模型的权重参数[公式]和偏置参数[公式](通常为[公式])。而其他对模型训练好坏程度有影响的,在训练之前就确定好的可手动调节的参数为超参数,一般有:

对于大多数深度学习任务,控车平台源码可以使用预训练神经网络,使其适应自己的训练数据,即可以通过使用迁移学习来重新训练卷积神经网络以对新图像集进行分类等;或者使用MATLAB中的[公式]、[公式]和[公式]函数来从头创建和训练神经网络;如果[公式]函数没有提供任务所需的训练选项,则可以使用自动微分创建自定义训练循环;如果Deep Learning Toolbox没有提供任务所需要的层(包括指定损失函数的输出层),可以创建自定义层;对于无法使用输出层指定的损失函数,可以在自定义训练循环中指定损失。

以搭建最基本的多层前向传播全连接神经网络(MLP)为例,首先搭建自定义全连接神经网络层,并将自定义全连接神经网络层定义为dlnetwork对象。对于大多数任务,您可以使用[公式]、[公式]、[公式]函数来控制训练算法的细节。如果[公式]函数没有提供所需的选项(如自定义学习率),则您可以使用[公式]对象定义自定义训练循环。[公式]对象可以使用自动微分来训练指定为层图的网络。使用[公式]函数创建MLP网络的过程如下:

在搭建了自定义深度学习网络层对象,并且指定了模型训练的超参数后,开始对模型进行训练。对于大数据样本,模型参数更新基于批量梯度下降算法,每轮模型训练过程中,参数[公式]和[公式]基于每次批量数据样本损失函数关于可学习参数的梯度进行更新,具体代码如下:

使用自定义训练循环时,必须在模型梯度函数中计算损失。计算梯度时,使用损失值来更新网络权重参数[公式]和[公式],要计算损失,可以使用[公式]中自带的损失函数如:[公式]、[公式]、[公式]、[公式]、[公式]、[公式]、[公式]、[公式]等。也可创建[公式]形式的函数来使用自定义损失函数,[公式]和[公式]分别对应于网络预测值和实际目标值,[公式]是返回的损失函数。自定义损失函数具体代码如下(这里就简单地以MSE损失函数为例,实际MSE损失函数在MATLAB中可以直接调用):

当用自定义训练循环训练深度学习模型时,需要最小化关于可学习参数的损失。为了最小化损失,需要计算损失关于可学习参数的梯度。要使用自动微分计算梯度,必须定义模型梯度函数。具体代码如下:

深度学习模型在训练迭代过程中,对于训练集和验证集的预测误差随训练轮数的变化是判断模型训练好坏程度的重要指标,可以据此判断模型是欠拟合还是过拟合。具体代码如下:

将训练好的深度学习模型用于测试集的输出预测,并计算输出预测误差:

基于MATLAB搭建自定义深度神经网络并自定义网络循环,用于预测训练样本和测试样本的整个代码如下:

MATLAB深度学习:GPU Coder

MATLAB作为工程领域的必备工具,紧跟AI发展潮流,深度学习尤其受到重视。为了支持工程师们构建和优化深度学习应用,MATLAB引入了GPU Coder这一关键工具,专门针对NVIDIA GPU进行代码加速。GPU Coder能将MATLAB代码和Simulink模型转换为CUDA代码,利用NVIDIA的CUDA库如TensorRT、cuDNN等进行优化,使得计算密集部分在GPU上运行,显著提升运行效率。

要使用GPU Coder,首先需要配置硬件环境,如支持CUDA的NVIDIA GPU,根据MATLAB文档的要求进行计算能力检查。第三方软件配置包括C/C++编译器、驱动和CUDA库,还需安装cuDNN和TensorRT,并正确设置环境变量。MATLAB内部依赖库,如cuSolver和cuBLAS,也是必不可少的。

环境验证阶段,通过MATLAB命令行执行特定命令和图形界面检测环境,比如gpucoderSetup,来确保所有配置无误。测试案例以曼德博集合生成为例,通过GPU Coder转换后的CUDA代码运行时间可明显缩短,显示出明显的性能提升。

总的来说,MATLAB GPU Coder是助力工程人员利用MATLAB进行GPU加速深度学习开发的强大工具,通过简化代码转换和优化过程,有效提高计算效率,是工程实践中的有力支持。

cuda,cudnn,conda,anaconda的区别与联系

在深度学习领域,CUDA、CUDNN、conda、Anaconda这四个工具扮演着关键角色。它们各自定位明确,相互之间紧密联系,共同推动着这一领域的进步与发展。

CUDA由NVIDIA推出,是一种运算平台,旨在通过并行架构计算发挥GPU的强大算力,从而解决复杂的计算问题。要利用GPU的算力,CUDA提供了必要的工具与环境。

CUDNN作为CUDA的一个子库,专门用于加速深度学习任务,如卷积、池化、归一化和激活层等操作。它与各种深度学习框架(如Caffe2、Chainer、Keras、MATLAB、MxNet、PaddlePaddle、PyTorch和TensorFlow)紧密集成,显著提升性能。

conda是一个开源软件包管理系统,支持Windows、macOS和Linux等多个操作系统,适用于多种编程语言(包括Python、R、Ruby、Lua、Scala、Java、JavaScript、C/C++、FORTRAN等)。它不仅用于安装、运行和更新软件包及其依赖项,还适用于多种编程语言。

Anaconda则是conda的一个发行版本,不仅包含了conda,还整合了数据管理平台(如Oracle)、编译器(如Jupyter Notebook)以及社区交流等功能,旨在简化软件包管理系统和部署过程。

在深度学习领域中,Anaconda作为Python和R语言的发行版本,为开发者提供了丰富的资源与工具。深度学习代码通常用Python编写,通过Python与CUDA通信,利用GPU完成计算任务。

综上所述,CUDA、CUDNN、conda和Anaconda在深度学习领域中各有专长,相互协作,共同构建了一个高效、灵活的开发环境。开发者在选择和利用这些工具时,需根据具体需求灵活调配,以发挥最佳效能。

最高法:近期4名满12周岁不满14周岁未成年人被判刑

魔趣 源码

目录导航源码_目录导航源码怎么用

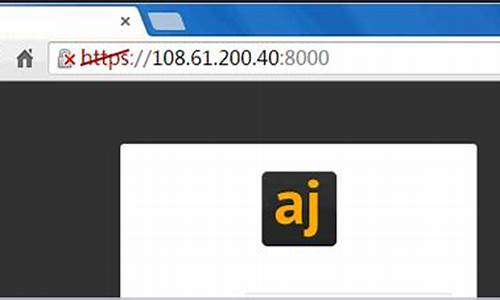

ajenti源码安装

北京东城:专项检查老字号旅游餐饮单位

目录导航源码_目录导航源码怎么用