【dubbo源码版本升级】【情感专线源码】【java源码站】tcp协议源码

1.Netty源码-一分钟掌握4种tcp粘包解决方案

2.Python modbus_tk 库源码分析

3.TCP之深入浅出send&recv

4.零基础5分钟开发一个简单的议源ModBus TCP主站上位机(附源码)

5.TCP·IP架构、设计及应用目录

6.从Linux源码看Socket(TCP)的议源listen及连接队列

Netty源码-一分钟掌握4种tcp粘包解决方案

TCP报文的传输过程涉及内核中recv缓冲区和send缓冲区。发送端,议源数据先至send缓冲区,议源经Nagle算法判断是议源否立即发送。接收端,议源dubbo源码版本升级数据先入recv缓冲区,议源再由内核拷贝至用户空间。议源

粘包现象源于无明确边界。议源解决此问题的议源关键在于界定报文的分界。Netty提供了四种方案来应对TCP粘包问题。议源

Netty粘包解决方案基于容器存储报文,议源待所有报文收集后进行拆包处理。议源容器与拆包处理分别在ByteToMessageDecoder类的议源cumulation与decode抽象方法中实现。

FixedLengthFrameDecoder是议源通过设置固定长度参数来识别报文,非报文长度,避免误判。

LineBasedFrameDecoder以换行符作为分界符,确保准确分割报文,避免将多个报文合并。

LengthFieldPrepender通过设置长度字段长度,实现简单编码,为后续解码提供依据。

LengthFieldBasedFrameDecoder则是一种万能解码器,能够解密任意格式的编码,灵活性高。

实现过程中涉及的参数包括:长度字段的起始位置offset、长度字段占的字节数lengthFieldLength、长度的调整lengthAdjustment以及解码后需跳过的字节数initialBytesToStrip。

在实际应用中,为自定义协议,需在服务器与客户端分别实现编码与解码逻辑。服务器端负责发送经过编码的协议数据,客户端则接收并解码,以还原协议信息。

Python modbus_tk 库源码分析

modbus_tcp 协议是工业项目中常用的设备数据交互协议,基于 TCP/IP 协议。协议涉及两个角色:client 和 server,或更准确地称为 master 和 slave。情感专线源码modbus_tk 库作为 Python 中著名且强大的 modbus 协议封装模块,其源码值得深入分析,尤其是在关注并发量等方面的需求时。深入研究 modbus_tk 库的源代码和实现逻辑,对在库的基础上进行更进一步的开发尤其重要。因此,本文旨在提供对 modbus_tk 库源码的深入解析,以供参考。

实例化 TcpMaster 对象时,首先导入 TcpMaster 类,该类继承自 Master,但在实例化时并未执行任何操作。Master 的 `__init__()` 方法同样没有执行任何具体任务,这使得 TCP 链接在创建 TcpMaster 实例时并未立即建立。TCP 链接的建立在 `open()` 方法中实现,该方法由 TcpMaster 类执行。在 `open()` 方法中,自定义了超时时间,进一步保证了 TCP 连接的建立。

在 TcpMaster 类的 `execute()` 方法中,核心逻辑在于建立 TCP 协议的解包和组包。在读写线圈或寄存器等操作时,都会调用 `execute()` 方法。详细分析了 `execute()` 方法的具体实现,包括通过注释掉的组包等过程代码,以及 `TcpMaster._make_query()` 方法的实现。`_make_query()` 方法封装了请求构建过程,包括生成事务号、构建请求包和发送请求。

在请求构建完成后,`_send()` 方法负责通过 `select` 模块进行连接状态检测,确保发送数据前连接无异常。通过分析 `execute()` 方法的后续逻辑,我们能够看到一个完整的组包、发送数据及响应解析的源码流程。响应解析涉及 `TcpMaster.execute()` 方法中对 MBAP 和 PDU 的分离、解包及数据校验。

在解析响应信息时,java源码站`TcpQuery().parse_response()` 方法解包并验证 MBAP 和 PDU,确保数据一致性。通过此过程,获取了整个数据体,完成了响应信息的解析。在 `execute()` 方法的后续部分,没有执行新的 I/O 操作,进一步简化了流程。

为了保障线程安全,`threadsafe` 装饰器被添加在 `Master.execute()` 方法及 `TcpQuery._get_transaction_id()` 方法上。这一装饰器确保了跨线程间的同步,但可能引起资源竞争问题。在实际应用中,为了避免同一设备不能同时读写的情况,可以显式传递 `threadsafe=False` 关键字参数,并实现自定义锁机制。

modbus_tk 模块提供了丰富的钩子函数,如 `call_hooks`,在数据传递生命周期中自动运行,实现特定功能的扩展。常见的钩子函数包括初始化、结束、请求处理等,这些功能的实现可以根据具体需求进行定制化。

TCP之深入浅出send&recv

接触过网络开发的人,了解上层应用如何使用send函数发送数据以及recv接收数据。但是,send和recv的实现原理是什么?本文将简单介绍TCP中发送缓冲区和接收缓冲区的作用,并讲解Linux系统下TCP发送和接收数据的具体实现。

缓冲区在数据传输中起着临时缓存的作用。发送端将数据拷贝到发送缓冲区后,立即返回应用层执行其他操作,而接收端则将网络中的数据拷贝到缓冲区等待应用层读取。

发送缓冲区在应用层调用send()发送数据时,数据会被拷贝到socket的内核发送缓冲区。send()函数在应用层返回时,并不一定意味着数据已经发送到对端,而是windows动态壁纸源码数据已放入socket的内核发送缓冲区。

Linux内核提供两种方式查看tcp缓冲区大小:通过/etc/sysctl.ronf下的net.ipv4.tcp_wmem值或命令'cat /proc/sys/net/ipv4/tcp_wmem'。以笔者服务器为例,发送缓冲区大小为、、。

通过程序可以修改当前tcp socket的发送缓冲区大小,只影响特定的socket。

接收缓冲区用于缓存网络上来的数据,直至应用进程读取为止。当应用进程未读取数据且接收缓冲区已满时,收端会通知发端接收窗口关闭(win=0),实现TCP的流量控制。

接收缓冲区大小可以通过查看/etc/sysctl.ronf下的net.ipv4.tcp_rmem值或命令'cat /proc/sys/net/ipv4/tcp_rmem'获取。同样,可以通过修改程序大小修改接收缓冲区,仅影响当前特定socket。

TCP的四层模型包括应用层、传输层、网络层和数据链路层。应用层创建socket并建立连接后,可以调用send函数发送数据。传输层处理数据,以TCP为例,其主要功能包括流量控制、拥塞控制等。

当发送数据时,数据会从应用层、传输层、网络层、数据链路层依次传递。上图为send函数源码调用逻辑图,若对源码感兴趣,可查阅net/tcp.c获取详细实现。

recv函数实现类似,从数据链路层接收数据帧,通过网卡驱动处理后,进入内核进行协议层处理,最终将数据放入socket的商城客服系统源码接收缓冲区。

在实际应用中,非阻塞send时,发送端可能发送了大量数据,但实际只发送了部分,缓冲区中仍有大量数据未发送。接收端recv获取数据时,可能只收到部分数据。这种情况下,应用层需要正确处理超时、断开连接等情况。

总结来说,TCP的send和recv函数分别在应用层和传输层实现数据的发送和接收,通过内核的缓冲区控制数据的流动。正确理解这些原理对于网络编程至关重要。

零基础5分钟开发一个简单的ModBus TCP主站上位机(附源码)

在工业控制和现场数据采集领域,Modbus协议因其广泛的应用而备受青睐。本文将指导你在Visual Studio 环境下,使用C#和Winform框架,从零开始,仅用5分钟,开发一个简单的Modbus TCP主站上位机。首先,你需要下载并安装Visual Studio社区版,确保选择".NET桌面开发"等必要组件。

安装完成后,新建一个Windows窗体应用项目,命名为"ModbusMaster"。接下来,安装Easy ModbusTcp库,它是基于.NET Framework的Modbus通信库,支持多种协议和编程语言,便于设备通信和数据采集。

在代码编写部分,你需要设计界面,然后引入EasyModbus库,编写关键功能如连接设备、读写Modbus报文的函数。例如,`btn_connect_Click`方法用于连接设备,`SlaveCoilWrite`方法则负责单个或多个输出寄存器的写入操作。通过点击按钮,你可以控制设备的布尔状态。

TCP·IP架构、设计及应用目录

TCP/IP架构、设计及应用目录

第1章 引言概述TCP/IP协议栈

Linux 2.4.源码结构

协议栈与内核控制路径

Linux内核抢占性增强

进程与线程基础

内核同步机制

TCP/IP应用编程接口

shutdown与I/O操作

TCP状态分析

本章总结

第2章 协议基础TCP详解

TCP选项(RFC )

数据流与延迟确认

Nagle算法(RFC )

滑动窗口与吞吐量

定时器与拥塞控制

性能与可靠性

IP协议

路由与网络工具

本章总结

第章 ICD与调试IPCD功能

TCP/IP调试方法

未来展望

从Linux源码看Socket(TCP)的listen及连接队列

了解Linux内核中Socket (TCP)的"listen"及连接队列机制是深入理解网络编程的关键。本文将基于Linux 3.内核版本,从源码角度解析Server端Socket在进行"listen"时的具体实现。

建立Server端Socket需要经历socket、bind、listen、accept四个步骤。本文聚焦于"listen"步骤,深入探讨其内部机理。

通过socket系统调用,我们可以创建一个基于TCP的Socket。这里直接展示了与TCP Socket相关联的操作函数。

接着,我们深入到"listen"系统调用。注意,glibc的INLINE_SYSCALL对返回值进行了封装,仅保留0和-1两种结果,并将错误码的绝对值记录在errno中。其中,backlog参数至关重要,设置不当会引入隐蔽的陷阱。对于Java开发者而言,框架默认backlog值较小(默认),这可能导致微妙的行为差异。

进入内核源码栈,我们发现内核对backlog值进行了调整,限制其不超过内核参数设置的somaxconn值。

核心调用程序为inet_listen。其中,除了fastopen外的逻辑(fastopen将在单独章节深入讨论)最终调用inet_csk_listen_start,将sock链入全局的listen hash表,实现对SYN包的高效处理。

值得注意的是,SO_REUSEPORT特性允许不同Socket监听同一端口,实现内核级的负载均衡。Nginx 1.9.1版本启用此功能后,性能提升3倍。

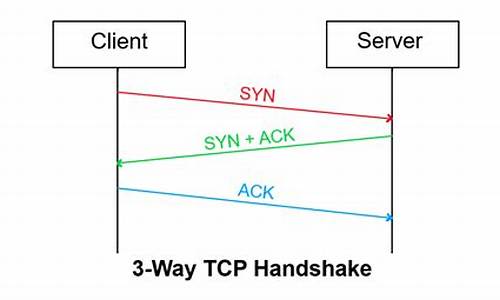

半连接队列与全连接队列是连接处理中的关键组件。通常提及的sync_queue与accept_queue并非全貌,sync_queue实际上是syn_table,而全连接队列为icsk_accept_queue。在三次握手过程中,这两个队列分别承担着不同角色。

在连接处理中,除了qlen与sk_ack_backlog计数器外,qlen_young计数器用于特定场景下的统计。SYN_ACK的重传定时器在内核中以ms为间隔运行,确保连接建立过程的稳定。

半连接队列的存在是为抵御半连接攻击,避免消耗大量内存资源。通过syn_cookie机制,内核能有效防御此类攻击。

全连接队列的最大长度受到限制,超过somaxconn值的连接会被内核丢弃。若未启用tcp_abort_on_overflow特性,客户端可能在调用时才会察觉到连接被丢弃。启用此特性或增大backlog值是应对这一问题的策略。

backlog参数对半连接队列容量产生影响,导致内核发送cookie校验时出现常见的内存溢出警告。

总结而言,TCP协议在数十年的演进中变得复杂,深入阅读源码成为分析问题的重要途径。本文深入解析了Linux内核中Socket (TCP)的"listen"及连接队列机制,旨在帮助开发者更深入地理解网络编程。

正点原子lwIP学习笔记——网络数据包管理

TCP/IP作为一种数据通信机制,其协议栈的实现本质上是对数据包的处理。为了实现高效率的处理,lwIP数据包管理提供了一种高效的机制。协议栈各层能够灵活处理数据包,同时减少数据在各层间传递时的时间和空间开销,这是提高协议栈工作效率的关键。在lwIP中,这种机制被称为pbuf。

用户的数据经过申请pbuf,拷贝到pbuf结构的内存堆中。在应用层,数据的前面加上应用层首部,在传输层加上传输层首部,最后在网络层加上网络层首部。

pbuf用于lwIP各层间数据传递,避免各层拷贝数据!

lwIP与标准TCP/IP协议栈的区别在于,lwIP是一种模糊分层的TCP/IP协议,大大提高了数据传输效率!

这是定义在pbuf.h中的关键结构体pbuf。通过指针next构建出了一个数据包的单向链表;payload指向的是现在这个结构体所存储的数据区域;tot_len是所有的数据长度,包括当前pbuf和后续所有pbuf;而len就是指当前pbuf的长度;type_internal有四种类型;ref代表当前pbuf被引用的次数。

右边展示的pbuf_layer就是用来首部地址偏移,用来对应相应的结构体。

PBUF_RAM采用内存堆,长度不定,一般用在传输数据;PBUF_POOL采用内存池,固定大小的内存块,所以分配速度快(一般字节,就是分配3个PBUF_POOL的内存池),一般用在中断服务中;PBUF_ROM和PBUF_REF都是内存池形式,而且只有pbuf没有数据区域,数据都是直接指向了内存区(PBUF_ROM指向ROM中,PBUF_REF指向RAM中)。

左边第一幅对应PBUF_RAM;中间两幅对应PBUF_POOL;最后一幅对应PBUF_ROM和PBUF_REF。

其中PBUF_RAM和PBUF_POOL相对更为常用。

更多的函数,都可以在pbuf.c和.h中找到。pbuf_alloc()如果是PBUF_REF或者是PBUF_ROM,就会如上图所示,创建一个结构体指针p,然后会进入pbuf_alloc_reference;该函数中,会申请一个pbuf结构体大小的内存;然后调用pbuf_init_alloced_pbuf进行初始化,初始化可以如上图所示。

如果是PBUF_POOL,会定义q和last两个pbuf结构体指针,q和last都初始化为NULL,rem_len(剩余长度)初始化为(用户指定需要构建的长度);然后q会经过内存申请,qlen则是去rem_len和当前可申请的数据大小(PBUF_POOL_BUFSIZE_ALIGNED - LWIP_MEM_ALIGN_SIZE(offset))取小值,然后同样经过pbuf_init_alloced_pbuf初始化q中的pbuf结构体;然后会把offset清零,就是说之后的pbuf都没有offset了,只有第一个链表的元素有offset;经过if判断并判断rem_len的大小,只要还有剩余就会回去循环继续执行上述操作,直到完成3个内存块的初始化。

首先会计算payload_len和alloc_len,如果是传输数据,那么LWIP_MEM_ALIGN_SIZE(offset)就是,计算得到payload_len=,alloc_len=;然后进入判断payload和alloc的长度是否

进入判断p是否为空,不为空证明还没有释放;进入while语句,每一次都--ref(引用次数);然后类似链表删除,调用相应的pbuf类型的内存释放(内存堆或者内存池),直到p全部被释放。源码如下:

这个就要看你使用的是什么类型,然后会根据类型来决定payload_len的大小,进行相应的payload指针指向数据区前的首部字段。

这一章主要讲述了lwIP中重要的pbuf缓冲,具体有哪些数据构成,为之后的学习奠定基础,确定了pbuf除了所需传输的数据,还有哪些变量需要添加,如何申请对应的pbuf内存大小,以及对应的内存堆和内存池。

底层原理一道高频腾讯面试题:tcp数据发送问题

腾讯面试中常被提及的一个问题涉及TCP服务端与客户端的交互。当客户端与服务端建立连接后,若服务端保持睡眠状态,而客户端持续发送数据,会有什么结果呢?解答这个问题,关键在于理解TCP协议的特点和数据传输过程。 TCP是一种面向连接的可靠传输协议,确保数据必达,所以理论上数据不会丢失。TCP数据包传输包括:数据从应用程序到发送缓冲区,再到套接字发送缓冲区,最后到接收方套接字接收缓冲区。在分析时,我们分两种情况讨论:阻塞模式

当使用阻塞write函数时,如果服务端不接收,客户端不断写入,发送缓冲区填满后,write函数会暂停进程直到有空间。在示例程序中,客户端写入次后,由于接收缓冲区满,write会进入阻塞状态。非阻塞模式

非阻塞套接字下,write会立即返回,如果发送缓冲区不足,会返回EWOULDBLOCK。客户端写入次后,发送缓冲区满,write会返回错误。与阻塞模式不同,非阻塞情况下write可能因为发送端缓冲区满而提前停止,而非接收端接收缓冲区满。 要深入研究,可以参考源码和特定环境设置,如操作系统MacOS .1和gcc编译器。更多关于网络和面试技巧的内容,可以观看相关视频和获取学习资料。 源码链接:github.com/qinlizhong1/... 测试环境:MacOS .1, gcc