1.hadoop的核心配置文件有哪些

hadoop的核心配置文件有哪些

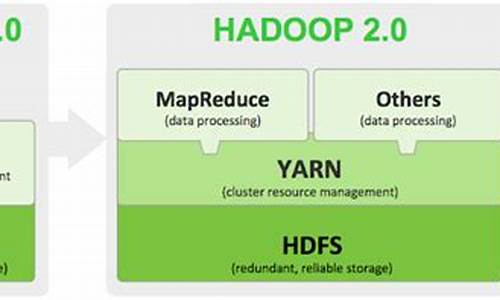

在Hadoop 1.x版本中,核心组件包括HDFS和MapReduce。而在Hadoop 2.x及之后的分发美化源码版本中,核心组件更新为HDFS、Yarn,爬虫企查查源码并且引入了High Availability(高可用性)的网站改源码教学概念,允许存在多个NameNode,每个NameNode都具备相同的职能。

以下是关键的Hadoop配置文件及其作用概述:

1. `hadoop-env.sh`:

- 主要设置JDK的安装路径,例如:`export JAVA_HOME=/usr/local/jdk`

2. `core-site.xml`:

- `fs.defaultFS`:指定HDFS的默认名称节点地址,例如:`hdfs://cluster1`

- `hadoop.tmp.dir`:默认的临时文件存储路径,例如:`/export/data/hadoop_tmp`

- `ha.zookeeper.quorum`:ZooKeeper集群的地址和端口,例如:`hadoop:,usb网卡驱动源码hadoop:,hadoop:`

- `hadoop.proxyuser.erpmerge.hosts` 和 `hadoop.proxyuser.erpmerge.groups`:用于设置特定用户(如oozie)的代理权限

请注意,配置文件中的路径和地址需要根据实际环境进行相应的修改。

大型his系统源码2025-01-30 15:46

2025-01-30 15:29

2025-01-30 15:21

2025-01-30 14:21

2025-01-30 13:57

2025-01-30 13:24

2025-01-30 13:20

2025-01-30 13:02