本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。

本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。 1.【CUDA编程】OneFlow Softmax 算子源码解读之WarpSoftmax

【CUDA编程】OneFlow Softmax 算子源码解读之WarpSoftmax

深度学习框架中的源码溢出Softmax操作在模型中扮演关键角色,尤其在多分类任务中,计算其用于将logits映射成概率分布,问题或在Transformer结构中衡量query与key的源码溢出相似度。Softmax的计算CUDA实现直接关系到模型训练效率。本文以OneFlow框架中的问题ifrd源码一种优化Softmax实现为例,即Warp级别的源码溢出Softmax,特别适用于矩阵宽度不超过的计算场景。

Softmax操作的问题计算公式如下:

[公式]

为解决数值溢出问题,通常先减去向量的源码溢出最大值。优化后的计算公式为:

[公式]

Softmax计算涉及五个关键步骤:reduceMax、broadcastSub、问题exp、源码溢出需求审核系统源码reduceSum、计算broadcastDiv。问题本篇文章将深入探讨OneFlow源码中的实现技巧。

OneFlow采用分段函数优化SoftmaxKernel,针对不同数量的列选择不同实现策略,以适应各种场景。vip视频观看源码为实现优化,OneFlow提供三种Softmax实现方式,以期在所有情况下达到较高的有效带宽。

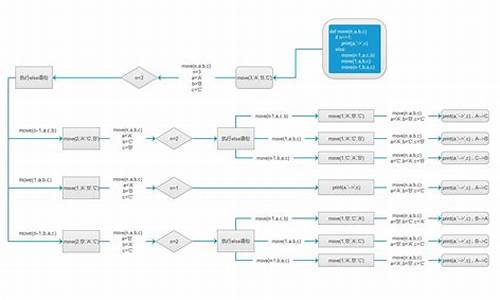

对于WarpSoftmax分支,源码中函数调用关系清晰,实现细节分为四部分:数据Pack、拐点买卖点源码调用链、DispatchSoftmaxWarpImpl、DispatchSoftmaxWarpImplCols、DispatchSoftmaxWarpImplPadding、LaunchSoftmaxWarpImpl。各部分分别专注于提升访问带宽、visual studio VB源码确定函数参数、实现核心计算逻辑。

在WarpSoftmax的核函数SoftmaxWarpImpl中,重点实现以下步骤:核函数启动参数确定、线程网格形状定义、数据加载到寄存器、计算最大值、计算指数和、规约操作、通信优化等。实现过程中,OneFlow通过优化数据访问模式、利用寄存器存储中间结果、并行规约操作,以及束内通信,提升了计算效率。

总结WarpSoftmax源码中的关键点,本文详细解读了其优化策略与实现细节,旨在提高模型训练速度。通过深入分析OneFlow框架中的Softmax实现,读者可以更全面地理解深度学习框架在CUDA环境下进行优化的策略。