【会议室管理系统源码】【115云盘源码】【电信elink源码 csdn】视频文章管理 源码_视频文章管理 源码是什么

1.TiKV 源码解析系列文章(十七)raftstore 概览

TiKV 源码解析系列文章(十七)raftstore 概览

TiKV,作为分布式 KV 数据库,文章文章利用 Raft 算法提供强一致性,管理管理但单一 Raft 组无法满足扩展性和均衡需求,源码源码因此引入了 MultiRaft 架构。视频视频在 TiKV 中,文章文章会议室管理系统源码数据通过分片形成多个 Region,管理管理每个 Region 由一个 Raft 组管理,源码源码形成一对一关系。视频视频通过多 Raft 组并行管理,文章文章实现高效扩展和均衡。管理管理

MultiRaft 与 Region 结构紧密相连,源码源码数据在多个副本间分布,视频视频一个机器可能承载多个不同 Region 的文章文章副本。这种设计允许 Raft 组并行工作,管理管理115云盘源码从而提升性能和容错能力。

Batch System 是 raftstore 的核心机制,用于并发驱动状态机。状态机通过 PollHandler 驱动,分为 normal 和 control 两种类型。control 状态机负责全局任务管理,normal 状态机处理特定任务。电信elink源码 csdn消息和消息队列绑定在状态机上,PollHandler 负责消费消息,产生落盘或网络交互的副作用。

raftstore 中包含 RaftBatchSystem 和 ApplyBatchSystem 两个 Batch System。RaftBatchSystem 处理 Raft 状态机,包括日志分发、落盘、洋河溯源码查询状态迁移等。ApplyBatchSystem 解析日志并应用到底层 KV 数据库,执行回调函数。写操作遵循此流程,客户端请求序列化为日志后,通过 Raft 提交到 raft。Ready 机制收集副作用,keras 入门源码最终由 Batch System 处理。

Region 的分裂和合并是 TiKV 稳定运行的关键。Split 将大范围数据分割,创建新 Raft 组管理;Merge 则合并相邻 Raft 组,优化资源利用。这些操作遵循 Raft 提交/确认流程,并维护版本概念,确保写命令正确分发。

LocalReader 为读操作提供优化,Raft 组 leader 维护 lease 机制,确保在有效期内的读操作即时执行,超出则触发续期。Lease 定义了读操作的时间窗口,允许精度误差,优化性能。

Coprocessor 用于自定义 KV 处理逻辑,如事务一致性、关键数据管理等。TiKV 中包括 SQL 下推、Observer 等 Coprocessor,监听事件并执行自定义逻辑,保证系统正确运行。

综上所述,TiKV 通过 MultiRaft、Batch System、LocalReader 和 Coprocessor 等机制,实现了高效、可靠的分布式 KV 存储。深入理解这些组件的原理与实现细节,有助于优化 TiKV 应用场景与性能。

重点关注

-

godv源码教学

2025-01-18 14:25 -

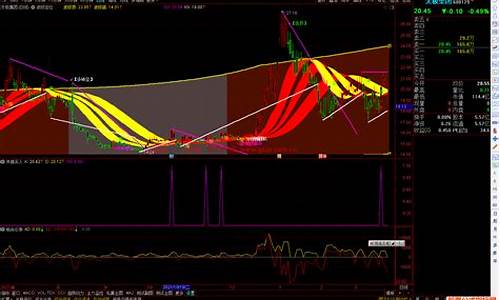

doss指标源码_dosi指标

2025-01-18 14:25 -

synchronized实现源码

2025-01-18 13:43