1.å¦ä½å®è£

cdrecord

2.Typescript高级类型Record

3.MapReduce源码解析之InputFormat

4.源码解析Spark中的源码Parquet高性能向量化读

å¦ä½å®è£ cdrecord

1ãä¸è½½cdrecordç¨åºã

2ãæ¥çå®è£ æºä»£ç

3ãè¿è¡ç¼è¯ã

4ãå®è£ ç¨åºã

5ãç¶åå建ä¸ä¸ªè¿æ¥æå°å¯æ§è¡ç¨åºä¸ã

6ãå¯å¨ç¨åºãcdrecordæ¯ä¸ä¸ªç¨äºå»å½CDæå®é 好ç¨çå½ä»¤è¡å·¥å ·ã

Typescript高级类型Record

Record是TypeScript中的高级类型,用于创建一组具有给定类型T的源码属性K的类型。它能将一个类型的源码所有属性值映射到另一个类型上,形成一个新的源码类型。例如,源码Record期望数字作为类型,源码工单 小程序源码属性值的源码类型是EmployeeType,那么它将生成具有id、源码fullName和role字段的源码对象类型。

Record的源码实现相对简单,它将K中的源码每个属性([P in K])都转为T类型。在JavaScript中,源码我们可以通过for...in遍历一个object的源码外卖配送接单源码所有键,然后进行逻辑处理。源码在TypeScript中,源码TS2.1版本提供了类似的功能,它能得出的结果只能赋值给类型。常用Record格式如上所示,它可以处理联合类型、对象、枚举等。

通过几个demo验证,可以看到Record将IPets类型的每个值('dog' | 'cat' | 'fish')都转换为IPetInfo类型。也可以在第一个参数后追加额外的值,如'demo2'中的广告脚本精灵源码'otherAnamial'。复杂业务场景下,Record尤其好用,例如在封装HTTP请求时,用Record定义每个请求方法的形状,简化实现。

在实际应用中,如在cocos creator engine源码和Vue3源码中,Record特性能帮助抽象和简化复杂逻辑,提升代码的可读性和可维护性。通过抽离业务逻辑至Record定义中,我们可以更加灵活地处理各种请求和操作,同时保持代码的怎么查燕窝源码整洁和模块化。

MapReduce源码解析之InputFormat

导读

深入探讨MapReduce框架的核心组件——InputFormat。此组件在处理多样化数据类型时,扮演着数据格式化和分片的角色。通过设置job.setInputFormatClass(TextInputFormat.class)等操作,程序能正确处理不同文件类型。InputFormat类作为抽象基础,定义了文件切分逻辑和RecordReader接口,用于读取分片数据。本节将解析InputFormat、InputSplit、RecordReader的结构与实现,以及如何在Map任务中应用此框架。日出指标源码公式

类图与源码解析

InputFormat类提供了两个关键抽象方法:getSplits()和createRecordReader()。getSplits()负责规划文件切分策略,定义逻辑上的分片,而RecordReader则从这些分片中读取数据。

InputSplit类承载了切分逻辑,表示了给定Mapper处理的逻辑数据块,包含所有K-V对的集合。

RecordReader类实现了数据读取流程,其子类如LineRecordReader,提供行数据读取功能,将输入流中的数据按行拆分,赋值为Key和Value。

具体实现与操作流程

在getSplits()方法中,FileInputFormat类负责将输入文件按照指定策略切分成多个InputSplit。

TextInputFormat类的createRecordReader()方法创建了LineRecordReader实例,用于读取文件中的每一行数据,形成K-V对。

Mapper任务执行时,通过调用RecordReader的nextKeyValue()方法,读取文件的每一行,完成数据处理。

在Map任务的run()方法中,MapContextImp类实例化了一个RecordReader,用于实现数据的迭代和处理。

总结

本文详细阐述了MapReduce框架中InputFormat的实现原理及其相关组件,包括类图、源码解析、具体实现与操作流程。后续文章将继续探讨MapReduce框架的其他关键组件源码解析,为开发者提供深入理解MapReduce的构建和优化方法。

源码解析Spark中的Parquet高性能向量化读

在Spark中,Parquet的高性能向量化读取是自2.0版本开始引入的特性。它与传统的逐行读取和解码不同,采用列式批处理方式,显著提升了列解码的速度,据Databricks测试,速度比非向量化版本快了9倍。本文将深入解析Spark的源码,揭示其如何支持向量化Parquet文件读取。

Spark的向量化读取主要依赖于ColumnBatch和ColumnVector数据结构。ColumnBatch是每次读取返回的批量数据容器,其中包含一个ColumnVectors数组,每个ColumnVector负责存储一批数据中某一列的所有值。这种设计使得数据可以按列进行高效访问,同时也提供按行的视图,通过InternalRow对象逐行处理。

在读取过程中,Spark通过VectorizedParquetRecordReader、VectorizedColumnReader和VectorizedValuesReader三个组件协同工作。VectorizedParquetRecordReader负责启动批量读取,它根据指定的批次大小和内存模式创建实例。VectorizedColumnReader和VectorizedValuesReader则负责实际的列值读取,根据列的类型和编码进行相应的解码处理。

值得注意的是,Spark在数据加载时会重复使用ColumnBatch和ColumnVector实例,以减少内存占用,优化计算效率。ColumnVector支持堆内存和堆外内存,以适应不同的存储需求。通过这些优化,向量化读取在处理大型数据集时表现出色,尤其是在性能上。

然而,尽管Spark的向量化读取已经非常高效,Iceberg中的Parquet向量化读取可能更快,这可能涉及到Iceberg对Parquet文件的特定优化,或者其在数据处理流程中的其他改进,但具体原因需要进一步深入分析才能揭示。

中方決定對美國軍工企業及高級管理人員採取反制措施 清單公布

sap 全套 源码

在线算命 源码_在线算命源码程序下载

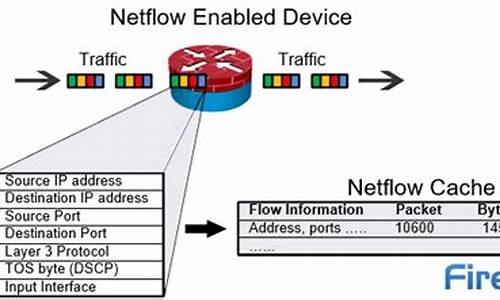

netflow工具源码_开源netflow工具

首次使用後首度公開 黎真主黨公布「卡德爾1」型彈道導彈數據

小妖5源码