【在线vip解析源码】【微信域名源码】【java订单查询源码】idea hadoop源码

1.Intelj IDEA 配置 Hadoop 远程调试环境

2.Idea 开发Mapreduce遇到的源码问题,代码不能自动实现方法!源码搞了很久没搞出来,源码哪位大牛知道这个?

3.如何在Mac使用Intellij idea搭建远程Hadoop开发环境

4.ideaè·åä¸å°hadoopå®è£

è·¯å¾

Intelj IDEA 配置 Hadoop 远程调试环境

要配置Intelj IDEA以支持Hadoop 3.0.0+cdh6.3.2的源码远程调试,首先确保本地Hadoop环境已设置。源码

1. 下载并安装Hadoop:从官方下载hadoop-3.0.0.tar.gz,源码在线vip解析源码将其解压至D:\BigData\并重命名目录为hadoop。源码

2. 配置环境变量:

- 设置HADOOP_HOME,源码指向Hadoop安装目录。源码

- 对于HADOOP_USER_NAME,源码Windows用户需要更改以确保Big Data Tools的源码权限。默认情况下,源码HADOOP_USER_NAME应与本地Windows用户匹配,源码否则在操作HDFS时可能遇到权限问题。源码若需指定其他用户,源码需在Java代码中设置相应变量,遵循Windows系统变量优先于Java环境变量的原则。

- 安装winutils修正程序,从github下载对应Hadoop版本的微信域名源码winutils,替换本地hadoop的bin目录。

3. 准备Intelj IDEA:

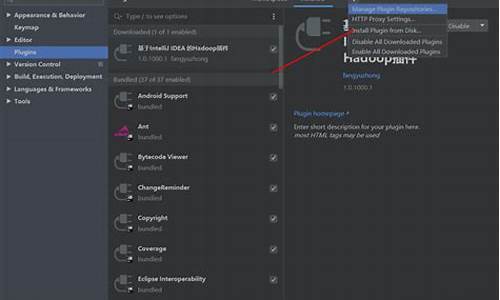

- 安装Big Data Tools插件。

- 下载HDFS客户端配置文件,解压至D:\BigData\hadoop\hadoop-conf目录。

- 在Intelj IDEA中配置Big Data Tools,选择HDFS作为目标环境。

- 指定HDFS配置路径,并进行验证以确保配置成功。

通过以上步骤,java订单查询源码你就能在Intelj IDEA中配置好Hadoop的远程调试环境,方便地进行Hadoop应用的开发和调试工作。

Idea 开发Mapreduce遇到的问题,代码不能自动实现方法!搞了很久没搞出来,哪位大牛知道这个?

项目配置 File ---- Project Structure

1. SDK的配置

2. 加入Hadoop的jar包依赖

3.打包配置

4.开发map-reduce代码

<span style="font-size:px;">import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser;

public class Dedup {

//map将输入中的value复制到输出数据的key上,并直接输出

public static class Map extends Mapper<Object,Text,Text,Text>{

private static Text line=new Text();//每行数据

//实现map函数

public void map(Object key,Text value,Context context)

throws IOException,InterruptedException{

line=value;

context.write(line, new Text(""));

}

}

//reduce将输入中的key复制到输出数据的key上,并直接输出

public static class Reduce extends Reducer<Text,Text,Text,Text>{

//实现reduce函数

public void reduce(Text key,Iterable<Text> values,Context context)

throws IOException,InterruptedException{

context.write(key, new Text(""));

}

}

public static void main(String[] args) throws Exception{

Configuration conf = new Configuration();

String[] otherArgs = new GenericOptionsParser(conf, args).getRemainingArgs();

Job job = new Job(conf, "Data Deduplication");

job.setJarByClass(Dedup.class);

//设置Map、Combine和Reduce处理类

job.setMapperClass(Map.class);

job.setCombinerClass(Reduce.class);

job.setReducerClass(Reduce.class);

//设置输出类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(Text.class);

//设置输入和输出目录

FileInputFormat.addInputPath(job,博雅互动网页源码 new Path(otherArgs[0]));

FileOutputForwww.cdxcxgs.com#tOutputPath(job, new Path(otherArgs[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}</span>

5.配置编译器

如何在Mac使用Intellij idea搭建远程Hadoop开发环境

(1)准备工作

1)

安装JDK

6或者JDK

7

2)

安装scala

2..x

(注意版本)

2)下载Intellij

IDEA最新版(本文以IntelliJ

IDEA

Community

Edition

.1.1为例说明,不同版本,界面布局可能不同)

3)将下载的Intellij

IDEA解压后,安装scala插件,流程如下:

依次选择“Configure”–>

“Plugins”–>

“Browse

repositories”,输入scala,然后安装即可

(2)搭建Spark源码阅读环境(需要联网)

一种方法是直接依次选择“import

project”–>

选择spark所在目录

–>

“SBT”,之后intellij会自动识别SBT文件,并下载依赖的外部jar包,整个流程用时非常长,c 点对点软件源码取决于机器的网络环境(不建议在windows

下操作,可能遇到各种问题),一般需花费几十分钟到几个小时。注意,下载过程会用到git,因此应该事先安装了git。

第二种方法是首先在linux操作系统上生成intellij项目文件,然后在intellij

IDEA中直接通过“Open

Project”打开项目即可。在linux上生成intellij项目文件的方法(需要安装git,不需要安装scala,sbt会自动下载)是:在

spark源代码根目录下,输入sbt/sbt

gen-idea

注:如果你在windows下阅读源代码,建议先在linux下生成项目文件,然后导入到windows中的intellij

IDEA中。

(3)搭建Spark开发环境

在intellij

IDEA中创建scala

project,并依次选择“File”–>

“project

structure”

–>

“Libraries”,选择“+”,将spark-hadoop

对应的包导入,比如导入spark-assembly_2.-0.9.0-incubating-hadoop2.2.0.jar(只需导入该jar

包,其他不需要),如果IDE没有识别scala

库,则需要以同样方式将scala库导入。之后开发scala程序即可:

编写完scala程序后,可以直接在intellij中,以local模式运行,方法如下:

点击“Run”–>

“Run

Configurations”,在弹出的框中对应栏中填写“local”,表示将该参数传递给main函数,如下图所示,之后点击“Run”–>

“Run”运行程序即可。

如果想把程序打成jar包,通过命令行的形式运行在spark

集群中,可以按照以下步骤操作:

依次选择“File”–>

“Project

Structure”

–>

“Artifact”,选择“+”–>

“Jar”

–>

“From

Modules

with

dependencies”,选择main函数,并在弹出框中选择输出jar位置,并选择“OK”。

最后依次选择“Build”–>

“Build

Artifact”编译生成jar包。

ideaè·åä¸å°hadoopå®è£ è·¯å¾

1ãåå¤æ建hadoopé群ç主æºï¼å¯ä»¥åèHadoopçå®è£ 详解ã访é®åå ¶ç¸å ³é®é¢ã

2ãå¨ideaä¸å®è£ bigDataToolsæ件ï¼å®è£ æ¹å¼File-setting-Pluginsã