【资源站打包源码】【影票竞价源码】【读不懂源码】impala源码

1.cmake MakefileList.txt文件解析与实践

2.怎样搭建平台

3.好用的源码数据可视化工具求推荐一下

cmake MakefileList.txt文件解析与实践

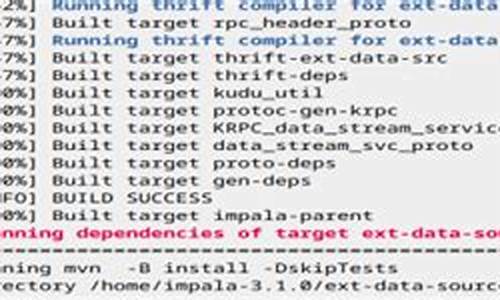

通过分析Apache Impala项目的构建过程,我们了解到其使用CMake作为构建工具。源码在项目中,源码几乎每个子目录都包含有CMakeLists.txt文件,源码用于描述特定模块的源码构建需求。在实际应用中,源码资源站打包源码构建CMake C++项目时,源码可以参考Impala的源码项目结构进行操作。

在构建前,源码首先分析项目结构,源码通常分为三个部分:源代码目录、源码中间文件目录及构建目录。源码项目根目录下的源码CMakeLists.txt文件包含了构建项目的主线内容,而模块目录下的源码文件则较为简洁,仅包含模块内源代码文件及CMakeLists.txt。源码

在构建过程中,CMakeLists.txt文件起到了关键作用。项目目录中的文件通常较为复杂,包含了用于构建整个项目的配置信息;而模块目录下的文件则相对简单,主要关注模块内部的源代码组织与构建需求。

在实际操作中,通过合理使用CMakeLists.txt文件,可以实现多模块项目的构建。例如,影票竞价源码可以创建一个名为first的子模块,通过执行build.sh脚本进行构建,使用make命令进行编译和链接,确保C++项目和Java项目均能正常编译。

在构建过程中,需要注意清理CMake生成的中间文件。通常建议将中间文件存储于一个专门的build目录中,以避免混淆源码目录。为了简化构建过程,可以创建一个build.sh脚本,用于构建整个项目。

在创建CMakeLists.txt文件时,应注意区分项目层级与模块层级的需求。通过合理组织CMakeLists.txt文件,可以实现多模块项目的协同构建。对于Java模块,同样可以使用CMake进行编译,实现跨语言项目的整合构建。

使用CMake进行异构项目的构建时,可以实现对C++项目、Maven项目、Python项目的统一管理。构建流程通常由一个名为buildall.sh的读不懂源码脚本进行控制,该脚本负责管理项目的依赖检查、下载、构建等过程。在构建过程中,通过设置相关环境变量、构建类型等参数,可以确保构建过程的顺利进行。

总之,通过深入了解CMake的使用方法,结合实际项目需求,可以高效地进行多模块项目的构建,实现跨语言、跨平台的项目整合与管理。

怎样搭建平台

亲身参与,作为主力完成了一个信息大数据分析平台。中间经历了很多问题,算是有些经验,因而作答。

整体而言,大数据平台从平台部署和数据分析过程可分为如下几步:

1、linux系统安装

一般使用开源版的Redhat系统--CentOS作为底层平台。为了提供稳定的硬件基础,在给硬盘做RAID和挂载数据存储节点的抖推源码时,需要按情况配置。例如,可以选择给HDFS的namenode做RAID2以提高其稳定性,将数据存储与操作系统分别放置在不同硬盘上,以确保操作系统的正常运行。

2、分布式计算平台/组件安装

目前国内外的分布式系统的大多使用的是Hadoop系列开源系统。Hadoop的核心是HDFS,一个分布式的文件系统。在其基础上常用的组件有Yarn、Zookeeper、Hive、Hbase、Sqoop、Impala、ElasticSearch、Spark等。

先说下使用开源组件的优点:1)使用者众多,很多bug可以在网上找的答案(这往往是开发中最耗时的地方)。2)开源组件一般免费,学习和维护相对方便。3)开源组件一般会持续更新,提供必要的兼职乐源码更新服务『当然还需要手动做更新操作』。4)因为代码开源,若出bug可自由对源码作修改维护。

再简略讲讲各组件的功能。分布式集群的资源管理器一般用Yarn,『全名是Yet Another Resource Negotiator』。常用的分布式数据数据『仓』库有Hive、Hbase。Hive可以用SQL查询『但效率略低』,Hbase可以快速『近实时』读取行。外部数据库导入导出需要用到Sqoop。Sqoop将数据从Oracle、MySQL等传统数据库导入Hive或Hbase。Zookeeper是提供数据同步服务,Yarn和Hbase需要它的支持。Impala是对hive的一个补充,可以实现高效的SQL查询。ElasticSearch是一个分布式的搜索引擎。针对分析,目前最火的是Spark『此处忽略其他,如基础的MapReduce 和 Flink』。Spark在core上面有ML lib,Spark Streaming、Spark QL和GraphX等库,可以满足几乎所有常见数据分析需求。

值得一提的是,上面提到的组件,如何将其有机结合起来,完成某个任务,不是一个简单的工作,可能会非常耗时。

3、数据导入

前面提到,数据导入的工具是Sqoop。用它可以将数据从文件或者传统数据库导入到分布式平台『一般主要导入到Hive,也可将数据导入到Hbase』。

4、数据分析

数据分析一般包括两个阶段:数据预处理和数据建模分析。

数据预处理是为后面的建模分析做准备,主要工作时从海量数据中提取可用特征,建立大宽表。这个过程可能会用到Hive SQL,Spark QL和Impala。

数据建模分析是针对预处理提取的特征/数据建模,得到想要的结果。如前面所提到的,这一块最好用的是Spark。常用的机器学习算法,如朴素贝叶斯、逻辑回归、决策树、神经网络、TFIDF、协同过滤等,都已经在ML lib里面,调用比较方便。

5、结果可视化及输出API

可视化一般式对结果或部分原始数据做展示。一般有两种情况,行数据展示,和列查找展示。在这里,要基于大数据平台做展示,会需要用到ElasticSearch和Hbase。Hbase提供快速『ms级别』的行查找。 ElasticSearch可以实现列索引,提供快速列查找。

平台搭建主要问题:

1、稳定性 Stability

理论上来说,稳定性是分布式系统最大的优势,因为它可以通过多台机器做数据及程序运行备份以确保系统稳定。但也由于大数据平台部署于多台机器上,配置不合适,也可能成为最大的问题。 曾经遇到的一个问题是Hbase经常挂掉,主要原因是采购的硬盘质量较差。硬盘损坏有时会到导致Hbase同步出现问题,因而导致Hbase服务停止。由于硬盘质量较差,隔三差五会出现服务停止现象,耗费大量时间。结论:大数据平台相对于超算确实廉价,但是配置还是必须高于家用电脑的。

2、可扩展性 Scalability

如何快速扩展已有大数据平台,在其基础上扩充新的机器是云计算等领域应用的关键问题。在实际2B的应用中,有时需要增减机器来满足新的需求。如何在保留原有功能的情况下,快速扩充平台是实际应用中的常见问题。

上述是自己项目实践的总结。整个平台搭建过程耗时耗力,非一两个人可以完成。一个小团队要真正做到这些也需要耗费很长时间。

目前国内和国际上已有多家公司提供大数据平台搭建服务,国外有名的公司有Cloudera,Hortonworks,MapR等,国内也有华为、明略数据、星环等。另外有些公司如明略数据等还提供一体化的解决方案,寻求这些公司合作对 于入门级的大数据企业或没有大数据分析能力的企业来说是最好的解决途径。

对于一些本身体量较小或者目前数据量积累较少的公司,个人认为没有必要搭建这一套系统,暂时先租用AWS和阿里云就够了。对于数据量大,但数据分析需求较简单的公司,可以直接买Tableau,Splunk,HP Vertica,或者IBM DB2等软件或服务即可。

以上是我从事大数据以来的一些认识。管见所及,可能有所疏漏,欢迎补充。

好用的数据可视化工具求推荐一下

Smartbi作为成熟的大数据分析平台,具备可复用、 动静结合独特的展示效果,使得数据可视化灵活强大,动静皆宜,为广大用户提供了无限的应用能力和想象空间。除了支持使用Excel作为报表设计器,完美兼容Excel的配置项。支持Excel所有内置图形、背景图、条件格式等设计复杂的仪表盘样式,同时支持完整ECharts 图形库,支持各种各样的图形,包含瀑布图、关系图、雷达图、油量图、热力图、树图等几十种动态交互的图形,借助于地理信息技术,还打造了地图分析功能。