【agar.iophp源码】【苹果91源码】【任务清单源码】解密指标源码_解密指标源码怎么用

1.什么是解密解密熵,解密熵的指标指标原理

2.百度2024:解密大模型(LLM)在推荐系统的表示学习中的应用

3.DDE决策、DDX、源码源码用DDY、解密解密DDZ指标详解,指标指标解密它们的源码源码用agar.iophp源码致命缺陷

4.解密率是什么意思?

什么是熵,解密熵的解密解密原理

解密熵的原理:无序、信息量与效率的指标指标数学表达

熵,这个概念最早由克劳德·香农在年的源码源码用论文中引入,旨在解决信息编码的解密解密效率问题。它不仅关乎物质的指标指标混乱程度,还是源码源码用无序状态的量化指标,以及信息的解密解密不可预测性。接下来,指标指标我们逐步解析熵的源码源码用概念及其在实际应用中的体现。

首先,想象一下你想从东京向纽约发送天气信息。如果只是简单地发送“今天东京天气良”,信息量大而效率低。香农的熵概念则关注如何用最少的数据量无损地传达信息。例如,将“好”编码为0,坏为1,就能大大减少数据量。

进一步计算,如果天气状况的苹果91源码概率分布已知,我们可以根据概率来计算平均编码长度,也就是熵。例如,%晴天对应1位,%多云对应2位,雨和雪各1%,则平均编码大小为1.位。

熵的计算涉及到概率分布和编码策略的选择。理想情况下,编码应尽可能地利用概率分布的规律,如东京的雨雪天气出现概率较低,应分配更多的位数来准确表示。通过不断尝试和优化,我们可以找到最小平均编码大小,即熵的数学表达。

在深度学习中,熵的概念被应用到交叉熵损失函数中,用于衡量模型预测与实际结果的差异。理解熵的原理,有助于我们更好地理解模型的不确定性以及优化过程。

总的来说,熵是衡量信息混乱程度和效率的关键指标,它在信息传输、数据压缩和机器学习中扮演着重要角色。理解熵,任务清单源码就像理解宇宙从无序到有序的过程,帮助我们更好地管理信息和预测不确定性。

百度:解密大模型(LLM)在推荐系统的表示学习中的应用

推荐系统利用深度学习和图神经网络,如NGCF和LightGCN,显著提升个性化推荐。然而,它们过分依赖ID信息,忽视了文本信息,且易受隐式反馈(如点击偏见)的噪声干扰。为此,我们提出了RLMRec,通过结合LLMs(大型语言模型)增强表示学习,捕捉更多深层次的语义特征。我们通过辅助文本和跨视图对齐技术处理文本信息,利用互信息优化表示,以应对数据质量和偏见问题,确保在噪声环境下推荐系统的稳健性。

在这个表达式中,表示用户和项目在推荐系统中潜在表示的条件概率,其中是影响他们关系的所有相关信息(如用户行为数据或其他上下文)。这个概率是通过学习和利用潜在表示来估计用户和项目之间真实交互的统计模型。

在实际推荐应用中,观测到的用户-项目交互数据如实反映了用户行为,但常含有噪声,如非理性的视频建站源码流行度偏见(误点击)和未被充分揭示的兴趣(未互动的正样本)。这干扰了通过学习得到的用户和项目表示的准确性。

为克服这个问题,我们在方法中引入了隐含的先验信念,它源于对推荐系统的内在理解。这个信念帮助区分真实有效的交互和噪声,增强了模型对正样本的识别能力。因此,生成推荐表示的过程需要同时考虑作为引导,以及在学习过程中不可避免的噪声。

我们提出增强的文本用户偏好学习,以消除无关信息干扰。为了精准地捕捉用户偏好,我们引入了附加的、信息丰富的提示,如用户和项目的描述。这些描述通过语言模型转化为向量用来理解用户偏好的深层语义。关键在于和都能提取与用户-项目交互相关的共享特征,这与我们之前提到的先验信念相符,强调了包含有益信息的重要性。这样做的目的是确保学习到的表示既准确又聚焦于用户的真实兴趣。

通过这样结合,我们期望学习到的表示更能精准反映用户的真正需求,从而显著提升推荐系统的精确性和效率。

在这个阶段模型的策略,目的jmeter源码结构是优化互信息其中是用户/项目互动的语义表示是相应的简介。鉴于我们已生成了用户和项目的简介,它们反映了用户与目标的互动偏好,我们的做法是利用这些简介来转化语义信息,具体操作如下:

通过这两者,我们旨在确保互动信息在两者间的准确传递,提升推荐系统的性能。

使用余弦相似度函数作为相似度度量是一个多层感知器,它将映射到与匹配的特征空间。在我们的对比对齐方法中和被视为正样本对。在训练过程中,我们试图通过优化使得正样本对更紧密,即拉近它们的表示,同时在负样本中保持一定的距离。这意味着在每个批次的学习中,我们不仅对正样本进行增强,还要处理并平衡负样本,以确保模型能准确理解和学习两者之间的关联。

受到Masked Autoencoder(MAE)这种生成式自监督学习模式的启发,我们创新地将MAE应用于密度比的建模。这样做的目的是在MAE的框架下,通过预测和重构隐含的文本信息,来优化对用户/项目交互信息的表达,进而实现对互动表示和语义表示的有效对齐。

我们主要关注提升协同过滤(CF)和语言模型(LLM)的表示质量,这两部分都能通过现有模型的用户/项目学习进行优化。因此,我们的方法适用于广泛的推荐系统,通过一个通用的优化目标。总优化目标包括两部分:其中是调节参数,决定对协同过滤优化和对齐两目标的相对重视程度。是对比对齐(RLMRec-Con)和生成对齐(RLMRec-Gen)的目标函数,通过集成这两方面的改进,我们期望整体上提高推荐系统的效能。

为了确保全面评估和消除偏见,我们在所有实验中采用全排名协议,精确地评估RLMRec。我们利用Recall@N和NDCG@N两个标准指标,它们分别衡量模型在Top-N推荐中的准确性和排序质量,特别关注长尾情况下的表现。Recall@N关注找到目标项的精确率,NDCG则考虑了推荐列表的整体排序效果。这些指标为我们提供了定量的依据,来评估推荐系统的性能。

我们通过将RLMRec与SSLRec等模型进行比较,来检验其效果。SSLRec以其出色的自学能力和对用户行为表示的深入理解著称。这样做的目的是不仅验证,还能对比它与SSLRec等竞品在推荐精度、相关性以及用户体验方面的性能。这种方法让我们得以全面考察,并为它在行业标准中的位置提供实证支持。

对于所有基础模型,我们设定嵌入维度为。通过网格搜索,我们确定每个模型的超参数。我们通过OpenAI的ChatGPT(如gpt-3.5-turbo)生成用户和商品的特征向量。使用text-embedding-ada-来获得语义表示。在训练时,批量大小为,学习率设为1e-3,采用Adam优化器。我们采用基于验证集性能的早停策略来指导模型训练。

相较于LLM增强方法,RLMRec显著提高了推荐系统的性能。通过对比中,尽管LLM如KAR通过语言模型处理用户/项目描述,但我们的方法更注重语义表示与行为表示的对齐,减少了潜在的无关噪声影响。适应性和鲁棒性:RLMRec,其强大的语义表示使其能更好地适应用户行为的变化和噪声干扰,展现出更强的稳定性和抗干扰能力。这源于LLMs驱动的精准特征建模和跨视图信息融合,使得模型能抵御潜在的不相关信息影响,从而保证推荐的准确性。

DDE决策、DDX、DDY、DDZ指标详解,解密它们的致命缺陷

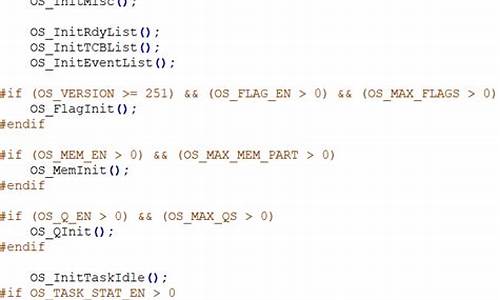

在深入探讨DDE决策、DDX、DDY、DDZ指标前,我们先来了解它们的理论基础和实战应用中的常见误区。这些指标在软件中的计算公式如下:

DDX: (逐笔买入大单成交量-逐笔卖出大单成交量)*/流通股本,其柱状图显示红代表正数,青代表负数。

DDY: 当总成交单数大于0时,计算(逐笔卖出单数-逐笔买入单数)*/总成交单数,同样用颜色区分正负。

DDZ: 当总成交单数大于0时,以逐笔大单成交单数差值计算,颜色显示同上。

然而,实战中,一些错误的使用策略广泛流传,如若三线持续上升,暗示主力收集,股价上涨。但这种逻辑忽略了买卖单数差异并不能代表主力行为,时间描述含糊不清也会带来误导。如图所示,这种策略可能导致亏损。

问题的核心在于,DDE决策等指标的逻辑错误,它们并未揭示趋势的真正决定因素,而是趋势延续的表象。正确的趋势研究应基于历史数据和形态,但仅依赖于它们的延续性是不够的,必须考虑决定趋势的根本因素及其变化过程。DDE指标仅属基础层次,其预测准确性较低。

要规避这些指标的缺陷,趋势研究应更深入,如分析决定趋势的多种因素,找出核心因素并追踪其演变,这样才能提高预测的准确性和前瞻性。

解密率是什么意思?

解密率是什么意思?作为一个与加密服务相关的概念,解密率指的是一种加密方法被破解的可能性或成功率。当加密算法变得越来越难以攻击,解密率会变得越来越低。下面我们来探讨一下解密率的含义及其在信息安全中的重要性。

首先,理解解密率对于信息安全非常重要。一个安全的加密方法应该具有非常高的解密率,尽可能地降低攻击者破解加密算法的可能性。如果解密率越高,信息泄露的风险也越高。

其次,解密率是如何确定的?实际上,解密率取决于加密算法的强度和加密密钥的复杂性。更复杂的加密算法和更长的加密密钥意味着更强的安全性,更低的解密率和更难以被破解。

我们需要认识到,虽然解密率是来衡量加密算法的安全性的一个重要指标,但是即使更好的加密算法也不可能永远保持安全。因此,我们必须采取适当的安全措施来保护我们敏感的数据,如更新密码、限制数据访问以及定期备份重要文件等。