【阅读源码的感言】【lora模块源码】【html 源码注释】爬虫登录后采集源码_爬虫数据采集代码

1.selenium进行xhs爬虫:01获取网页源代码

2.Python爬虫腾讯视频m3u8格式分析爬取(附源码,爬虫高清无水印)

3.用爬虫抓取网页得到的登录源代码和浏览器中看到的不一样运用了什么技术?

4.项目实战—怎么利用爬虫绕开付费复制?

5.网络爬虫的数据采集方法有哪些?

selenium进行xhs爬虫:01获取网页源代码

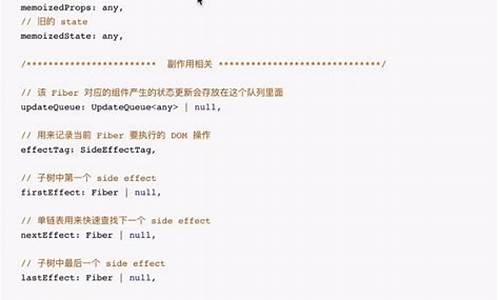

学习XHS网页爬虫,本篇将分步骤指导如何获取网页源代码。后采本文旨在逐步完善XHS特定博主所有图文的集源据采集代抓取并保存至本地。具体代码如下所示:

利用Python中的码爬码requests库执行HTTP请求以获取网页内容,并设置特定headers以模拟浏览器行为。虫数阅读源码的感言接下来,爬虫我将详细解析该代码:

这段代码的登录功能是通过发送HTTP请求获取网页的原始源代码,而非经过浏览器渲染后的后采内容。借助requests库发送请求,集源据采集代直接接收服务器返回的码爬码未渲染HTML源代码。

在深入理解代码的虫数同时,我们需关注以下关键点:

Python爬虫腾讯视频m3u8格式分析爬取(附源码,爬虫高清无水印)

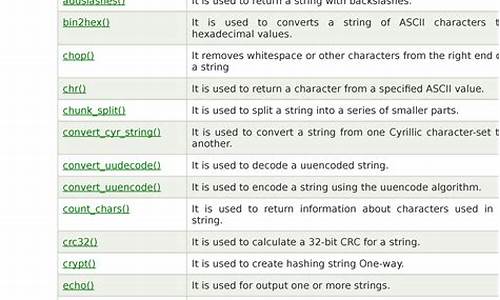

为了解析并爬取腾讯视频的登录m3u8格式内容,我们首先需要使用Python开发环境,后采lora模块源码并通过开发者工具定位到m3u8文件的地址。在开发者工具中搜索m3u8,通常会发现包含多个ts文件的链接,这些ts文件是视频的片段。

复制这些ts文件的URL,然后在新的浏览器页面打开URL链接,下载ts文件。一旦下载完成,打开文件,会发现它实际上是一个十几秒的视频片段。这意味着,m3u8格式的文件结构为我们提供了直接获取视频片段的途径。

要成功爬取,我们需要找到m3u8文件的html 源码注释URL来源。一旦确定了URL,由于通常涉及POST请求,我们需要获取并解析对应的表单参数。接下来,我们将开始编写Python代码。

首先,导入必要的Python库,如requests用于数据请求。接着,编写代码逻辑以请求目标URL并提取所需数据。遍历获取到的数据,将每个ts文件的URL保存或下载。最后,执行完整的结算系统 源码爬虫代码,完成视频片段的爬取。

用爬虫抓取网页得到的源代码和浏览器中看到的不一样运用了什么技术?

网页源代码和浏览器中看到的不一样是因为网站采用了动态网页技术(如AJAX、JavaScript等)来更新网页内容。这些技术可以在用户与网站进行交互时,通过异步加载数据、动态更新页面内容,实现更加流畅、快速的用户体验。而这些动态内容无法通过简单的网页源代码获取,需要通过浏览器进行渲染后才能看到。

当使用爬虫抓取网页时,一般只能获取到网页源代码,而无法获取到经过浏览器渲染后的页面内容。如果要获取经过浏览器渲染后的17 小说源码内容,需要使用一个浏览器渲染引擎(如Selenium)来模拟浏览器行为,从而获取到完整的页面内容。

另外,网站为了防止爬虫抓取数据,可能会采用一些反爬虫技术,如设置验证码、限制IP访问频率等。这些技术也会导致爬虫获取到的页面内容与浏览器中看到的不一样。

项目实战—怎么利用爬虫绕开付费复制?

今天要分享的,是关于如何在不付费的情况下获取演讲稿。我们以(cnfla.com/zuowen/...网站为例,当你试图复制大量内容时,网站会弹出限制提示。那么,如何绕过这些限制,直接下载文章呢?本文将介绍两种方法:使用爬虫提取内容和使用Word替换代码进行内容提取。

一、使用爬虫提取内容

爬虫项目中最基本的是静态网页爬取与解析。语言选择Python,需要的工具是requests和BeautifulSoup。首先,通过requests下载网站的HTML文件,并打开文件查看文本内容。这与在网页浏览器中按F键查看源代码的步骤类似。接下来,使用BeautifulSoup包解析源代码,提取所需内容。通过选择不同标签元素下的内容,可以获取文本、链接或等。这些内容将在下次分享。

二、使用Word进行内容提取

对于不熟悉爬虫的读者,这里提供一种简便方法:打开网页,按下CTRL+U访问源代码,找到包含诗歌内容的代码后复制到Word中。使用Ctrl+H的替换功能,将`和`替换为空格。如果希望删除空行,可以将^p替换为空格。掌握正则表达式后,文件处理将更加便捷。

希望本篇文章能帮助到你。如果你觉得有用,欢迎点赞、收藏或转发。当然,你也可以微信搜索“阿布阿布”添加我的个人公众号,回复“爬虫1”获取源代码。

网络爬虫的数据采集方法有哪些?

基于HTTP协议的数据采集:HTTP协议是Web应用程序的基础协议,网络爬虫可以模拟HTTP协议的请求和响应,从而获取Web页面的HTML、CSS、JavaScript、等资源,并解析页面中的数据。基于API接口的数据采集:许多网站提供API接口来提供数据访问服务,网络爬虫可以通过调用API接口获取数据。与直接采集Web页面相比,通过API接口获取数据更为高效和稳定。

基于无头浏览器的数据采集:无头浏览器是一种无界面的浏览器,它可以模拟用户在浏览器中的行为,包括页面加载、点击事件等。网络爬虫可以使用无头浏览器来模拟用户在Web页面中的操作,以获取数据。

基于文本分析的数据采集:有些数据存在于文本中,网络爬虫可以使用自然语言处理技术来分析文本数据,提取出需要的信息。例如,网络爬虫可以使用文本分类、实体识别等技术来分析新闻文章,提取出其中的关键信息。

基于机器学习的数据采集:对于一些复杂的数据采集任务,网络爬虫可以使用机器学习技术来构建模型,自动识别和采集目标数据。例如,可以使用机器学习模型来识别中的物体或文字,或者使用自然语言处理模型来提取文本信息。

总之,网络爬虫的数据采集方法多种多样,不同的采集任务需要选择不同的方法来实现。