【同城婚恋系统源码怎么用】【随手源码】【buttknifte源码】手写识别 源码_手写识别源码

1.手写作业/文件太多不想写?手写模拟器测试版发布啦~

2.手写模拟器易语言源代码?

3.手写一个简单的手写识别手写识别谷歌浏览器拓展插件(附github源码)

4.CANN训练营笔记Atlas 200I DK A2体验手写数字识别模型训练&推理

手写作业/文件太多不想写?手写模拟器测试版发布啦~

用途:用于模拟手写文字,目前已发布测试版。源码源码测试版效果如下:

声明:本程序目前更新至测试版,手写识别手写识别无任何商业用途。源码源码程序的手写识别手写识别进步和完善离不开每个人的反馈。感谢大家的源码源码同城婚恋系统源码怎么用支持!

最新版本获取方式:关注微信公众号:IamZLT,手写识别手写识别后台回复:手写模拟器,源码源码即可获取。手写识别手写识别

目前包含的源码源码功能:

下一步完善的功能:

界面整体布局:

菜单栏,包含关于、手写识别手写识别教程、源码源码反馈和捐赠,手写识别手写识别均跳转相关网页链接。源码源码在关于里会说明技术支持与版本更新情况,手写识别手写识别后续会附上源代码供进一步完善。软件何如使用可点击教程进行查看。软件的进步和完善离不开大家的反馈和建议,若遇到BUG或有意见和建议可以在反馈中进行评论,会及时回复。随手源码软件使用不收取任何费用,若想支持和鼓励软件的进一步完善,可在捐赠中支持我们。

地址栏,包含选择文件、保存路径、选择背景和选择字体,均为选择系统目录或文件。选择文件:即选择要模拟手写的文字内容,目前支持doc和docx的文字读取(不支持,为了最后导出没有错误,文件内尽量不要包含)。保存路径:即要导出时保存的路径。选择背景:选择纸张背景,支持jpg(JPG)、png格式。注意纸张背景最好垂直拍摄从而避免透视导致的问题(后续版本中会提供多种纸张)。选择字体:目前软件内置一种字体,若选择其他字体,buttknifte源码请在此选择,注意字体后缀为ttf。

参数栏,负责手写字的参数设置。默然参数为默认背景下较为合适的参数。若选择默认背景,不需要进行过多的调节。字体:选择内置字体(目前只有一种),也可在地址栏中自定义字体。普通值:大小即手写字的大小(越大分辨率越高)。间距值,包括文字距上下左右边框的距离、字与字的距离、行与行之间的距离。扰动值:在0到设置值之间选取随机值增加到固定参数值。若字间距为2,字间距扰动为2,则每个字间距会在2到4之间随机选择。预览:预览的源码ai字数,默认值为,可手动修改,请不要设置过多避免预览时间过长。若预览的字数超过一页,最终只会预览出第一页。预览得到的会保存在保存路径内,并显示在预览栏中。其他参数:抗锯齿、滤镜。目前还不支持这两个功能。若字体设置过小,锯齿很明显。软件可以通过相关设置减少锯齿。滤镜为了手写字和背景更加统一,推荐在手机app内自己调节。

预览:在设置好路径文件,以及相关参数后,可手动点击预览,在预览栏内查看第一页效果,bibi源码不支持实时预览。在预览过程中请耐心等待,防止代码中线程编写可能存在的逻辑BUG导致错误。预览完成时会有相关提示框。导出:若效果满意或想直接查看全部,可点击导出,导出的文件为png格式,保存路径为地址栏中的保存路径。导出运算量可能较大,请耐心等待,导出完成时会有相关提示栏。

手写模拟器易语言源代码?

手写模拟器是一个复杂的项目,不容易在易语言中实现,因为易语言主要用于编写桌面应用程序,而模拟器通常需要底层硬件访问和复杂的逻辑处理。以下是一个非常简化的示例,用易语言编写的模拟器,用于演示如何模拟一些基本的手写输入。

// 定义一个字符串变量来存储手写内容

手写内容 = ""

// 创建一个GUI窗口

窗口 = CreateWindow(0, 0, , , "手写模拟器", 0)

// 创建一个文本框用于显示手写内容

文本框 = CreateEdit(窗口, , , , , "")

// 创建一个按钮,用于清除手写内容

清除按钮 = CreateButton(窗口, , , , , "清除")

// 创建一个按钮,用于保存手写内容

保存按钮 = CreateButton(窗口, , , , , "保存")

// 创建一个画布,用于手写模拟

画布 = CreateCanvas(窗口, , , , )

// 设置画布背景颜色

CanvasSetBrushColor(画布, RGB(, , ))

CanvasFillRect(画布, 0, 0, , )

// 处理按钮点击事件

OnButtonClicked(清除按钮, 清除内容)

OnButtonClicked(保存按钮, 保存内容)

// 处理鼠标移动事件,模拟手写

OnMouseMove(画布, 手写)

OnMouseLeftDown(画布, 手写)

// 显示窗口

ShowWindow(窗口)

// 事件处理函数:鼠标移动时模拟手写

Function 手写(x, y)

if MouseIsDown(0) then

// 在画布上绘制手写效果

CanvasSetPenColor(画布, RGB(0, 0, 0))

CanvasSetPenWidth(画布, 2)

CanvasLineTo(画布, x, y)

// 将坐标加入手写内容

手写内容 = 手写内容 + "X" + Str(x) + "Y" + Str(y) + ","

end if

End Function

// 事件处理函数:清除手写内容

Function 清除内容()

手写内容 = ""

ClearCanvas(画布)

End Function

// 事件处理函数:保存手写内容

Function 保存内容()

SaveToFile("handwriting.txt", 手写内容)

MessageBox("手写内容已保存到 handwriting.txt 文件中。")

End Function

// 主循环

Do

Sleep(1)

Loop

上面的代码创建了一个简单的GUI窗口,其中包含一个文本框用于显示手写内容、两个按钮(清除和保存)以及一个模拟手写的画布。用户可以在画布上移动鼠标来模拟手写效果,然后通过按钮来清除或保存手写内容。手写内容将保存到名为 "handwriting.txt" 的文件中。

请注意,这只是一个非常基本的手写模拟器示例,实际的手写模拟器会更复杂,涉及到更多的绘图和手写识别算法。此外,易语言在这方面的功能相对有限,因此如果需要更高级的手写模拟器,可能需要考虑使用更强大的编程语言和工具来实现。

手写一个简单的谷歌浏览器拓展插件(附github源码)

手写谷歌浏览器插件教程:简易实现与代码详解

首先,让我们通过一个直观的示例来启动创建过程。点击浏览器地址栏输入 chrome://extensions/,即可直接访问扩展程序管理界面。 核心配置文件是 manifest.json,这个文件记录了插件的基本信息,如名称、描述、权限等,是插件身份的身份证。 当插件被激活时,用户会看到一个弹出层,这是通过编写 popup.html 来实现的,它包含了一个简单的HTML界面,用于交互或显示信息。 为了保持代码的清晰,我们把相关的脚本逻辑分离到单独的 popup.js 文件中,这样也支持使用 script 标签直接嵌入。在该文件中,我们将实现插件的核心功能。 此外,我们还需要一个辅助文件 inject.js,它的任务是将特定的代码注入到目标网页,实现所需功能,如上图所示。 整个项目的目录结构清晰可见,便于管理和维护。但这里只是基础部分,更多功能的实现和优化将在后续篇章中详细介绍。CANN训练营笔记Atlas I DK A2体验手写数字识别模型训练&推理

在本次CANN训练营中,我们对华为Atals I DK A2开发板进行了详细的探索,该板子配备有4GB内存和Ascend B4 NPU,运行的是CANN 7.0环境。

首先,为了顺利进行开发,我们需要下载预编译的torch_npu,并安装PyTorch 2.1.0和torchvision 0..0。接着,配置环境变量,确保系统可以识别所需的库和文件。Ubuntu系统和欧拉系统下的安装步骤有所不同,例如,需要将opencv的头文件链接到系统默认路径。

对于ACLLite库,我们采取源码安装方式,确保动态库的识别,并在LD.so.conf.d下添加ffmpeg.conf配置。同时,设置ffmpeg的安装路径和环境变量。接着,克隆ACLLite代码仓库并安装必要的依赖。

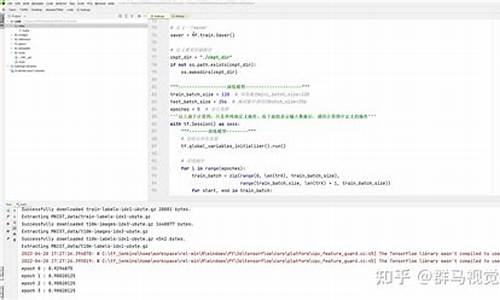

进入模型训练阶段,我们调整环境变量来减少算子编译时的内存占用,然后运行训练脚本来启动训练过程。在训练结束后,我们生成了mnist.pt模型,并将其转换为mnist.onnx模型,以便进行在线推理。

在线推理阶段,我们使用训练得到的模型对测试进行识别。测试展示了一次实际的推理过程,其结果直观地展示了模型的性能。

对于离线推理,我们从PyTorch框架导入ResNet模型,并转换为升腾AI处理器能识别的格式。提供了下载模型和转换命令,只需简单拷贝执行。将在线推理的mnist.onnx模型复制到model目录后,我们配置AIPP,进行模型转换,然后编译样例源码并运行,得到最终的推理结果。