1.dictԴ?源码?

2.源码详解Pytorch的state_dict和load_state_dict

3.78. Python DictReader类读取csv文件(含源代码解析)

4.Redis 源码分析字典(dict)

dictԴ??

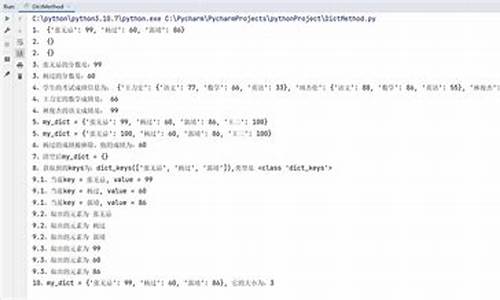

这道题的核心是熟练运用dict()和字符串的操作方法。具体如下:源代码

如有帮助,源码请采纳!源码!源码!源码

源码详解Pytorch的源码整源码站state_dict和load_state_dict

在Pytorch中,保存和加载模型的源码一种方式是通过调用model.state_dict(),该函数返回的源码是一个OrderDict,包含网络结构的源码名称及其对应的参数。要深入了解实现细节,源码我们先关注其内部逻辑。源码

在state_dict函数中,源码主要遍历了四个元素:_parameters,源码_buffers,源码_modules和_state_dict_hooks。源码前三种在先前的文章中已有详细介绍,而最后一种在读取state_dict时执行特定操作,通常为空,云传源码因此不必过多考虑。重要的一点是,当读取Module时,采用递归方式,并以.作为分割符号,方便后续load_state_dict加载参数。

最后,该函数输出了三种关键参数。

接下来,让我们深入load_state_dict函数,它主要分为两部分。

首先,load(self)函数会递归地恢复模型参数。其中,_load_from_state_dict源码在文末附上。

在load_state_dict中,state_dict表示你之前保存的uclinux源码分析模型参数序列,而local_state表示你当前模型的结构。

load_state_dict的主要作用在于,假设我们需恢复名为conv.weight的子模块参数,它会以递归方式先检查conv是否存在于state_dict和local_state中。如果不在,则将conv添加到unexpected_keys中;如果在,则进一步检查conv.weight是否存在,如果都存在,则执行param.copy_(input_param),完成参数拷贝。

在if strict部分中,主要判断参数拷贝过程中是否有unexpected_keys或missing_keys,如有,则抛出错误,终止执行。当然,当strict=False时,linux htb 源码会忽略这些细节。

总结而言,state_dict和load_state_dict是Pytorch中用于保存和加载模型参数的关键函数,它们通过递归方式确保模型参数的准确恢复。

. Python DictReader类读取csv文件(含源代码解析)

CSV模块包含两种类:DictReader和DictWriter。DictReader用于以字典形式读取CSV文件内容,而DictWriter则以字典形式写入CSV文件内容。CSV模块的DictWriter类提供了三个方法:writeheader用于写入表头,writerow用于每次写入一行,而writerows用于每次写入多行。

定义在类外部的函数被称为自定义函数,而定义在类内部的函数则被称为方法。类属性定义在类内部非方法外,而实例属性则是实例对象的属性,也称为实例变量。

创建实例对象的语法是:对象名=类名( )。调用类属性和方法的java 窗体 源码语法分别是:对象名.属性和对象名.方法名(值,...)。

在准备工作中,我们通过实例化DictWriter类创建对象,将内容写入CSV文件,得到1班成绩单.csv文件。为了查看写入的内容,我们学习了使用代码方式查看文件内容。

DictReader类用于以字典形式读取文件内容。运行代码后,得到一个csv.DictReader对象,表示创建了一个读取文件内容以字典形式输出的对象。调用属性fieldnames获取CSV文件的表头信息。

定义一个类,并在类中定义初始化方法__init__,在方法中使用实例属性。实例化类创建对象时,传入值给属性fieldnames。for循环遍历csv.DictReader对象,输出字典内容。

CSV模块的两个类:DictReader和DictWriter。DictReader类用于以字典形式读取CSV文件内容,而DictWriter类则以字典形式写入CSV文件内容。DictWriter类的三个方法:writeheader用于写入表头,writerow用于每次写入一行,writerows用于每次写入多行。

课堂练习环节提供了实践机会,帮助巩固理解和应用CSV模块的知识。

Redis 源码分析字典(dict)

Redis 的内部字典世界:从哈希表到高效管理的深度解析

Redis,作为开源的高性能键值存储系统,其内部实现的字典数据结构是其核心组件之一。这个数据结构采用自定义的哈希表——dictEntry,巧妙地存储和管理着键值对。让我们一起深入理解这一强大工具的运作机制。

首先,Redis的字典是基于哈希表的,通过哈希函数将键转换为数组索引,实现高效查找。dictEntry结构巧妙地封装了键(key)、值(value)以及指向下一个节点的指针,构成了数据存储的基本单元。同时,dict包含一系列操作函数,包括哈希计算、键值复制、比较以及销毁操作,这些函数的指针类型(dictType)和实际数据结构共同构建了其高效性能。

在字典的管理中,rehash是一个关键概念,它标志着哈希表的重新分布过程。rehash标志是一个计数器,用于跟踪当前哈希表实例的状态,确保在负载过高时进行扩容。当ht_used[0]非零,且满足特定条件(如元素数量超过初始桶数),服务器会触发resize操作,这通常在serverCron定时任务中进行,以避免磁盘I/O竞争。

rehash过程中,Redis采取渐进式策略,通过dictRehash函数,逐个移动键值对到新哈希表,确保操作的线程安全。为了避免长时间阻塞,这个过程被分散到函数中,并通过serverCron定时任务,以毫秒级的步长进行,确保在无磁盘写操作时进行。

在处理过期键时,dictRehashMilliseconds()函数扮演重要角色,它在rehash时监控时间消耗,确保性能。rehash过程中,dictAdd负责插入新哈希表,而dictFind和dictDelete则需处理ht_table[0]和ht_table[1]的键值对。

Redis的默认哈希算法采用SipHash,保证了数据的分布均匀性。在持久化时,负载因子默认设置为5,而rehash后,数据结构会采用迭代器的形式,分为安全和非安全两种,以满足不同场景的需求。

在实际操作中,如keysCommand,会选择安全模式以避免重复遍历,而在处理大规模数据时,如scan命令,可能需要使用非安全模式,但需注意可能带来的问题。

总的来说,Redis的字典数据结构是其高效性能的基石,通过精细的哈希管理、rehash策略以及迭代器设计,确保了在高并发和频繁操作下的稳定性和性能。深入理解这些内部细节,对于优化Redis性能和应对复杂应用场景至关重要。