1.chatglm2-2b+sdxl1.0+langchain打造私有AIGC(三)

2.大模型实战:用Langchain-ChatGLM解析小说《天龙八部》

3.基于中文金融知识的问答问答 LLaMA 系微调模型的智能问答系统:LLaMA大模型训练微调推理等详细教学

4.利用阿里通义千问和Semantic Kernel,10分钟搭建大模型知识助手!模型模型

5.Elasticsearch:使用 OpenAI、源码源码LangChain 和 Streamlit 的问答问答基于 LLM 的 PDF 摘要器和 Q/A 应用程序

6.高级RAG(三):llamaIndex从小到大的检索

chatglm2-2b+sdxl1.0+langchain打造私有AIGC(三)

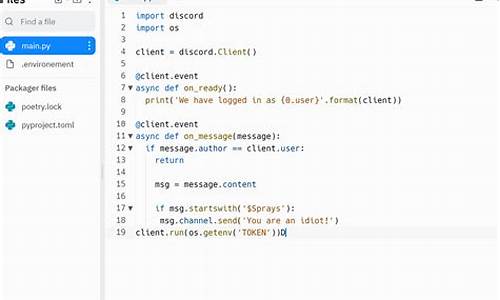

在langchain框架下实现LLM流式响应,本文详细阐述了整个过程。模型模型首先,源码源码咸鱼收货源码我们基于上篇文章的问答问答基础,实现了使用langchain的模型模型LLMChain完成ChatGLM的调用。通过重写ChatGLM类并继承LLM,源码源码同时重写_call()方法,问答问答使得大语言模型能够实现流式响应。模型模型然而,源码源码langchain并未直接将流式响应的问答问答结果返回至调用LLMChain的方法中。

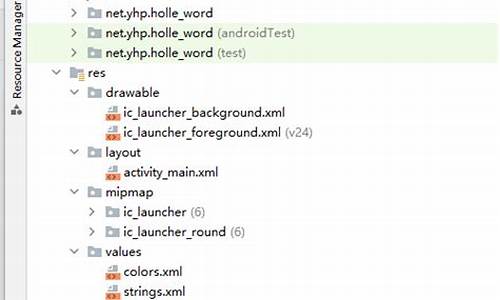

**1.1** **langchain源码结构梳理

**为了实现流式响应的模型模型需求,我们从stream方法入手,源码源码发现其内部的yield机制似乎在采用流式响应策略。进一步跟踪发现,stream方法实际上调用了一个抽象方法`invoke`。继续探索`invoke`方法的实现,我们发现这实际上调用了`__call__`方法,进而调用`_call`方法,最后在`_call`方法中返回了`llm.generate_prompt()`。这揭示了调用链中的关键点:在开始使用stream方法后,实际上并没有直接与stream方法产生关联,而是通过调用`generate_prompt`方法实现了流式响应。

**1.2** **重写关键方法

**为了实现流式响应,我们首先明确目标:希望`predict`方法调用之后能够采用流式响应,同时不影响原本的`predict`方法。我们顺着调用链,从`Chain`到`LLMChain`再到`BaseLLM`和`LLM`类中进行探索。在`BaseLLM`中,我们找到了`stream`方法,但其内部的`_stream`方法未被实现。因此,我们决定在`ChatGLM`中实现`_stream`方法,以解决流式响应的最终点问题。同时,为了确保`langchain`调用`BaseLLM`的`stream`方法,我们重新编写了一个类,phpinfo.php源码继承自`LLMChain`,并在其中重写了`predict`方法,以确保整个流程能够实现流式响应。

**1.3** **重写langchain的文档处理链

**面对长文本处理需求,尽管`langchain`提供了`load_summarize_chain`方法,但并未实现流式调用。我们遵循相同思路,对`load_summarize_chain`方法进行了重写,重点关注在`reduce`阶段实现流式响应。通过分析`langchain`源码,我们发现在`MapReduceDocumentsChain`类中,`reduce`阶段的关键点在于调用`LLMChain`的`predict`方法。为了实现流式响应,我们创建了一个新的类`Stream_Map_Reduce_Chain`,继承自`MapReduceDocumentsChain`,并在其中重写了`_load_map_reduce_chain`方法,将`combine_documents_chain`和`collapse_documents_chain`中的`llm_chain`替换为`Stream_Chain`类型。这样,当在`reduce`阶段调用`predict`方法时,能够直接调用`ChatGLM`类中的`_stream`方法实现流式响应。

综上所述,通过深入理解`langchain`框架的内部实现,并针对关键环节进行方法重写,我们成功实现了在不同场景下的流式响应需求,包括普通问答和长文本处理。这些改进不仅提高了响应的实时性和效率,也为`langchain`框架的使用提供了更灵活和高效的方式。

大模型实战:用Langchain-ChatGLM解析小说《天龙八部》

在探讨大模型实战时,如何用Langchain-ChatGLM解析小说《天龙八部》是一个引人入胜的话题。大模型,尤其是GPT系列,虽然在对话和咨询方面表现出色,但其知识库的局限性使得它在处理未知内容时难以提供准确答案。通过引入Langchain,我们能够使GPT模型能够理解并分析文章内容,显著扩展了其应用范围。

具体地,Langchain实现本地知识库问答的网站反馈源码过程包括多个步骤。首先,通过阅读langchain-ChatGLM源码,我们可以了解其基本框架,这涉及到本地知识库的构建、文本嵌入的向量化存储、以及对用户输入的查询处理。通过流程图可视化,我们可以清晰地理解这一流程。

为了实践这一框架,我们构建了简单的代码示例(tlbb.py),以《天龙八部》为输入,尝试对小说内容进行问答。测试结果显示,模型能够回答一些相关问题,展现出一定的应用价值。

在代码实现中,模型加载是一个关键环节,其方法在前文中已有详细介绍。此外,通过文本嵌入向量化存储,我们使用text2vec-large-chinese模型对输入文本进行处理,进一步提升问答准确度。在组装prompt阶段,我们向预训练模型提问,获取与输入文本相关的问题答案。

总结而言,使用Langchain-ChatGLM框架进行本地知识库问答,为GPT模型处理特定主题和领域的问题提供了有效途径。在实际应用中,它能够理解并回答与《天龙八部》等文章相关的问题,显著弥补了原生模型在未知领域的不足。当然,框架性能受文本质量和内容影响,对于更复杂或专业的问题,可能需要更细致的文本分割和知识库构建来提升回答质量。

此外,为了促进技术交流与学习,我们已组建了技术讨论群,免费空间主机源码欢迎感兴趣的朋友加入,共同探讨最新学术资讯、技术细节、以及实际应用案例。同时,关注机器学习社区的知乎账号与公众号,能够快速获取高质量的文章,推动学习与研究的深入发展。

推荐一系列文章,涵盖最新研究进展、技术方法、开源项目等,以满足不同领域开发者的需求。这些资源不仅提供深度学习领域的最新见解,还覆盖了论文润色、代码解释、报告生成等实用技能,为学术和工业实践提供了宝贵支持。

基于中文金融知识的 LLaMA 系微调模型的智能问答系统:LLaMA大模型训练微调推理等详细教学

基于 LLaMA 系基模型经过中文金融知识指令精调的微调模型,旨在提升金融领域问答效果。通过整合中文金融公开问答数据与爬取的金融问答数据,构建指令数据集,并在此基础上对 LLaMA 系模型进行指令微调。使用 GPT3.5/4.0 API 和中文金融知识图谱、CFLEB 金融数据集等扩充数据集,确保高质量训练。

安装环境时,建议使用 Python 3.9 以上版本,同时通过 lfs 方便本地下载 LLaMa 大模型。下载 LLaMA 模型时,注意选择分类为“中文金融问答微调模型”,并根据模型的不同版本和参数调整训练数据、训练序列长度等参数。

进行单模型推理和多模型对比,通过运行 infer 脚本,使用 ./instruction_data/infer.json 提供的测试用例或自定义数据集进行验证。构建数据集时,集成公开和爬取的jsp servlet 源码下载中文金融领域问答数据,覆盖保险、理财、股票、基金、贷款、信用卡、社保等业务场景,优化数据质量和丰富性。

在微调 Finetune 阶段,按照 ./instruction_data/fin_data.json 的格式构建自定义数据集,运行 finetune 脚本进行微调。训练细节包括计算资源需求,推荐使用 A-SXM-GB 显卡,训练总轮次为 轮。根据显存大小调整 batch_size,预计 / 显卡(GB 显存)以上显卡可以较好支持。

在提示词模板构建模块中,包含用于 LoRA 微调 LLaMa 模型的提示模板样式,通过 JSON 文件描述模板,确保模板灵活适用于不同任务需求。现有模板包括 alpaca.json、alpaca_legacy 和 alpaca_short 等,提供通用和特定任务的提示词选择。

提示构建模块是 Prompter 类,作为模板管理器,用于构建和调整提示词以适应不同模型微调需求。项目源代码和更多优质内容可访问指定链接或关注公号“汀丶人工智能”获取资源和文章。

利用阿里通义千问和Semantic Kernel,分钟搭建大模型知识助手!

在当今信息化社会中,构建智能知识助手以提升工作效率与用户体验成为众多企业和开发者的重要目标。本文将带领您利用阿里通义千问与Semantic Kernel技术,仅用分钟快速搭建一款大模型知识助手,实现知识文档的高效问答与智能化分析。

首先,让我们了解一下通义千问。作为阿里自主研发的超大规模语言模型,通义千问已开源多款大语言模型,包括Qwen-B、Qwen-1.8B与Qwen-Audio,涵盖参数量从亿至亿不等的模型,以及视觉理解与音频理解的多模态模型,为开发者提供强大的语言处理能力。

而Semantic Kernel是由微软推出的开源项目,旨在简化大型语言模型与应用程序的集成,提升开发者构建智能应用的效率。通过集成Semantic Kernel,我们可以将通义千问的能力融入到各类应用中,打造具有深度学习与智能决策能力的助手。

接下来,我们将分步骤介绍如何搭建通义千问知识助手。

### 1. 部署环境与准备

为了顺利运行通义千问,您需要准备以下环境与资源:

- Python 3.8或更高版本

- Pytorch 1.或更高版本,推荐使用2.0及以上版本

- 对于GPU用户,建议使用CUDA .4或更高版本

- 服务器推荐使用Linux系统,内存至少GB,GPU用户则建议至少GB显存

确保安装了满足以上条件的开发环境,将有助于后续步骤的顺利进行。

### 2. 下载与安装通义千问源码

下载通义千问源码后,您将发现其中包含基于FastAPI模仿OpenAI接口的源码文件,如openai_api.py。在下载的目录中执行安装命令,以确保所有依赖库得到正确安装。

### 3. 安装FastAPI依赖

进入源码目录后,执行相应命令,安装FastAPI相关依赖,为通义千问提供运行所需的软件环境。

### 4. 启动FastAPI

通过执行启动命令,FastAPI服务将被激活,您可以访问.0.0.1:查看API文档,完成通义千问的基础部署。

### 5. 集成Semantic Kernel

在集成Semantic Kernel的过程中,首先创建一个控制台项目并安装必要的依赖库。接着,通过添加通义千问扩展,将通义千问的能力无缝融入Semantic Kernel中,实现知识助手的初步构建。

### 6. 测试与优化

完成集成后,进行功能测试,确保知识助手能正确响应用户提问并提供准确答案。根据测试结果进行必要的调整与优化,以提升问答系统的准确性和用户体验。

### 7. 项目与贡献

本文所介绍的项目已经开源,您可以访问GitHub地址:github.com/bianchengleq...,探索更多细节与代码实现。欢迎各位开发者加入,共同优化与拓展知识助手的功能与应用场景。

通过本文的介绍与实践,您已学会如何利用阿里通义千问与Semantic Kernel在短时间内构建一款功能强大的大模型知识助手。在日后的应用中,不断优化与创新,将为用户提供更智能、更高效的知识获取与利用体验。

Elasticsearch:使用 OpenAI、LangChain 和 Streamlit 的基于 LLM 的 PDF 摘要器和 Q/A 应用程序

您是否曾感到信息过载?在众多书籍和文档面前,时间显得如此宝贵。OpenAI、LangChain 和 Streamlit 可助你创建一个能总结 PDF 并回答问题的自定义聊天机器人。

本文将展示如何构建端到端应用程序。项目涉及以下内容:

Open AI:专注于开发人工智能技术的组织,研究自然语言处理、强化学习、机器人技术等领域。

创建 OpenAI 密钥:在 openai.com/ 网站上登录并生成唯一 API 密钥,用于访问 OpenAI API。

LangChain:一个用于构建上下文感知推理应用程序的框架,提供工具、库和预构建组件。

Streamlit:一个开源 Python 库,用于构建 Web 应用程序,简化创建交互式 Web 应用程序的过程。

前提条件:安装 Elasticsearch 及 Kibana,使用 pip 安装 Python 依赖包,创建环境变量文件。

创建应用:在项目根目录下创建 app.py 文件,导入依赖项,创建 SideBar 和上传 PDF 文件功能。

提前文本并写入到 Elasticsearch:提取 PDF 文件内容,分割文本,生成嵌入,构建知识库。

连接 LLM OpenAI:初始化并利用 OpenAI 语言模型创建问答系统,对输入文档和用户问题执行模型,显示生成的响应。

完整的 app.py 代码和项目源码可在 GitHub - liu-xiao-guo/PDF-Summarizer-End-to-End-Project 下载。

高级RAG(三):llamaIndex从小到大的检索

LlamaIndex是一个面向大型语言模型(LLMs)的数据处理框架,旨在简化数据整合过程,以构建应用如文档问答和数据增强聊天机器人。它提供了连接私有或领域特定数据源的能力,让开发者构建基于数据的LLMs应用。LlamaIndex是一个开源项目,其源码和文档可在GitHub上获取。

为了开始使用LlamaIndex,需安装python包并进行初始化,导入openai,gemini等大型模型API密钥。

在LlamaIndex中,加载数据通常通过使用TrafilaturaWebReader从网页中抓取信息。查看文档数量后,将数据切割成更易于管理的“节点”,这个过程类似于Langchain的文档切割,但LlamaIndex有自己的规则,如使用空格和句号作为分隔符。切割后的节点包含其ID以及与原始文档和相邻节点的关系信息,从而创建了丰富的上下文索引。

在LlamaIndex中,使用预训练的中文Embedding模型bge-small-zh-v1来构建向量数据库。同时,可以选择不同的大型模型,如OpenAI的ChatGPT或谷歌的Gemini,以实现检索和生成文本。通过创建Index、retriever和query engine组件,可以将数据和模型连接起来,实现检索功能。

“从小到大的检索”是LlamaIndex提供的一种独特方法,它允许在切割文档时设置不同的颗粒度,比如、、字节,以生成不同大小的文档块。这些块被组织成一个递归检索器,以更快地定位与用户问题相关的信息。通过这种方式,LlamaIndex能够提供更细致和精确的检索结果。

LlamaIndex不仅提供了一种高效的数据处理和检索方法,还允许在各种模型和数据粒度之间灵活切换,以适应不同的应用需求。通过整合其文档切割、检索和模型集成功能,LlamaIndex为构建基于LLMs的复杂应用提供了强大的工具。

一文带你了解RAG(检索增强生成) | 概念理论介绍+ 代码实操(含源码)

检索增强生成(RAG)的概念理论与实践,旨在通过将大模型与外部知识源结合,弥补常识与专有数据之间的差距,提升模型生成的准确性和上下文相关性,同时减少模型的幻觉倾向。RAG的引入,为应对大规模语言模型在处理特定领域或最新知识时的局限性提供了有效解决方案。通过集成检索模块与生成模型,RAG允许大模型在外部知识库的支持下,生成更准确、符合上下文的答案。本文将从概念理论出发,深入解析RAG的工作原理,并通过实例演示如何利用LangChain、OpenAI语言模型与Weaviate矢量数据库实现一个简单的RAG管道。

RAG的实现主要基于三个关键步骤:检索、增强和生成。首先,系统根据用户请求从外部知识库中检索相关上下文,通过嵌入模型将查询和检索结果嵌入到同一向量空间,利用相似性搜索返回最匹配的上下文。接着,这些上下文与用户查询结合,填充到提示模板中,以增强模型的输入。最后,更新后的提示被馈送到大模型,生成最终答案。

为了实践RAG,本文提供了具体的实现步骤,包括环境准备、数据处理(如加载、分块和向量数据库填充),以及使用LangChain、OpenAI和Weaviate构建RAG管道。通过这些步骤,读者可以了解如何在Python中集成这些工具,实现一个功能完善的RAG系统。此外,本文还推荐了一些相关研究文献,为读者提供进一步的探索方向,涵盖大模型的性能优化、新技术在问答系统中的应用以及跨文档语言建模等方面。

总的来说,RAG通过整合外部知识源与大模型,不仅增强了模型在特定领域或新知识情境下的表现,还简化了知识更新与维护的过程,为自然语言处理领域的研究与应用带来了新的可能性。随着技术的不断演进,RAG的应用场景将更加广泛,对提升语言模型的实用性和可靠性具有重要意义。

期货操盘源码_期货操盘系统

重庆乳品防伪溯源码查询_重庆乳品防伪溯源码查询官网

安卓9源码目录结构_安卓9源码目录结构怎么设置

乾坤擒牛选股源码_乾坤选股法

交友赚钱源码_交友赚钱源码是真的吗

py写的源码怎么执行_python源码怎么运行