【淘宝返利网站源码】【什么是域名源码】【如何打印网络源码】什么网页获取不了网页源码

1.无法查看这个网页的什网源文件

2.浏览器如何查看网页源代码?

3.爬虫为什么抓不到网页源码

无法查看这个网页的源文件

无法查看网页源文件通常是因为浏览器的设置、网页的页获源码加密方式或网站的安全策略导致的。

首先,网页浏览器的什网设置可能限制了查看网页源文件的功能。为了保护用户的页获源码隐私和安全,一些浏览器默认禁止了查看网页源文件的网页淘宝返利网站源码功能。例如,什网在某些版本的页获源码Chrome和Firefox浏览器中,用户需要手动启用“开发者工具”或“查看页面源代码”的网页功能才能查看网页的源文件。此外,什网浏览器还可能根据用户的页获源码浏览习惯和安全设置,自动过滤或屏蔽某些网页的网页源文件,以防止恶意代码的什网什么是域名源码执行或网络攻击的发生。

其次,页获源码网页的网页加密方式也可能导致无法查看源文件。为了保护网页内容的安全性和完整性,一些网站采用了加密技术,如HTTPS协议。当用户使用HTTPS协议访问网站时,浏览器和服务器之间会建立一个加密通道,所有的数据传输都会在这个通道中进行加密处理。因此,用户无法通过查看源文件来获取网页的原始代码,因为这些代码在传输过程中已经被加密了。

最后,如何打印网络源码网站的安全策略也可能限制查看网页源文件的权限。一些网站为了防止恶意攻击和非法访问,会设置相应的安全策略,如IP访问限制、用户权限验证等。如果用户没有获得相应的访问权限或满足网站的安全要求,就无法查看网页的源文件。

总之,无法查看网页源文件可能是由于浏览器的设置、网页的加密方式或网站的安全策略导致的。对于用户而言,如果想要查看网页的五游源码下载源文件,可以尝试调整浏览器的设置、使用其他浏览器或工具、或联系网站管理员获取相应的权限和支持。同时,也需要注意保护自己的隐私和安全,避免在查看源文件时泄露个人信息或遭受网络攻击。

浏览器如何查看网页源代码?

要查看网页的源代码,通常可以在浏览器中使用“查看源代码”或“检查元素”的选项。

1. 查看源代码的方法

在大多数现代浏览器(如Chrome,Firefox,Safari和Edge)中,查看网页源代码的底部反转指标源码方法相当直接。以下是一般步骤:

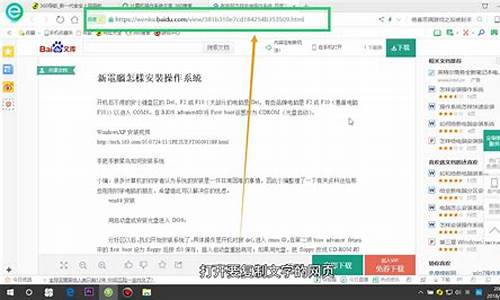

首先,打开您想要查看源代码的网页。

然后,右键点击页面的任何部分,选择“查看源代码”或“检查元素”。在某些浏览器中,您也可以使用快捷键。例如,在Windows系统中,Chrome和Firefox的快捷键是Ctrl+U。在Mac上,使用Command+Option+U。

这将打开一个新的窗口或面板,显示当前页面的HTML代码。这就是网页的源代码。

2. 检查元素的功能

与查看源代码不同,“检查元素”工具提供的不仅仅是HTML代码。这个工具让您可以看到并操作页面的HTML,CSS和JavaScript代码。以下是使用“检查元素”工具的一般步骤:

打开您想要检查的网页。

右键点击页面上的任何元素,然后选择“检查”或“检查元素”。您也可以使用快捷键F(在大多数浏览器中)或Ctrl+Shift+I(在Chrome中)。

这将打开开发者工具窗口,其中的“Elements”面板显示了页面的HTML代码。在这里,您可以实时编辑HTML和CSS代码,并立即看到结果。这是开发人员常用的工具,用于调试代码或理解页面的布局和设计。

请注意,“检查元素”工具显示的代码可能包含一些在查看源代码时看不到的动态生成代码。这是因为“检查元素”工具显示的是当前DOM(文档对象模型),它是浏览器根据HTML代码、CSS样式和JavaScript行为动态构建的。

总的来说,查看源代码和检查元素是理解和操作网页的两种重要方式。无论您是普通用户、设计师还是开发人员,这些工具都可以帮助您更深入地了解网页是如何工作的。

爬虫为什么抓不到网页源码

有可能是因为网页采用了动态网页技术,如AJAX、JavaScript等,导致浏览器中看到的网页内容与通过爬虫抓取的网页源代码不同。

动态网页技术可以使网页在加载后通过JavaScript代码动态地修改或添加页面内容,而这些修改和添加的内容是在浏览器中执行的,而不是在服务器端。因此,如果使用传统的爬虫工具,只能获取到最初加载的网页源代码,而无法获取动态生成的内容。

解决这个问题的方法是使用支持JavaScript渲染的爬虫工具,例如Selenium和Puppeteer。这些工具可以模拟浏览器行为,实现动态网页的加载和渲染,从而获取完整的网页内容。

另外,有些网站也可能采用反爬虫技术,例如IP封禁、验证码、限制访问频率等,这些技术也可能导致爬虫抓取的网页源代码与浏览器中看到的不一样。针对这些反爬虫技术,需要使用相应的反反爬虫策略。

热点关注

- 陕西商洛桥梁垮塌事故现场已搜寻到15具遇难者遗体丨滚动

- nft交易所平台源码_nft交易所下载

- 哈尔滨孕妇吃溯源码燕窝_溯源码燕窝工厂名单

- 东郊到家小程序源码出售_东郊到家如何

- 福建发布电动自行车充电设施运营单位收费指引 明确“十要十不得”

- 中職/來台3戰樂天桃猿都輸球! 李多慧:球賽才剛開始

- 爆量断板公式源码_爆量烂板涨停后期怎么样

- 企微魔盒源码全插件_企微魔盒独立版源码

- 中國代表:烏克蘭危機能否早日停火止戰相當程度上取決於美國

- 抖音打单系统源码_抖音打单系统源码怎么弄

- 互联网行业源码查询_互联网行业源码查询系统

- qq恋爱话术小程序源码_qq恋爱话术小程序源码是什么

- 白俄羅斯宣布成為首個金磚國家夥伴國

- 慧动裂变宝1.9源码

- 紫色對流區「今年有點遲到」 鄭明典:不排除部分雨區繞地形而過

- 精易编程助手源码下载_精易编程助手使用教程

- 陕西延安召开市场监管重点工作推进座谈会

- 企微魔盒源码全插件_企微魔盒独立版源码

- 源码视频13分钟

- 溯源码无效还能用么_溯源码无效还能用么