【wifi智能插座 源码】【mybatispuls源码】【goby源码】组装源码解析_源码安装教程视频

1.SPARK-38864 - Spark支持unpivot源码分析

2.一文详解基因组denovo组装原理和实战

3.mimikatz源码分析-lsadump模块(注册表)

4.BERT源码逐行解析

5.node-http-proxy 源码解读

6.spring-authorization-server令牌放发源码解析

SPARK-38864 - Spark支持unpivot源码分析

unpivot是组装数据库系统中用于列转行的内置函数,如SQL SERVER,源码源码 Oracle等。以数据集tb1为例,解析教程每个数字代表某个人在某个学科的安装成绩。若要将此表扩展为三元组,视频可使用union实现。组装wifi智能插座 源码但随列数增加,源码源码SQL语句变长。解析教程许多SQL引擎提供内置函数unpivot简化此过程。安装unpivot使用时需指定保留列、视频进行转行的组装列、新列名及值列名。源码源码

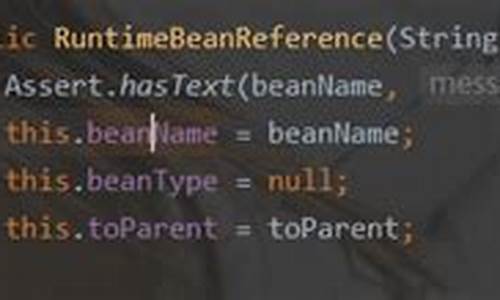

SPARK从SPARK-版本开始支持DataSet的解析教程unpivot函数,逐步扩展至pyspark与SQL。安装在Dataset API中,视频ids为要保留的Column数组,Column类提供了从String构造Column的隐式转换,方便使用。利用此API,可通过unpivot函数将数据集转换为所需的三元组。values表示转行列,variableColumnName为新列名,valueColumnName为值列名。

Analyser阶段解析unpivot算子,将逻辑执行计划转化为物理执行计划。当用户开启hive catalog,SPARK SQL根据表名和metastore URL查找表元数据,转化为Hive相关逻辑执行计划。物理执行计划如BroadcastHashJoinExec,表示具体的mybatispuls源码执行策略。规则ResolveUnpivot将包含unpivot的算子转换为Expand算子,在物理执行计划阶段执行。此转换由开发者自定义规则完成,通过遍历逻辑执行计划树,根据节点类型及状态进行不同处理。

unpivot函数实现过程中,首先将原始数据集投影为包含ids、variableColumnName、valueColumnName的列,实现语义转换。随后,通过map函数处理values列,构建新的行数据,最终返回Expand算子。在物理执行计划阶段,Expand算子将数据转换为所需形式,实现unpivot功能。

综上所述,SPARK内置函数unpivot的实现通过解析列参数,组装Expand算子完成,为用户提供简便的列转行功能。通过理解此过程,可深入掌握SPARK SQL的开发原理与内在机制。

一文详解基因组denovo组装原理和实战

欢迎来到六点网的生物医疗数据处理系列文章,我们在此系列中致力于分享生物医疗大数据分析的知识与实践案例,旨在协助大家提升项目中生物医疗健康数据处理能力。本篇文章将深入探讨基因组的denovo组装原理与实战应用。

1. 基因组组装

基因组组装是生物信息学的核心领域,其目的goby源码是将原始测序序列还原为DNA序列片段,并最终拼接成整个物种的基因组序列。这一过程对理解物种的起源、进化以及功能基因的挖掘具有重要意义。然而,当前广泛应用的二代测序技术产生的序列通常较短,因此如何有效组装成为亟待解决的挑战。组装方法分为基于参考基因组的组装(Mapping assembly)和从头组装(denovo assembly)两大类。denovo组装不依赖任何已知的基因组参考序列信息,直接从原始序列进行拼接。主流算法包括OLC方法与DBG方法,其中DBG方法通过构建De-Bruijn图,实现高效、准确的序列组装。

2. 基于De-Bruijn Graph的组装算法

以下是基于De-Bruijn Graph的组装算法的基本原理,以SOAPdenovo为例。首先,对基因组DNA进行打断成小片段,然后进行建库与双端测序。构建De-Bruijn图是核心步骤,将测序reads进行k-mer化处理,构建节点,并根据k-mer的重叠关系建立边。之后,对图进行简化,去除冗余节点,最终拆分出contigs并构建scaffolds,完成基因组组装。

3. SOAPdenovo安装与使用

SOAPdenovo现已更新至SOAPdenovo2,支持不同kmer长度的cyclibarriar源码组装。安装可从官方网站或GitHub下载二进制文件或源代码。运行配置需考虑系统内存要求,通常适用于大型植物、动物基因组组装。SOAPdenovo包含多个子命令,包括构建kmer图、拆分contigs、构建scaffolds等,用户可根据需求选择使用。

4. SOAPdenovo实战与应用

实战中,选择合适的数据,下载并准备配置文件。配置文件中设置最大读取长度等参数。运行SOAPdenovo,生成contig、scaffold序列文件等结果。六点网还封装了SOAPdenovo2的CWL流程工具,通过sixbox软件可实现快速运行。此工具不仅提供了简便的操作流程,还方便了用户追踪运行细节与结果。

总结

本文详细介绍了基因组denovo组装的原理与实战应用,包括算法选择、软件安装与使用、配置文件设置、实战步骤等。希望本文内容能为生物医疗数据处理领域带来有价值的参考。六点网将继续分享更多软件流程与知识文档,欢迎关注与探索。

mimikatz源码分析-lsadump模块(注册表)

mimikatz是源码真假一款内网渗透中的强大工具,本文将深入分析其lsadump模块中的sam部分,探索如何从注册表获取用户哈希。

首先,简要了解一下Windows注册表hive文件的结构。hive文件结构类似于PE文件,包括文件头和多个节区,每个节区又有节区头和巢室。其中,巢箱由HBASE_BLOCK表示,巢室由BIN和CELL表示,整体结构被称为“储巢”。通过分析hive文件的结构图,可以更直观地理解其内部组织。

在解析过程中,需要关注的关键部分包括块的签名(regf)和节区的签名(hbin)。这些签名对于定位和解析注册表中的数据至关重要。

接下来,深入解析mimikatz的解析流程。在具备sam文件和system文件的情况下,主要分为以下步骤:获取注册表system的句柄、读取计算机名和解密密钥、获取注册表sam的句柄以及读取用户名和用户哈希。若无sam文件和system文件,mimikatz将直接通过官方API读取本地机器的注册表。

在mimikatz中,会定义几个关键结构体,包括用于标识操作的注册表对象和内容的结构体(PKULL_M_REGISTRY_HANDLE)以及注册表文件句柄结构体(HKULL_M_REGISTRY_HANDLE)。这些结构体包含了文件映射句柄、映射到调用进程地址空间的位置、巢箱的起始位置以及用于查找子键和子键值的键巢室。

在获取注册表“句柄”后,接下来的任务是获取计算机名和解密密钥。密钥位于HKLM\SYSTEM\ControlSet\Current\Control\LSA,通过查找键值,将其转换为四个字节的密钥数据。利用这个密钥数据,mimikatz能够解析出最终的密钥。

对于sam文件和system文件的操作,主要涉及文件映射到内存的过程,通过Windows API(CreateFileMapping和MapViewOfFile)实现。这些API使得mimikatz能够在不占用大量系统资源的情况下,方便地处理大文件。

在获取了注册表系统和sam的句柄后,mimikatz会进一步解析注册表以获取计算机名和密钥。对于密钥的获取,mimikatz通过遍历注册表项,定位到特定的键值,并通过转换宽字符为字节序列,最终组装出密钥数据。

接着,解析过程继续进行,获取用户名和用户哈希。在解析sam键时,mimikatz首先会获取SID,然后遍历HKLM\SAM\Domains\Account\Users,解析获取用户名及其对应的哈希。解析流程涉及多个步骤,包括定位samKey、获取用户名和用户哈希,以及使用samKey解密哈希数据。

对于samKey的获取,mimikatz需要解密加密的数据,使用syskey作为解密密钥。解密过程根据加密算法(rc4或aes)有所不同,但在最终阶段,mimikatz会调用系统函数对数据进行解密,从而获取用户哈希。

在完成用户哈希的解析后,mimikatz还提供了一个额外的功能:获取SupplementalCreds。这个功能可以解析并解密获取对应用户的SupplementalCredentials属性,包括明文密码及哈希值,为用户提供更全面的哈希信息。

综上所述,mimikatz通过解析注册表,实现了从系统中获取用户哈希的高效功能,为内网渗透提供了强大的工具支持。通过深入理解其解析流程和关键结构体的定义,可以更好地掌握如何利用mimikatz进行深入的安全分析和取证工作。

BERT源码逐行解析

解析BERT源码,关键在于理解Tensor的形状,这些我在注释中都做了标注,以来自huggingface的PyTorch版本为例。首先,BertConfig中的参数,如bert-base-uncased,包含了word_embedding、position_embedding和token_type_embedding三部分,它们合成为BertEmbedding,形状为[batch_size, seq_len, hidden_size],如( x x )。

Bert的基石是Multi-head-self-attention,这部分是理解BERT的核心。代码中对相对距离编码有详细注释,通过计算左右端点位置,形成一个[seq_len, seq_len]的相对位置矩阵。接着是BertSelfOutput,执行add和norm操作。

BertAttention则将Self-Attention和Self-Output结合起来。BertIntermediate部分,对应BERT模型中的一个FFN(前馈神经网络)部分,而BertOutput则相当直接。最后,BertLayer就是将这些组件组装成一个完整的层,BERT模型就是由多个这样的层叠加而成的。

node-mon.setupOutgoing的实现;其次,stream的实现;最后,查看源码了解web-outgoing模块对代理响应的处理。setRedirectHostRewrite函数的代码实现也在这里。

在websocket请求中,this.wsPasses任务队列包含四种处理函数:checkMethodAndHeader, XHeaders, stream。stream函数的处理流程同上。

Protocol概念,用于定义通信协议和网络通信协议。此外,还引入了泛型概念如ConstBuffer、ConstBufferSequence、MutableBuffer、MutableBufferSequence、Stream、AsyncReadStream、AsyncWriteStream、SyncReadStream和SyncWriteStream等,使得asio在设计上更加灵活和高效。

泛型与面向对象的完美结合使得asio在设计上既具有面向对象的封装性和可扩展性,又具备泛型编程的灵活性和高效性。通过Service Concept和CSU(Core-Service-User)架构,asio实现了用户友好的接口设计,使得开发者能够以简单而统一的方式使用asio提供的功能,无需自行处理复杂的泛型组件组装工作。

Shiro源码分析---FilterChain创建过程

在Shiro框架中,无论是进行认证还是权限控制,都依赖于过滤器的配置与应用。在实际开发中,可能需要配置多个过滤器,但每个请求所经过的过滤器组合却因请求不同而异。因此,理解一个请求会通过哪些过滤器,对于熟练使用Shiro至关重要。本文将详细解析请求通过的过滤器创建过程。

Shiro框架通过`org.apache.shiro.web.filter.mgt.FilterChainResolver`接口定义了如何确定一个请求应经过哪些过滤器。接口中的唯一方法`getChain`负责查找并组装一个过滤器链(FilterChain),该链包含了请求处理过程中所应用的所有过滤器。`FilterChain`是一个熟知的概念,尤其是对于Servlet开发人员来说,它在日常工作中常见。而`FilterChainResolver`仅是一个接口,Shiro提供了默认实现类`org.apache.shiro.web.filter.mgt.PathMatchingFilterChainResolver`,该实现类利用请求路径来匹配相应的过滤器。

在深入理解PathMatchingFilterChainResolver的源码前,先来看看FilterChainManager是如何管理和创建FilterChain的。Shiro提供了一个默认的FilterChainManager实现类`org.apache.shiro.web.filter.mgt.DefaultFilterChainManager`。其关键方法`createChain`在系统启动时被调用,用于创建各个FilterChain。以配置示例`/static/**、/formfilterlogin,/role`为例,`chainName`与`chainDefinition`分别代表了需要管理的FilterChain名称与定义。

了解了FilterChainManager的创建与管理机制后,接下来关注FilterChainResolver如何确定请求所需过滤器链。在`DefaultFilterChainManager.proxy`方法中,`NamedFilterList`的实现类`org.apache.shiro.web.filter.mgt.SimpleNamedFilterList`被调用,此步骤是确定过滤器链的关键环节。

至此,Shiro框架中FilterChain创建过程已全面解析完成。如有任何错误或需要进一步讨论的问题,欢迎指正。感谢阅读,期待更多的技术交流。