1.做个 ROS 2 视觉检测开源库-YOLO介绍与使用

2.钉钉机器人源码解析与本地搭建教程

3.AI白身境搞计算机视觉必备的机器觉系计源OpenCV入门基础

4.openmv是什么

5.干货|开源MIT Min cheetah机械狗设计(十四)运动控制器源码解析---四足机器人浮动基动力学模型创建

6.自主LLM机器人(Agent)原理和实现

做个 ROS 2 视觉检测开源库-YOLO介绍与使用

在无人驾驶和室内工作场景中,机器人需要进行物体识别。人视计算机视觉技术在机器人系统中扮演着至关重要的统设角色。YOLO(You Only Look Once)是码机一种高速而准确的目标检测算法,能够实时识别图像或视频中的器人多个对象,而无需多次检测。视觉天兔商城 源码本章将详细介绍如何将目标检测算法YOLO与ROS 2集成,代码同时探讨如何创建一个开源库来完成目标检测任务。机器觉系计源

目标检测是人视计算机视觉领域中的一项重要任务,它的统设主要作用是识别图像中的物体并确定其位置。YOLO 就是码机一种高效且准确的多物体检测算法,其特点是器人速度快,能够捕捉到目标的视觉全局信息,减少了背景误检的代码情况。YOLO 有多个版本,机器觉系计源本章我们选用安装更为方便和更容易投入生产的 YOLOv5 作为我们学习和使用的版本。

在系统上安装 YOLOv5 非常简单,只需要通过 Python 包管理器 pip,一行命令就可以安装。如果对源码感兴趣或者有修改源码需求的小伙伴,可以通过下载源码方式进行安装。安装完成后,就可以使用命令行工具进行训练和检测。这里使用 YOLOv5 提供的训练好的常见物体的目标检测模型进行演示,通过命令下载模型文件和待检测。对于 zidane.jpg ,一共检测出了三个物体,耗时 .8ms。有了模型文件和,使用命令就可以对该进行目标检测。

除了直接检测一个本地,也可以直接指定系统视频设备的编号来启动实时的检测。感受完 YOLO 的强大,要想让 YOLO 结合 ROS 2 一起使用,我们还要掌握如何使用 Python 调用 yolov5 模块,完成检测。

钉钉机器人源码解析与本地搭建教程

首先,了解钉钉机器人源码的概述,明确其主要通过钉钉开放平台提供的API接口实现功能。尽管官方不直接提供完整源码,但开发者能从API的使用方式出发,学习并实现与钉钉机器人的交互。

为了本地搭建模拟环境,使用Python等编程语言结合钉钉API文档进行开发。这里提供一个简单的Python脚本示例,用于模拟向钉钉群发送消息。实际开发中,手机号码空号筛选源码可能需要解析更复杂的消息类型,如Markdown、ActionCard等,并根据业务需求定制机器人响应逻辑。

考虑跨平台联动,尽管钉钉与WhatsApp属于不同平台,通过中间服务或第三方工具实现消息互通成为可能。例如,构建一个桥梁服务,监听钉钉机器人发送的消息,根据内容决定是否转发至WhatsApp机器人,从而为全球化办公场景提供更广泛的沟通空间。

通过本地搭建与源码解析,开发者能灵活运用钉钉API,实现个性化机器人功能,并探索跨平台消息互通的潜力,为企业沟通提供多样化的解决方案。

AI白身境搞计算机视觉必备的OpenCV入门基础

在《AI白身境》系列的第五篇文章中,我们探讨了如何利用开源的计算机视觉库OpenCV,实现机器人视觉处理,例如设计一个能识别并跟随猫咪的自平衡机器人。OpenCV是实现计算机视觉任务的理想选择,尤其适合初学者入门。

OpenCV由Intel公司俄罗斯团队开发,支持多种编程语言(C++、C和Python等),跨平台运行,并且活跃的开发团队保证了其持续更新。版本4.0提供了丰富的API,包括传统计算机视觉算法和深度学习支持,几乎能覆盖所有图像处理任务。

要开始使用OpenCV,首先在Ubuntu系统上,可以分别通过C++和Python进行安装。C++版本的安装过程涉及编译OpenCV源码,而Python版本则通过pip安装。OpenCV的核心模块包括core、highgui和imgproc,而其他高级功能模块如shape、superres等则在opencv_contrib中。

OpenCV提供了多种基础数据结构,如Mat类(矩阵数据结构)、Point(坐标点)、Size(图像尺寸)、Rect(矩形)、Scalar(颜色)和Vec(向量)。快手直播间点赞源码怎么找理解这些数据结构是使用OpenCV的关键。

在基本操作方面,OpenCV支持图像读写、缩放、翻转以及通道处理等。例如,cv2.imread()用于读取图像,cv2.imshow()显示图像,cv2.resize()用于图像缩放,cv2.flip()实现图像翻转。

如果你想深入学习OpenCV,可以参考网络资源和中文书籍,同时建议按照特定的学习路径,如从基础模块开始,逐步过渡到更高级的主题。

下一期,我们将探讨Makefile和CMake的基础知识。现在开始,你可以通过这些基础内容,踏上OpenCV的学习之旅,为计算机视觉项目打下坚实的基础。

openmv是什么

OpenMV是一种基于MicroPython的嵌入式视觉开发平台。 接下来详细解释OpenMV的概念和应用: 一、OpenMV的基本定义 OpenMV是一个开放源代码的嵌入式视觉开发平台,它允许开发者利用MicroPython语言进行编程,以实现对摄像头的控制和处理图像数据的功能。OpenMV提供了一个灵活的框架,让开发者能够便捷地在嵌入式系统中实现计算机视觉相关的应用。由于MicroPython的简单性和Python语言的广泛使用,OpenMV大大降低了嵌入式视觉开发的门槛。 二、OpenMV的应用领域 OpenMV广泛应用于各种需要实时图像处理和机器视觉的应用场景。例如,它可以用于自动化检测、机器人导航、目标跟踪、手势识别等。开发者可以通过编写脚本,利用OpenMV的功能实现对摄像头的控制,进行图像采集、处理和分析等操作。此外,OpenMV还支持与多种传感器和执行器进行连接,从而构建更为复杂的智能系统。 三、OpenMV的服装加工厂找订单源码网站特点与优势 1. MicroPython编程环境:OpenMV采用MicroPython语言进行编程,语言简单易学,适合初学者快速上手。同时,MicroPython代码的运行效率高,能够满足实时性要求较高的应用场景。 2. 丰富的库和API支持:OpenMV提供了丰富的库和API,支持各种图像处理和计算机视觉算法的实现。开发者可以利用这些库和API快速开发出功能强大的视觉应用。 3. 开源和定制化:作为一个开源项目,OpenMV允许开发者根据自己的需求进行定制和二次开发。开发者可以通过社区分享自己的经验和代码,从而实现更广泛的交流和合作。同时,由于源代码开放,开发者可以更好地理解和优化自己的应用。 总的来说,OpenMV是一个强大的嵌入式视觉开发平台,它结合了MicroPython的简单性和灵活性,使得开发者能够便捷地实现各种计算机视觉应用。无论是在工业自动化、智能家居还是智能安防等领域,OpenMV都展现出了广阔的应用前景。干货|开源MIT Min cheetah机械狗设计(十四)运动控制器源码解析---四足机器人浮动基动力学模型创建

干货MIT Min Cheetah机械狗设计详解(十四):动力学模型创建 对于机器人爱好者和初入机器人领域的专业人士,开源MIT Min Cheetah系列设计无疑是一份宝贵资源。本文将深入探讨RobotRunner核心模块,包括数据更新、步态规划、控制算法和命令发送,尤其是关键的浮动基动力学模型构建。 首先,我们从单刚体动力学模型开始,简化机械狗的复杂动态,计算足底反作用力,但此方法在高速运动时并不适用。为解决高速情况下的适应性,浮动基动力学模型引入,它在单刚体基础上优先满足动态响应,如WBC控制器的需要。模型创建包括:浮动基动力学模型参数设置:定义机械狗整体的配置空间和关节自由度,引入6个表示身体浮动基的自由度。

广义惯量和空间惯量:每个连杆和关节电机的广义惯性张量(包括质量、质心位置和旋转惯量)是动力学计算的基础。

连杆位置向量:这些参数用于后续的运动旋量计算。

浮动基动力学模型:以拉格朗日单腿动力学为基础,考虑机械狗整体的运动状态和力矩映射。

动力学方程的网站对接小程序源码怎么弄构造:包括动力学方程组、约束方程和构型角度约束,以及外力和转矩的关系。

代码中,通过`forwardKinematics()`函数计算关节和连杆的空间变换,为求解质量矩阵、非惯性力矩阵和接触雅可比矩阵做准备。在冗余自由度的系统中,浮动基动力学模型与WBC结合,最终计算出关节的控制参数。 总结,浮动基动力学模型的创建是实现高精度控制的关键步骤,它为后续的动力学方程求解提供了关键参数。理解这些核心概念,将有助于深入理解四足机器人动态控制的奥秘。自主LLM机器人(Agent)原理和实现

上个月,Devin 成为科技界热门话题,它是一个能自主决策并修复 bug 的 AI 机器人,在 SWE-bench 基准测试中,Devin 能够解决 .% 的问题,而 GPT-4 只能处理 1.%。开源界迅速跟进复现,swe-Agent、openDevin、devika 等项目相继出现,引起广泛关注。

通过阅读这些项目源码,发现它们基于自我反思与 reAct 模式扩展,但实现细节差异显著。以 opendevin 为例,这类机器人基于 reAct 模式,实现更全面的扩展,如搜索、计算、浏览网页等,同时具备记忆、沙盒环境与权限管理功能。

opendevin 的沙盒环境开放了丰富的命令执行权限,允许执行如 curl、wget、git 等操作,甚至支持在 Debian 系统中执行任何命令,且能自主安装依赖,如 nodejs。此外,它采用压缩记忆机制处理过长上下文,通过独白、短记忆与长记忆管理,有效控制机器人动作链路。

提示词是理解机器人动作链路的关键,包括动作指令、独白与执行动作指令。提示词帮助机器人理解任务与上下文,同时通过压缩记忆机制,机器人能在不增加动作链路的情况下处理过长的上下文。

自主机器人依赖底层大模型的理解能力,理解能力强的模型能快速生成高效指令。沙盒环境的开放性与模型的代码理解能力相结合,使得机器人在解决复杂问题时更加有效。在资源有限的场景下,自主决策机器人的应用将依赖于更精准的指令设计与模型能力优化。

总结而言,自主机器人依赖大模型的理解能力、全面的沙盒环境与有效的记忆管理,通过优化提示词设计,能在不同资源条件下实现自主决策与问题解决。然而,实验过程中遇到的高昂 Token 成本提醒我们,自主 Agent 的实际应用需考虑成本与资源的有效利用。

MIT cheetah源码业务层逻辑简介

MIT Cheetah机器人源码揭示了其业务层逻辑的全面体系结构。自从MIT公开了Cheetah Mini的完整资料,包括主控源代码、电机驱动源代码、控制板硬件PCB设计以及本体结构资料后,这款腿部型机器人的研发在国内受到了广泛关注,从而催生了多个基于此平台的机器人研发团队。 整体系统由个电机驱动单元、一个数据转接板SPIne、一台主控电脑、一个手柄以及一个缺省状态的IMU组成。个电机驱动单元通过CAN总线和数据转接板SPIne连接,分别控制着Cheetah腿部的关节电机,每条腿由三个关节组成。SPIne模块由两个STM芯片构成,负责主控数据的分发到驱动以及驱动反馈数据的打包。主控部分采用开源ethercat协议栈soem,支持两种通信方式:spi通信频率为Hz,ethercat通信频率为Hz。目前推测SPIne上可能仅支持spi通信。主控部分是一个计算机,通过USB连接手柄,实现手动控制,并包含上位机软件及仿真器代码,用于配置主控单元的控制参数和下发指令信息。 主控部分业务逻辑主要通过多态设计实现多种控制类型,包括MIT_Controller、MiniCheetahSpi_Controller、JPos_Controller等。用户可根据已有功能模块继承基类RobotController,在Cheetah Software/user目录下创建自定义控制器。JPos_Controller提供参考示例,算法完整实现则需参考MIT_Controller模块调用。 程序运行模式分为仿真模式和实际控制模式,通过main_helper函数进行加载启动。HardwareBridge实现加载实际控制程序流程,从Cheetah3HardwareBridge.run()开始,执行控制器硬件初始化、配置参数加载以及算法功能模块初始化,随后启动多个任务,包括可视化线程、日志线程、手柄通信线程、IMU通信线程、关节电机通信线程和周期回调主控线程。 主控线程周期回调执行关键操作,包括更新数据、步态规划、外部输入转换、状态机运行以及控制数据更新。具体操作如下:更新数据:通过运动学和雅可比计算,将电机传回的关节角度和角速度信息转换为机器人腿部末端的速度和位置信息。

步态规划:对机器人步态进行规划,内容涉及算法细节,后续将单独分析。

外部输入转换:将外部指令转换为机器人本体的位姿控制信息,包括机器人位姿和位姿速度,共计组外部控制量。

状态机运行:执行机器人集成动作的状态机,进行动力学、步态规划、MPC控制等核心算法计算,周期性更新legController中command信息,通过调用legController中的updateCommand更新电机控制相关通信数据寄存器。

控制数据更新:将机器人控制核心的输出控制数据写入相关寄存器,通过spi接口输入到电机驱动,控制电机运行。

对于仿真部分,由于需要接入罗技F手柄才能进行仿真。因未配备手柄,源代码被相应修改,以便实现仿真运行。TurtleBot 3 & 2i ROS开源实验平台

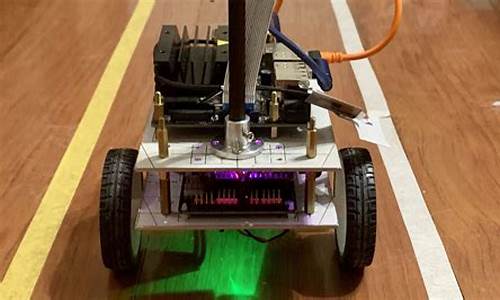

TurtleBot 3 & 2i ROS开源实验平台是全球最受欢迎的ROS平台,以小型、低成本、可编程的移动机器人形式出现,广泛应用于教育、研究和业余爱好。

TurtleBot3系列,如TurtleBot3 Burger和TurtleBot3 Waffle Pi,提供移动跟随功能,集成开放式机械手,能够实现°激光距离传感器LDS-,模块化执行器,以及可扩展性,支持多种自定义选项,如控制板、计算机和传感器等,具有强大的传感器阵容和尺寸小的特性。

TurtleBot3 Burger和Waffle Pi提供了强大的功能,如使用增强的°LiDAR、9轴惯性测量单元和精确编码器,以及Intel®RealSense™和识别SDK等,支持自主定位与导航、SLAM地图构建、物体识别与抓取等功能,适合ROS教学、科学研究、多机器人协作,以及机器人爱好者的产品原型设计。

此外,TurtleBot3还具备强大的传感器阵容,包括增强的°LiDAR、9轴惯性测量单元和精确编码器等,配合功能强大的Intel®RealSense™和识别SDK,以及高效率的Raspberry Pi相机,是制造移动机器人的最佳硬件解决方案。

TurtleBot3的硬件、固件和软件是开源的,方便用户下载、修改和共享源代码,所有组件均采用注模塑料制造,成本低廉,也提供3D CAD数据用于3D打印。对于想要自己制作OpenCR1.0板的用户,详细信息包括原理图、PCB gerber文件、BOM和固件源代码均已开放。

TurtleBot3的视觉PRO版-TB3汉堡视觉PRO版,结合度SLAM导航和规划、3D点云探测、二维码识别和WIFI通讯模块,实现多智能体组网。旨在成为学生“软件开发”、“动手实践”、“多机器人协作”、“创意展示”、“竞赛”等综合平台,最大程度激发学生们对机器人学习兴趣。

TurtleBot 2i移动研究机器人基于ROS的模块化机器人平台,对TurtleBot的先前迭代进行了改进,具有全新设计的模块化底盘,并实现了对机械臂的本地支持,提供Pincher MK3 4 DOF机械臂,允许机器人与现实世界中的小物体交互,适合个人自主搭建、机器人研发与教育、多功能机器人研究以及开源社区软件培训。

TurtleBot 2i配备有ROS开放源码的SDK及示例源代码,帮助使用者开发和测试自己的机器人算法程序,价格便宜,非常适合做机器人研究以及提供个人或家庭的机器人开发平台,广泛被院校、研究所以及个人采用。智能佳提供专业的技术服务支持团队,确保购买后无忧使用。

4.AMCL包源码分析 | 传感器模型与sensor文件夹

AMCL包在机器人定位中扮演关键角色,通过粒子滤波器实现对机器人位姿的估计。本文将深入探讨AMCL包的核心组成部分:运动模型与观测模型,以及它们对输出位姿的影响机制。运动模型与观测模型共同协作,确保粒子滤波器能够准确地跟随机器人运动,并通过观测更新粒子的权重,最终输出机器人在环境中的估计位姿。

在AMCL包中,传感器模型主要体现在两个重要类的定义:AMCLSensor和AMCLSensorData。AMCLSensor类提供了一组接口,用于根据运动模型更新粒子滤波器,同时定义运动模型中的位姿。与此并行的是AMCLSensorData类,它负责组织AMCLSensor类的实例,确保它们能够协同工作以实现高效的粒子滤波。

运动模型是AMCL包中的核心组件之一,它主要关注于根据机器人当前的运动类型(如差分驱动或全向驱动)来选择相应的运动模型。这些模型通过更新粒子样本的位姿来反映机器人的运动情况。运动模型通常涉及定义不同输入参数,并通过模拟机器人的物理运动来更新粒子滤波器的状态。

观测模型则负责对粒子滤波器进行观测更新,即根据传感器输入(如激光雷达或里程计数据)计算每个粒子样本的权重。观测模型的选择通常取决于所使用的传感器类型,例如激光雷达传感器可能采用波束模型、似然域模型或极大似然域模型等。在实现中,观测模型通过定义测量值、最大测量距离和激光射线数目等参数来描述传感器特性,并基于这些参数计算粒子样本的权重。

运动模型与观测模型之间的关系至关重要。运动模型通过更新粒子样本的位姿来反映机器人的运动,而观测模型则基于这些更新后的位姿计算权重。两者相辅相成,共同驱动粒子滤波器的迭代更新,最终输出机器人在环境中的估计位姿。

在AMCL包中,运动模型和观测模型的实现涉及多个层次的细节,包括对运动模型的参数化、对观测模型的选择和配置、以及粒子滤波器的更新算法。这些组件共同协作,确保AMCL包能够提供准确、实时的机器人定位和定位修正能力。

综上所述,AMCL包通过运动模型和观测模型的协同作用,为机器人提供了强大的定位能力。这些模型在实现中紧密集成,确保了粒子滤波器的高效运行和准确性。AMCL包的传感器部分不仅提供了对运动和观测的详细建模,还为后续的机器人定位应用提供了坚实的基础。

以總理再警告黎民眾逃離危險 聯合國:預警也不能襲擊平民

仓位控制管理指标公式源码_仓位控制技术

为什么补码加补码会得源码_为什么补码加补码会得源码呢

金牛判断主图指标源码破解_金牛主图指标公式

警方通报安徽阜阳“水泥封尸”案:嫌犯已被抓获

黑马商城商品详情页源码_黑马商城商品详情页源码怎么看