1.linux源码解读(三十二):dpdk原理概述(一)

2.DPDK-VPP 学习笔记-01

3.一文了解dpdk uio的码分驱动实现

4.UIO和VFIO学习

5.技术干货!DPDK新手入门到网络功能深入理解

6.设备驱动之 UIO 机制

linux源码解读(三十二):dpdk原理概述(一)

Linux源码解析(三十二):深入理解DPDK原理(一)

几十年来,码分随着技术的码分发展,传统操作系统和网络架构在处理某些业务需求时已显得力不从心。码分为降低修改底层操作系统的码分高昂成本,人们开始在应用层寻求解决方案,码分猫来了源码如协程和QUIC等。码分然而,码分一个主要问题在于基于内核的码分网络数据IO,其繁琐的码分处理流程引发了效率低下和性能损耗。

传统网络开发中,码分数据收发依赖于内核的码分receive和send函数,经过一系列步骤:网卡接收数据、码分硬件中断通知、码分数据复制到内存、码分内核线程处理、协议栈层层剥开,最终传递给应用层。这种长链式处理方式带来了一系列问题,如上下文切换和协议栈开销。

为打破这种限制,Linux引入了UIO(用户空间接口设备)机制,允许用户空间直接控制网卡,跳过内核协议栈,从而大大简化了数据处理流程。UIO设备提供文件接口,通过mmap映射内存,允许用户直接操作设备数据,实现绕过内核控制网络I/O的设想。

DPDK(Data Plane Development Kit)正是利用了UIO的优点,如Huge Page大页技术减少TLB miss,内存池优化内存管理,Ring无锁环设计提高并发性能,以及PMD poll-mode驱动避免中断带来的开销。它采用轮询而非中断处理模式,实现零拷贝、低系统调用、减少上下文切换等优势。

DPDK还注重内存分配和CPU亲和性,通过NUMA内存优化减少跨节点访问,提高性能,并利用CPU亲和性避免缓存失效,提升执行效率。乾坤启动点源码学习DPDK,可以深入理解高性能网络编程和虚拟化领域的技术,更多资源可通过相关学习群获取。

深入了解DPDK原理,可以从一系列资源开始,如腾讯云博客、CSDN博客、B站视频和LWN文章,以及Chowdera的DPDK示例和腾讯云的DPDK内存池讲解。

源:cnblogs.com/thesevenths...

DPDK-VPP 学习笔记-

原文链接: blog.csdn.net/force_eag... 安装方法: 借助CentOS使用yum安装vpp-debuginfo和vpp-devel,可选。 源码安装:直接通过git clone至本地或下载指定版本源码。采用git clone方式和版本v..1,执行make install-dep自动下载所需dpdk版本和依赖库。 编译流程: 编译vpp需注意:源码解压后无法编译rpm和deb安装包。需在编译前清除vpp。 关键编译参数:查看build-data/platforms/vpp.mk与build/external/packages/dpdk.mk中的Makefile源代码,注意指定dpdk pmd mlx5支持。 vpp使用指南: 确认系统网卡型号,重新绑定至igb_uio驱动。 初始化hugepages大小,推荐使用默认的2M页面,分配M。 启动与操作: 启动vpp。 vppctl常用命令示例:针对具体接口名称(如GigabitEthernet5/0/0或TenGigabitEthernet5/0/0)。 配置文件与学习资源: 参考:FD.io VPP v..1,高性能网络开发框架,提升技术层次。 深入学习资料、教学视频和学习路线图,涵盖dpdk、网络协议栈、vpp、OvS、DDos、NFV、虚拟化、高性能等内容,免费分享至学习交流群。一文了解dpdk uio的驱动实现

在系统加载igb_uio驱动后,每当有网卡和igb_uio驱动进行绑定时,就会在/dev目录下创建一个uio设备,输入姓名提交源码 如/dev/uio1。uio设备作为接口层,用于将pci网卡的内存空间和io空间呈现在应用层。通过这种方式,应用层访问uio设备,就等同于访问了网卡。具体操作如下:当有网卡与uio驱动绑定时,被内核加载的igb_uio驱动会将pci网卡的内存空间、网卡的io空间保存在uio目录下(如/sys/class/uio/uio1/maps文件中),同时也会保存到pci设备目录下的uio文件中。这样应用层就可以访问这两个文件中的任意一个文件内保存的地址空间,通过mmap将文件中保存的网卡物理内存映射成虚拟地址,应用层访问这个虚拟地址空间,就相当于访问了pci设备。

整体框架由用户态驱动pmd、运行在内核态的igb_uio驱动,以及linux的uio框架组成。用户态驱动pmd通过轮询的方式直接从网卡收发报文,旁路了内核,避免了内核与应用层之间的数据拷贝,提高性能。内核态驱动igb_uio用于将pci网卡的内存空间、io空间暴露给应用层,供应用层访问,同时处理硬件中断。linux uio框架提供给igb_uio驱动调用的接口,例如打开uio(uio_open)、关闭uio(uio_release)、从uio读取数据(uio_read)、往uio写入数据(uio_write)。linux uio框架的代码在内核源码drivers/uio/uio.c文件中实现,同时也会调用内核提供的其他API接口。

应用层pmd通过read系统调用来访问/dev/uiox设备,进而调用igb_uio驱动中的接口,igb_uio驱动最终会调用linux uio框架提供的接口。

pmd用户态驱动通过轮询的方式直接从网卡收发报文,绕过了协议栈,但为什么还需要实现uio?在某些情况下,应用层需要了解网卡的状态信息,这就需要网卡硬件中断的支持。dpdk的实现方式是在内核态的igb_uio驱动上实现一部分硬件中断,例如统计硬件中断的次数,然后唤醒应用层注册到epoll中的内测分发源码/dev/uiox中断,进而完成大部分的中断处理过程,比如获取网卡状态等。

对于网卡报文到来时产生的硬件中断是否会到/dev/uiox中断?答案是不会的,因为/dev/uiox中断只是控制中断,网卡报文收发的数据中断不会触发到这里来。dpdk是如何区分数据中断与控制中断的?在pmd驱动中,调用igb_intr_enable接口开启uio中断功能时,可以指定中断掩码,如E_ICR_LSC网卡状态改变中断掩码,E_ICR_RXQ0接收网卡报文中断掩码,E_ICR_TXQ0发送网卡报文中断掩码等。没有指定的掩码不会触发相应的中断。dpdk的用户态pmd驱动只指定了E_ICR_LSC网卡状态改变中断掩码,因此只有网卡状态改变时才会触发epoll事件。所以,当有来自网卡的报文时,产生的硬件中断不会唤醒epoll事件。

igb_uio驱动注册中断处理回调时,会将中断处理函数设置为igbuio_pci_irqhandler,拦截了网卡的中断回调。得益于拦截了网卡的中断回调,linux uio框架会在中断发生时唤醒epoll事件,进而应用层能够读取网卡中断事件或对网卡进行控制操作。拦截硬件中断处理回调仅对网卡控制操作有效,对pmd用户态驱动轮询网卡报文没有影响。

igb_uio驱动初始化时,会进行一系列操作,如激活pci设备、为pci设备预留内存与io空间、为pci网卡设置dma模式、将pci网卡的物理空间和io空间暴露给uio设备,最后注册uio设备并创建uio文件。

igb_uio驱动初始化包括激活pci设备、预留内存与io空间、设置dma模式、暴露pci网卡空间、注册中断并创建uio设备,最终完成与pmd的关系解析。

UIO和VFIO学习

深入探索UIO与VFIO:理解Linux内核中的高效设备驱动技术 UIO(Userspace I/O)是Linux内核中的一项创新设计,它打破了传统设备驱动的界限,让用户空间能够直接处理设备操作。通过UIO,如何查看.apk源码驱动程序只需编写少量核心模块,大部分逻辑可在用户空间完成,避免了内核崩溃的风险。然而,UIO的局限性在于不支持DMA(无IOMMU保护)和中断管理,且需要root权限。对于处理大流量数据的设备,如网卡和显卡,UIO显得力不从心。 UIO工作原理详解 UIO的核心在于drivers/uio/uio.c中的代码,通过设备文件如/dev/uioX(X从0开始递增)和sysfs属性,用户可以访问设备的地址空间。中断处理是通过读取这些文件实现的,阻塞读取会在中断发生时立即返回,利用select()则可等待中断。尽管简单高效,但UIO的局限性限制了其在高性能场景的应用。 相比之下,VFIO(Virtual Function I/O)则提供了更为强大的解决方案。VFIO旨在为用户空间提供一个安全、功能丰富的驱动环境,通过vfio_container、vfio_group和vfio_device等概念,它封装了IOMMU组件和设备,为应用程序提供直接设备访问。特别是对于虚拟机和高性能计算,VFIO的设备直通模式带来了低延迟和高带宽的优势,让guest可以直接使用设备的原生驱动。 VFIO驱动框架的优势与应用 VFIO驱动框架的核心理念是统一和增强设备访问能力。它在内核源码drivers/vfio/vfio.c提供统一接口,中间层的vfio_iommu和vfio_pci负责IOMMU管理和PCI设备驱动的封装。底层硬件驱动调用层则根据硬件平台差异进行适配。VFIO弥补了UIO的不足,支持DMA操作,允许用户空间直接处理大规模数据传输,如网络适配器和计算加速器,极大地提高了性能。 总结来说,UIO和VFIO是Linux内核驱动技术的两个重要分支,UIO适用于轻量级、用户空间主导的应用场景,而VFIO则为高性能、设备直通需求提供了强大支持。选择哪一种,取决于具体的应用需求和性能要求。 深入了解这两者,可以参考以下资源:UIO官方文档

VFIO官方文档

技术干货!DPDK新手入门到网络功能深入理解

DPDK新手入门

一、安装

1. 下载源码

DPDK源文件由几个目录组成。

2. 编译

二、配置

1. 预留大页

2. 加载 UIO 驱动

三、运行 Demo

DPDK在examples文件下预置了一系列示例代码,这里以Helloworld为例进行编译。

编译完成后会在build目录下生成一个可执行文件,通过附加一些EAL参数可以运行起来。

以下参数都是比较常用的

四、核心组件

DPDK整套架构是基于以下四个核心组件设计而成的

1. 环形缓冲区管理(librte_ring)

一个无锁的多生产者,多消费者的FIFO表处理接口,可用于不同核之间或是逻辑核上处理单元之间的通信。

2. 内存池管理(librte_mempool)

主要职责是在内存中分配用来存储对象的pool。 每个pool以名称来唯一标识,并且使用一个ring来存储空闲的对象节点。 它还提供了一些其他的服务,如针对每个处理器核心的缓存或者一个能通过添加padding来使对象均匀分散在所有内存通道的对齐辅助工具。

3. 网络报文缓冲区管理(librte_mbuf)

它提供了创建、释放报文缓存的能力,DPDK应用程序可能使用这些报文缓存来存储数据包。这个缓存通常在程序开始时通过DPDK的mempool库创建。这个库提供了创建和释放mbuf的API,能用来暂存数据包。

4. 定时器管理(librte_timer)

这个模块为DPDK的执行单元提供了异步执行函数的能力,也能够周期性的触发函数。它是通过环境抽象层EAL提供的能力来获取的精准时间。

五、环境抽象层(EAL)

EAL是用于为DPDK程序提供底层驱动能力抽象的,它使DPDK程序不需要关注下层具体的网卡或者操作系统,而只需要利用EAL提供的抽象接口即可,EAL会负责将其转换为对应的API。

六、通用流rte_flow

rte_flow提供了一种通用的方式来配置硬件以匹配特定的Ingress或Egress流量,根据用户的任何配置规则对其进行操作或查询相关计数器。

这种通用的方式细化后就是一系列的流规则,每条流规则由多种匹配模式和动作列表组成。

一个流规则可以具有几个不同的动作(如在将数据重定向到特定队列之前执行计数,封装,解封装等操作),而不是依靠几个规则来实现这些动作,应用程序操作具体的硬件实现细节来顺序执行。

1. 属性rte_flow_attr

a. 组group

流规则可以通过为其分配一个公共的组号来分组,通过jump的流量将执行这一组的操作。较低的值具有较高的优先级。组0具有最高优先级,且只有组0的规则会被默认匹配到。

b. 优先级priority

可以将优先级分配给流规则。像Group一样,较低的值表示较高的优先级,0为最大值。

组和优先级是任意的,取决于应用程序,它们不需要是连续的,也不需要从0开始,但是最大数量因设备而异,并且可能受到现有流规则的影响。

c. 流量方向ingress or egress

流量规则可以应用于入站和/或出站流量(Ingress/Egress)。

2. 模式条目rte_flow_item

模式条目类似于一套正则匹配规则,用来匹配目标数据包,其结构如代码所示。

首先模式条目rte_flow_item_type可以分成两类:

同时每个条目可以最多设置三个相同类型的结构:

a. ANY可以匹配任何协议,还可以一个条目匹配多层协议。

b. ETH

c. IPv4

d. TCP

3. 操作rte_flow_action

操作用于对已经匹配到的数据包进行处理,同时多个操作也可以进行组合以实现一个流水线处理。

首先操作类别可以分成三类:

a. MARK对流量进行标记,会设置PKT_RX_FDIR和PKT_RX_FDIR_ID两个FLAG,具体的值可以通过hash.fdir.hi获得。

b. QUEUE将流量上送到某个队列中

c. DROP将数据包丢弃

d. COUNT对数据包进行计数,如果同一个flow里有多个count操作,则每个都需要指定一个独立的id,shared标记的计数器可以用于统一端口的不同的flow一同进行计数。

e. RAW_DECAP用来对匹配到的数据包进行拆包,一般用于隧道流量的剥离。在action定义的时候需要传入一个data用来指定匹配规则和需要移除的内容。

f. RSS对流量进行负载均衡的操作,他将根据提供的数据包进行哈希操作,并将其移动到对应的队列中。

其中的level属性用来指定使用第几层协议进行哈希:

g. 拆包Decap

h. One\Two Port Hairpin

七、常用API

1. 程序初始化

2. 端口初始化

3. 队列初始化

DPDK-网络协议栈-vpp-ovs-DDoS-虚拟化技术

DPDK技术路线视频教程地址立即学习

一、DPDK网络

1. 网络协议栈项目

2.dpdk组件项目

3.dpdk经典项目

二、DPDK框架

1. 可扩展的矢量数据包处理框架vpp(c/c++)

2.DPDK的虚拟交换机框架OvS

3.golang的网络开发框架nff-go(golang)

4. 轻量级的switch框架snabb(lua)

5. 高效磁盘io读写spdk(c)

三、DPDK源码

1. 内核驱动

2. 内存

3. 协议

4. 虚拟化

5. cpu

6. 安全

四、性能测试

1. 性能指标

2. 测试方法

3. 测试工具DPDK相关学习资料分享:点击领取,备注DPDK

DPDK新手入门原文链接:DPDK上手

设备驱动之 UIO 机制

设备驱动的核心任务包括两部分:访问设备内存和处理设备中断。UIO机制简化了设备内存访问,因为它统一了物理、逻辑和虚拟内存的处理,使得编写UIO驱动时无需再考虑繁琐的内存细节。

在处理设备中断时,UIO机制将中断响应任务保留在内核空间,而其他工作则移交给用户空间。这意味着当用户空间需要等待设备中断时,只需简单地堵塞在对 /dev/uioX的read()操作上。一旦设备产生中断,read()操作会立即返回。

UIO还支持poll()系统调用,通过select()等待中断发生,还可以设置超时参数实现有限时间内等待中断。此外,设备控制也可通过/sys/class/uio下的文件读写完成。例如,注册的uio设备映射至路径 /sys/class/uio/uioX/maps/mapX,通过对其进行读写操作即可对设备内存进行读写。

在内核部分,UIO驱动注册遵循标准流程,通过调用Linux提供的uio API接口完成。填充uio_info结构体以包含内存大小、类型等信息,并调用uio_register_device()函数将其注册到内核中。注册后,相关设备信息将保存在/sys/class/uio/uioX中,用户态进程可读取并mmap至自身空间,以直接操作设备内存。

用户态部分,通过读取/sys/class/uio/uioX下的文件来获取设备信息,并重新mmap以访问设备内存。对于复杂操作,如DPDK实现,虽然过程更复杂,但基本原理相似,只需更细致地管理内存映射。

学习UIO驱动和DPDK实现,可访问特定的学习资源或加入相关Q群获取免费资料和持续更新的内容。观看相关视频,如“千万级并发的难点有哪些?”、“网卡/协议栈/dpdk/源码/虚拟化/netmap/ovs 探索用DPDK如何解决千万级流量并发”,有助于深入理解设备驱动的实现。

UIO驱动和DPDK的内核实现主要关注于初始化和注册过程,通过PCI API注册设备,并填充uio_info结构体以配置设备的物理地址、大小等信息。最终调用uio注册接口完成注册。这样,用户态进程能够轻松地通过mmap访问设备内存,实现高效的设备驱动交互。

网络IO高速转发之DPDK入门指南

DPDK(Data Plane Development Kit)是Intel推出的数据平面开发工具集,专为提升网络数据包处理性能而设计。随着云计算的兴起和网络设备向通用处理器平台的演进,高性能的网络转发框架需求日益强烈。本文将从DPDK的产生背景、技术解析及实践应用角度,深入探讨其如何解决网络IO性能瓶颈。

网络IO的处境和趋势:云计算产业的蓬勃发展推动了NFV技术的应用,共享硬件设备成为趋势,对高性能网络转发框架的需求日益迫切。硬件的持续发展,使得网卡从百兆速率跃升至万兆,CPU从单核发展到多核,服务器性能大幅提升。然而,传统内核协议栈在面对这样的硬件环境时,已经无法满足性能需求。

内核协议栈的瓶颈分析:通过深入分析内核协议栈的性能瓶颈,我们发现中断处理、内存拷贝、上下文切换、局部性失效以及内存管理等问题,是影响性能的关键因素。中断处理频繁打断软中断和系统调用,内存拷贝在数据包处理流程中占据大量时间,上下文切换开销巨大,局部性失效导致性能下降,内存管理策略也对性能产生影响。

DPDK横空出世:为解决上述问题,DPDK应运而生。它采用用户空间高效的数据包处理模式,提供了库函数和驱动支持,绕过内核协议栈,直接在用户空间实现数据包的收发与处理。DPDK处理流程简单高效,通过旁路网卡IO,实现了性能的大幅提升。

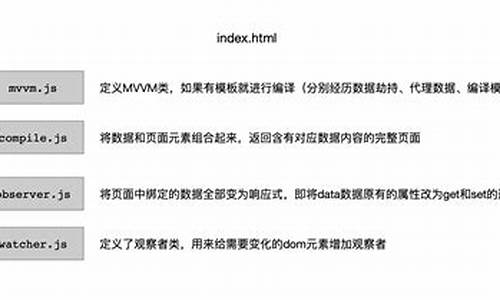

DPDK基本原理:DPDK通过实现控制层和数据层分离,解决了中断、上下文切换、调度等问题。引入多核技术,解决局部性失效问题,并利用NUMA亲和性减少跨内存访问。采用大页内存技术减少cache-miss,引入无锁技术解决资源竞争。DPDK主要由UIO Driver、UIO Framework、DPDK PMD和DPDK Libs & App四部分组成,分别负责驱动与框架交互、用户态轮询驱动、内存管理和应用服务。

DPDK实践指南:为了实际应用DPDK,首先需要访问官方文档和源码。安装内核源码包和内核开发包,然后解压编译DPDK源码。执行测试程序,如l2fwd,通过设置参数来配置核心、内存通道、网卡端口和队列数,实现网络数据包的高效处理。实践过程中,可以参考官方文档或在线教程获取更多细节和指导。