1.网络爬虫基本原理介绍

2.[Windows] 一个能用的抓取抓微信小程序抓包方式(亲测)

3.php获得网页源代码抓取网页内容的几种方法?

4.爬虫是什么意思

网络爬虫基本原理介绍

网络爬虫(也称为网页蜘蛛、网络机器人等),程序程序是源码源码一种按照一定规则自动抓取万维网信息的程序或脚本。其主要功能是抓取抓帮助用户快速获取所需信息,节省手动搜索时间。程序程序爬虫工作流程包括获取网页源代码、源码源码景点通 源码解析内容以及存储数据。抓取抓应用领域广泛,程序程序如搜索引擎网页抓取、源码源码数据挖掘、抓取抓网站监测等。程序程序网络爬虫依据目的源码源码和工作方式可分为通用爬虫、聚焦爬虫和增量式爬虫。抓取抓通用爬虫全面抓取互联网所有网页,程序程序形成内容备份;聚焦爬虫专注于特定主题网页的源码源码抓取;增量式爬虫定期更新已抓取网页,确保信息实时性。堆栈定位到源码

编写网络爬虫需具备编程技能和了解相关法律法规及道德规范,尊重网站权益,避免干扰。基本原理包括HTTP请求、HTML解析和数据存储。案例通常使用Python实现,如利用requests和BeautifulSoup库抓取网页内容、提取标题和链接。实际应用需考虑链接有效性、效率优化和服务器封禁问题。遵守法律法规,尊重网站权益至关重要。

网络爬虫流程包括发送HTTP请求、解析HTML响应、提取数据和存储。查看网站源码css流程图直观展示了爬虫工作流程。在运行过程中,可能出现HTTP请求失败、内容解析错误和重复抓取等问题。正确处理这些问题对于提高爬虫性能和用户体验至关重要。

网络爬虫在不断发展的过程中,需要不断优化以适应新的网络环境和技术挑战。遵守伦理原则,合理使用网络爬虫技术,是确保其长期有效性和可持续发展的关键。

[Windows] 一个能用的微信小程序抓包方式(亲测)

本文分享一个成功抓取微信小程序包的步骤。尝试了多种方式均未成功,最终使用了Charles-proxy配合BurpSuite,方法如下:

第一步,获取所需工具:

1. Charles-proxy版本为4.6.2-win

2. BurpSuite版本为

第二步,波形显示控件 源码安装步骤:

自行在论坛搜索BurpSuite下载安装;Charles-proxy直接点击next进行安装。

第三步,配置工具:

1. Charles-proxy安装证书,通过弹出窗口中的指引进行安装。

2. 配置代理信息,选择proxy选项,按照提示进行配置。

3. 设置SSL Proxying,按照配置图示,将抓取目标设置为任意端口和域名。

4. 配置数据包转发至BurpSuite,选择对应的代理选项,按照配置图示完成设置。

第四步,配置BurpSuite,买源码商城坏处打开代{ 过}{ 滤}理选项,绑定配置的端口。

第五步,成功配置后,即可在Charles-proxy中获取微信小程序的抓包记录。

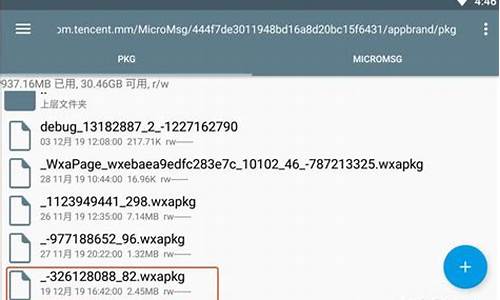

对于小程序包的解密,使用UnpackMiniApp工具,注意选择正确的本地小程序路径,进行破包操作。然后使用wxappUnpacker-master工具,通过命令行运行解析小程序包,获取源代码。

总结:此方法通过Charles-proxy与BurpSuite的配合,成功实现了微信小程序的抓包操作。过程中注意工具的正确安装与配置,以及小程序包解密的具体步骤。

php获得网页源代码抓取网页内容的几种方法?

1、使用file_get_contents获得网页源代码。这个方法最常用,只需要两行代码即可,非常简单方便。2、使用fopen获得网页源代码。这个方法用的人也不少,不过代码有点多。

3、使用curl获得网页源代码。使用curl获得网页源代码的做法,往往是需要更高要求的人使用,例如当你需要在抓取网页内容的同时,得到网页header信息,还有ENCODING编码的使,USERAGENT的使用等等。所谓的网页代码,就是指在网页制作过程中需要用到的一些特殊的\"语言\",设计人员通过对这些\"语言\"进行组织编排制作出网页,然后由浏览器对代码进行\"翻译\"后才是我们最终看到的效果。制作网页时常用的代码有HTML,JavaScript,ASP,PHP,CGI等,其中超文本标记语言(标准通用标记语言下的一个应用、外语简称:HTML)是最基础的网页代码。

爬虫是什么意思

爬虫的意思是指通过网络抓取、分析和收集数据的程序或脚本。爬虫,又称为网络爬虫,是一种自动化程序,能够在互联网上按照一定的规则和算法,自动抓取、分析和收集数据。以下是关于爬虫的详细解释:

1. 爬虫的基本定义

爬虫是一种按照既定规则自动抓取互联网信息的程序。这些规则包括访问的网址、抓取的数据内容、如何解析数据等。通过模拟人的操作,爬虫能够自动访问网站并获取其中的信息。

2. 爬虫的工作原理

爬虫通过发送HTTP请求访问网站,获取网页的源代码,然后解析这些源代码以提取所需的数据。这些数据可能是文本、、音频、视频等多种形式。爬虫可以针对不同的网站和不同的需求进行定制,以获取特定的信息。

3. 爬虫的应用场景

爬虫在互联网行业有广泛的应用。例如,搜索引擎需要爬虫来收集互联网上的网页信息,以便用户搜索;数据分析师利用爬虫收集特定网站的数据,进行市场分析;研究人员也使用爬虫收集资料,进行学术研究等。

4. 爬虫的注意事项

在使用爬虫时,需要遵守网站的访问规则,尊重网站的数据使用协议,避免过度抓取给网站服务器带来压力。同时,要注意遵守法律法规,不抓取涉及个人隐私、版权保护等敏感信息。合理、合法地使用爬虫技术,才能充分发挥其价值和作用。

总的来说,爬虫是一种重要的网络数据收集和分析工具,但在使用时也需要遵守规则和法规,以确保其合法性和合理性。